Meta AI与斯坦福大学联合推出Apollo视频多模态模型

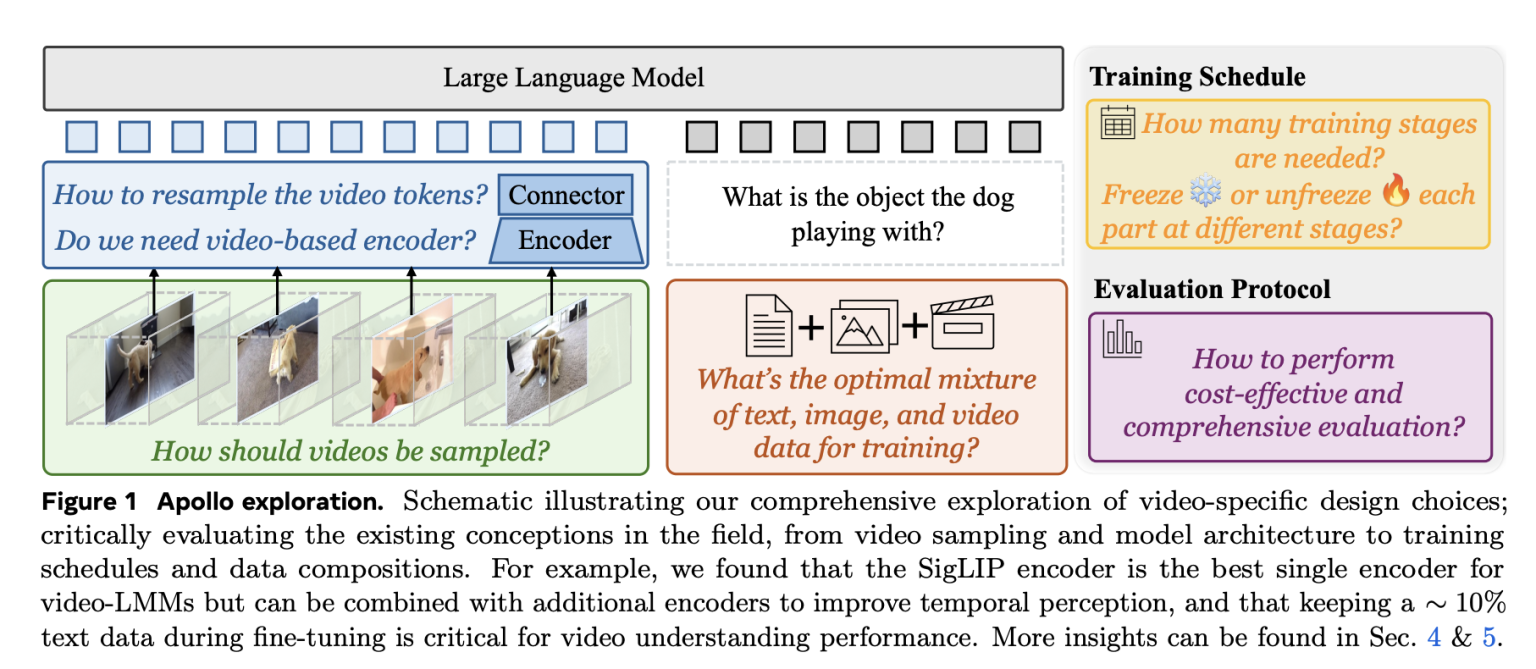

尽管多模态模型(LMM)在文本和图像任务上取得了显著进步,但视频模型的发展却相对滞后。视频结合了复杂的空间和时间维度,需要更多的计算资源来处理。现有的方法通常直接套用基于图像的技术,或依赖于均匀的帧采样,难以有效捕捉动作和时间模式。此外,训练大规模视频模型在计算上代价高昂,难以有效探索设计选择。

为了解决这些问题,Meta AI与斯坦福大学的研究人员联合开发了Apollo视频多模态模型。Apollo旨在推动视频理解的边界,通过审慎的设计决策、提高效率,并为时序推理和基于视频的问答等任务设定新的基准。

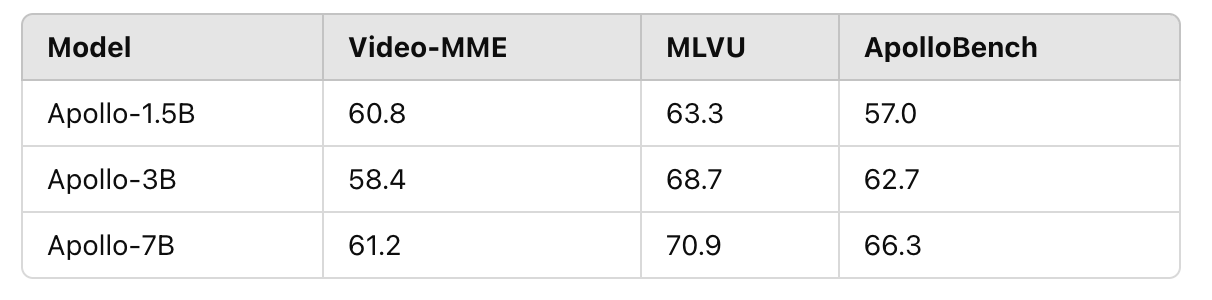

Meta AI推出的Apollo模型系列专注于处理长达一小时的视频,并在关键的视频语言任务上表现出色。Apollo提供三种规模:1.5B、3B和7B参数,以适应不同的计算约束和实际需求。

Apollo的关键创新包括:

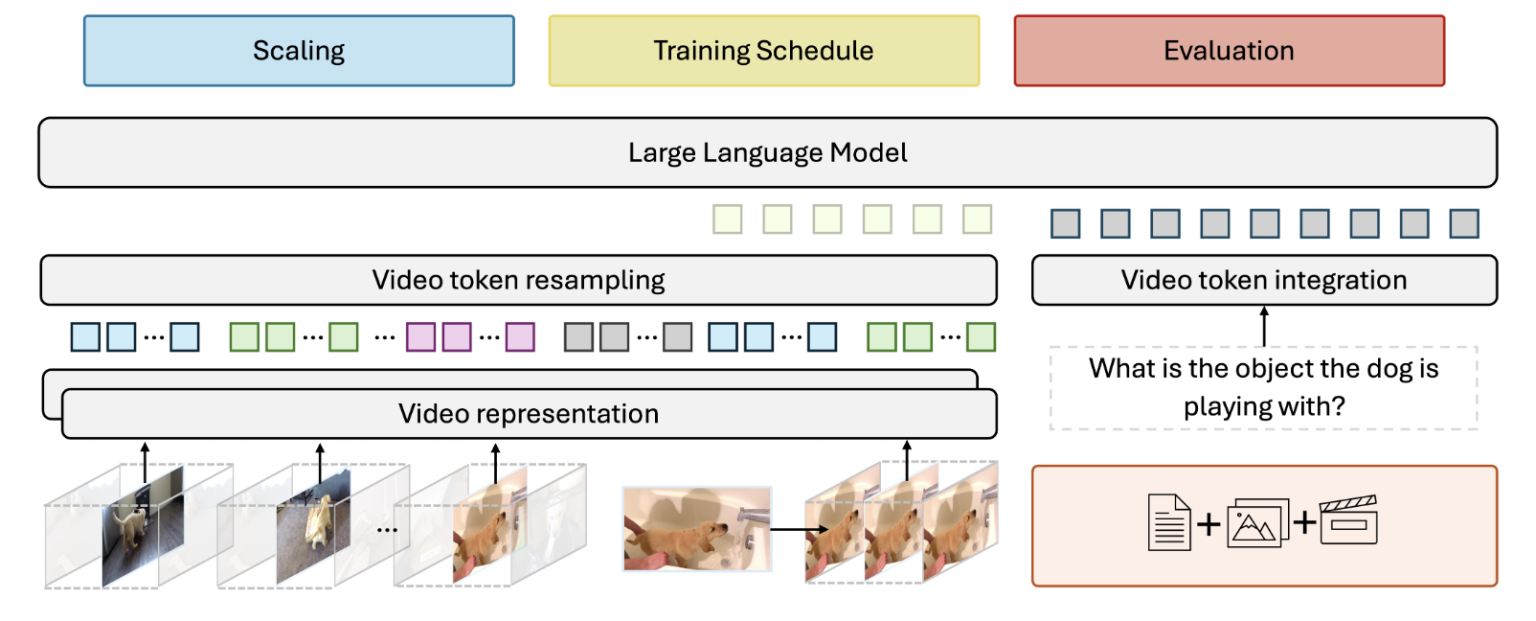

- 规模一致性:设计选择能够从小规模模型有效转移到大规模模型,减少了进行大规模实验的需求。

- 每秒帧(fps)采样:采用更高效的视频采样技术,确保更好的时间一致性,优于均匀帧采样。

- 双重视觉编码器:结合擅长空间理解的SigLIP和增强时间推理的InternVideo2,实现平衡的视频数据表示。

- ApolloBench基准套件:经过精心策划,减少了评估中的冗余,提供了关于模型性能的详细见解。

Apollo模型的技术亮点和优势包括:

- 每秒帧采样:保持一致的时间流,使Apollo能够更好地理解视频中的动作、速度和事件顺序。

- 规模一致性:实验表明,中等规模模型上的设计选择能够很好地推广到较大模型,降低了计算成本,同时保持了性能提升。

- 双重视觉编码器:两个互补的编码器综合优势产生了更准确的视频表示。

- 令牌重采样:通过Perceiver Resampler,Apollo可以高效地减少视频令牌而不丢失信息,处理长时间视频而不产生过多计算开销。

- 优化训练:采用三阶段训练过程,确保稳定且有效的学习。

- 多回合对话:支持基于视频内容的交互式多回合对话,适用于视频聊天系统或内容分析等应用。

Apollo的性能在多个基准测试上得到了验证,往往超过了规模更大的模型。例如,Apollo-1.5B超过了Phi-3.5-Vision(4.2B)和LongVA-7B等模型;Apollo-3B竞争并超越了许多7B模型;Apollo-7B则与拥有超过30B参数的模型(如Oryx-34B和VILA1.5-40B)相匹敌甚至超越它们。

Apollo系列为现实世界的应用提供了实用的解决方案,从基于视频的问答到内容分析和交互式系统等。Meta AI推出的ApolloBench基准套件提供了更简洁和有效的评估视频LMM的方法,为未来的研究铺平了道路。

总之,Apollo标志着视频LMM发展的重大进展。通过解决高效视频采样和模型可扩展性等关键挑战,Apollo为理解视频内容提供了实际而强大的解决方案。其优于更大规模模型的能力凸显了深入研究设计和训练策略的重要性。