【指南】如何使用Phi-4 GGUF

微软的Phi-4是一个先进的语言模型,最近已推出 GGUF 格式,允许本地部署和使用。本文将引导你在自己的计算机上设置和使用Phi-4 GGUF,使你能够利用其能力完成各种自然语言处理任务。

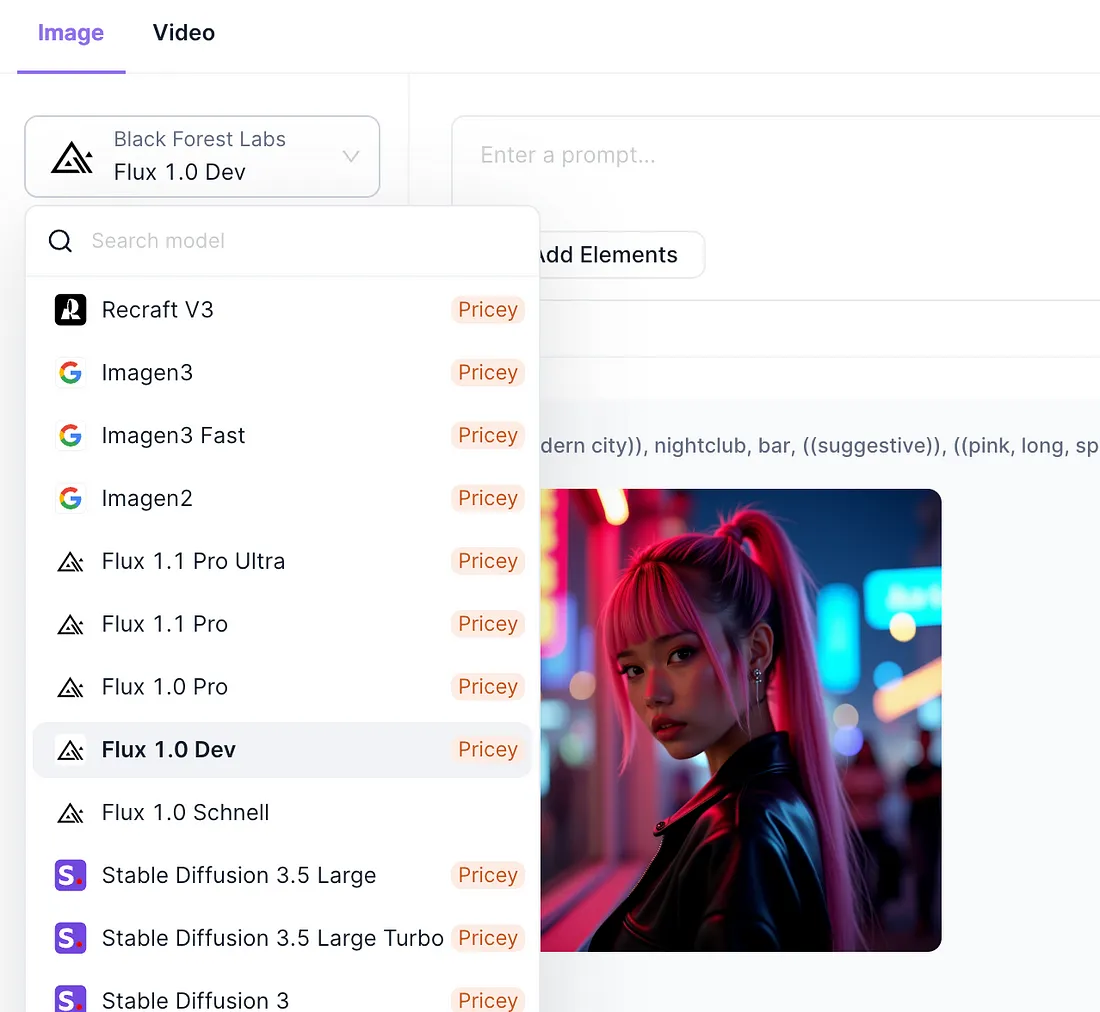

如果你正在寻找一个一站式AI平台,该平台能够统一管理你所有的AI订阅,包括:

- 几乎任何大型语言模型(LLM),如:Claude 3.5 Sonnet、Google Gemini、GPT-40和GPT-o1、Qwen模型及其他开源模型。

- 你甚至可以使用未经审查的Dolphin Mistral和Llama模型!

- 最佳的AI图像生成模型,如:FLUX、Stable Diffusion 3.5、Recraft,

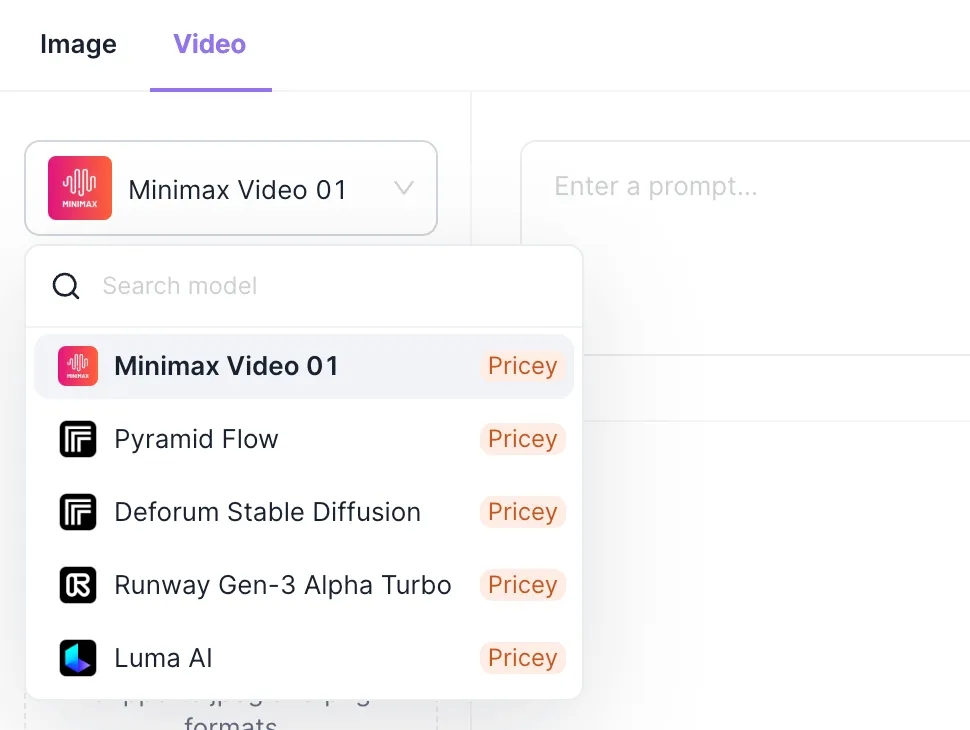

你甚至可以使用AI视频生成模型,如Minimax、Runway Gen-3和Luma AI,以及Anakin AI。

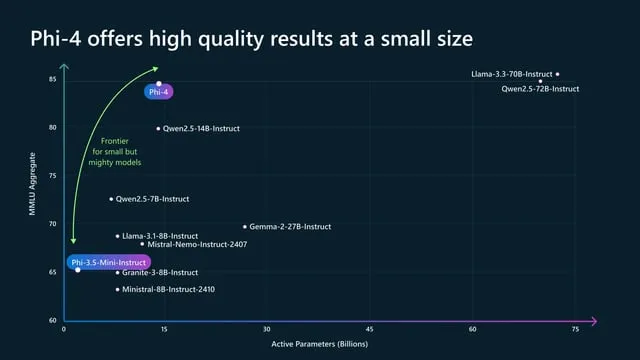

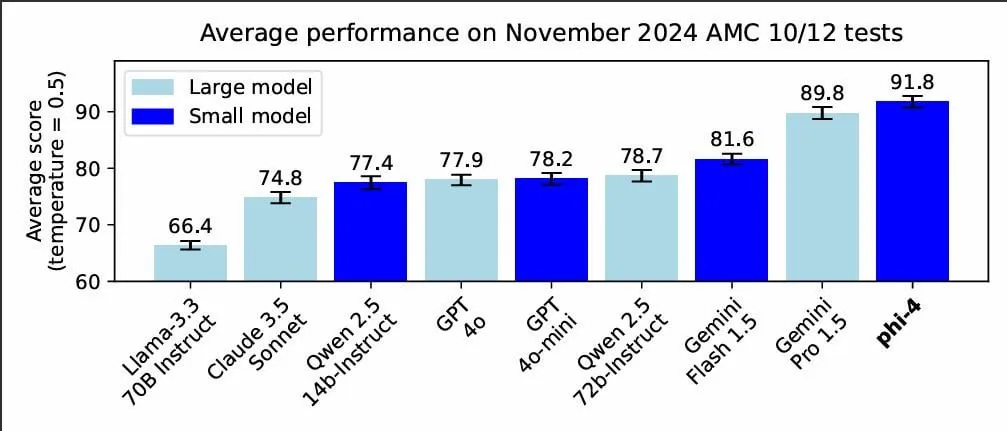

Phi-4:小巧而强大

Phi-4是微软Phi系列语言模型的最新迭代。它代表了人工智能技术的一次重大进步,旨在以更高的效率和准确性处理广泛的语言任务。GGUF(GPT生成的统一格式)是一种文件格式,针对在消费级硬件上高效加载和推理大型语言模型进行了优化。

Phi-4的关键特性:

- 先进的自然语言理解能力

- 改进的上下文保留能力

- 在各种自然语言处理任务上的性能提升

GGUF格式的优点:

- 减少内存占用

- 更快的加载时间

- 针对消费级硬件进行了优化

下载Phi-4 GGUF

要开始使用Phi-4 GGUF,你首先需要下载模型文件。目前,通过一个社区成员的Hugging Face存储库可以获取到非官方版本。

下载步骤:

- 访问Hugging Face存储库:https://huggingface.co/matteogeniaccio/phi-4/tree/main

- 选择适合你需求的量化选项(Q8_0、Q6_K或f16)

- 下载所选的模型文件

设置环境

在运行Phi-4 GGUF之前,你需要设置环境并安装必要的工具和依赖项。

所需软件:

- Python 3.7或更高版本

- Git(用于克隆存储库)

- 兼容的推理引擎(例如,llama.cpp或Ollama)

安装步骤:

- 如果尚未安装,请从官方网站安装Python

- 如果你的系统上没有Git,请从git-scm.com安装

- 选择并安装一个推理引擎(详细步骤见下文)

使用llama.cpp运行Phi-4 GGUF

llama.cpp是一个流行的推理引擎,用于在本地运行大型语言模型。以下是如何设置它以与Phi-4 GGUF一起使用的步骤:

设置llama.cpp:

克隆llama.cpp存储库:

git clone https://github.com/ggerganov/llama.cpp.git\

导航到克隆的目录:

cd llama.cpp

构建项目:

make

使用llama.cpp运行Phi-4:

将你下载的Phi-4 GGUF文件放置在models目录中

使用以下命令运行模型:

./main -m models/phi-4-q8_0.gguf -n 1024 --repeat_penalty 1.1 --temp 0.1 -p "Your prompt here"

根据你的具体使用场景调整所需参数。

使用Ollama部署Phi-4 GGUF

Ollama是另一个出色的本地运行语言模型的工具,它提供了更加用户友好的界面。

安装Ollama:

- 访问https://ollama.ai/,并根据你的操作系统下载相应版本。

- 按照网站上提供的安装说明进行操作。

在Ollama中运行Phi-4模型:

创建一个名为Modelfile的模型文件,内容如下:

运行以下命令来测试模型:

ollama run vanilj/Phi-4

结论

Phi-4 GGUF标志着在使高级语言模型能够进行本地部署方面迈出了重要一步。通过遵循本文,你现在应该已经掌握了下载、设置和使用Phi-4 GGUF进行各种自然语言处理任务的方法。