阿里通义千问Qwen团队发布开放参数解决方案QvQ模型

在人工智能(AI)研究领域,多模态推理——即处理和整合来自文本、图像、视频等多种数据源信息的能力——一直被视为一项极具挑战性的任务。尽管近年来取得了一些进展,但许多模型在上下文准确性和高效的跨模态理解方面仍面临诸多困难。这些挑战主要源于规模限制、数据集狭窄聚焦以及对高级模型访问受限等问题,阻碍了更通用和包容性AI系统的开发。

然而,随着Qwen团队发布专为多模态推理设计的开放参数模型QvQ,这一领域迎来了重大突破。QvQ模型基于Qwen2-VL-72B,集成了多项增强跨模态推理的架构改进,旨在解决当前多模态AI系统面临的诸多挑战。

QvQ的架构是量身定制的,旨在高效且精确地处理复杂的多模态推理任务。它采用分层结构,巧妙地将视觉和语言信息相结合,同时保留上下文中的细微差别。这种设计不仅确保了计算资源的有效利用,还提高了模型的准确性。此外,QvQ的文本和视觉输入对齐机制基于先进的Transformer架构,能够实现高度准确的跨模态嵌入,进一步提升了模型的性能。

值得一提的是,QvQ模型拥有720亿参数,具备良好的可扩展性,能够轻松应对大型和多样化的数据集。其开放参数特性更是为研究人员提供了极大的便利,使他们能够根据具体应用领域进行定制。这种灵活性使得QvQ成为应对特定领域挑战的宝贵资源,为AI技术的广泛应用奠定了坚实基础。

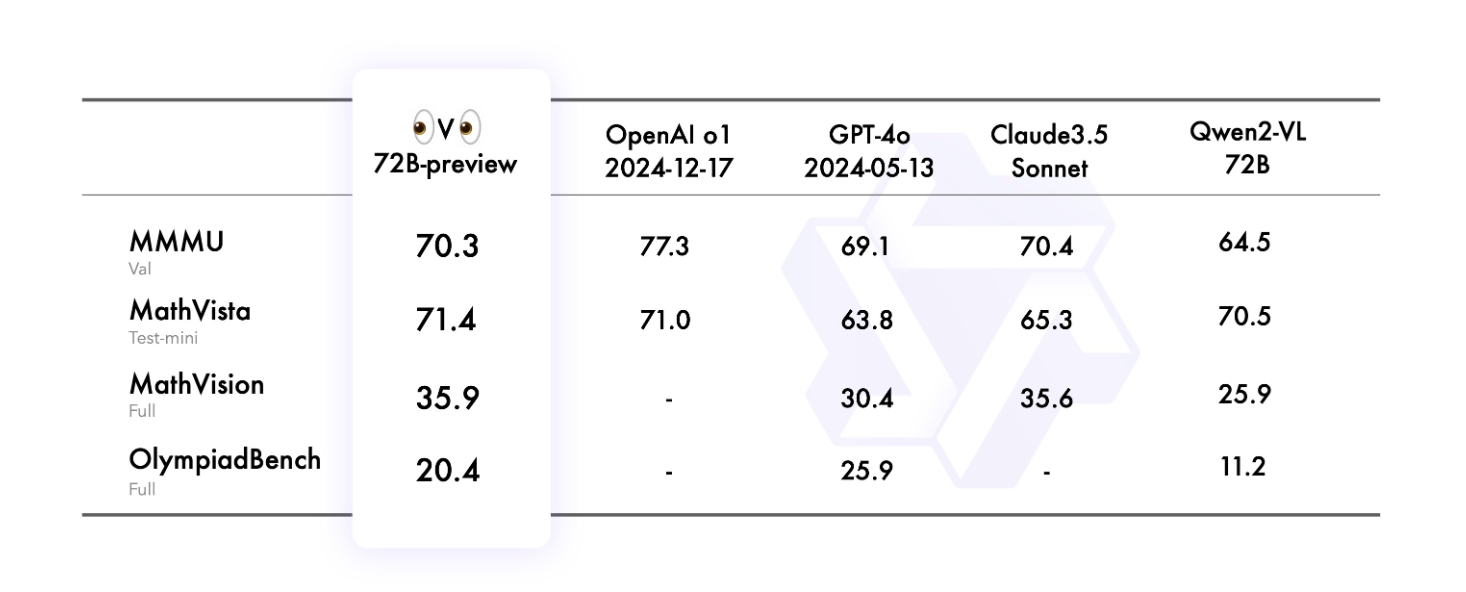

初步评估结果显示,QvQ在多模态推理的关键基准上表现出色。在Visual7W、VQA等数据集上,QvQ取得了显著成果,充分展示了其处理和响应复杂视觉查询的能力。这些成果不仅证明了QvQ在Qwen2-VL-72B优势基础上的进一步增强,也彰显了其在多模态推理领域的领先地位。

除了卓越的性能外,QvQ模型还具备强大的泛化能力。与需要针对每个新任务进行大量微调的模型不同,QvQ在各种场景中均能高效执行,仅需最少的调整。这一特性使得QvQ成为多模态推理领域的通用工具,具有广泛的适应性和应用潜力。

Qwen团队表示,QvQ模型的发布标志着在开发先进的多模态AI系统方面迈出了重要一步。通过应对关键挑战并提供可扩展的开放参数解决方案,Qwen团队为合作与创新提供了有力支持。QvQ模型结合了稳健的技术特性和高度的可访问性,将成为研究人员和实践者的宝贵工具。

随着QvQ模型应用的不断拓展,我们有理由相信,它将在多个领域做出重要贡献,进一步提升AI在多模态推理及其他方面的能力。