腾讯研究院发布DRT-o1系列模型,革新文学作品翻译

近日,腾讯研究院正式推出了全新的DRT-o1系列模型,该模型通过引入长思维链(CoT)技术,显著提升了文学作品翻译的质量,特别是在处理比喻和隐喻等复杂修辞手法时,展现出卓越的性能。

项目背景

尽管神经机器翻译(NMT)在日常文本翻译领域已取得显著成果,但在面对文学作品中的比喻、明喻等修辞手法时,仍面临巨大挑战。这些修辞手法通常蕴含深厚的文化和语境含义,简单的直译难以准确传达其内涵。腾讯研究院此次推出的DRT-o1模型,正是为解决这一难题而生。

项目介绍

为了训练DRT-o1模型,研究人员从古腾堡计划中精心选取了400本公共领域的英文书籍,并从中提取了577,600个句子。经过严格筛选,最终选定了63,000个包含明喻和隐喻的句子作为训练数据,旨在让模型学会“深度思考”。

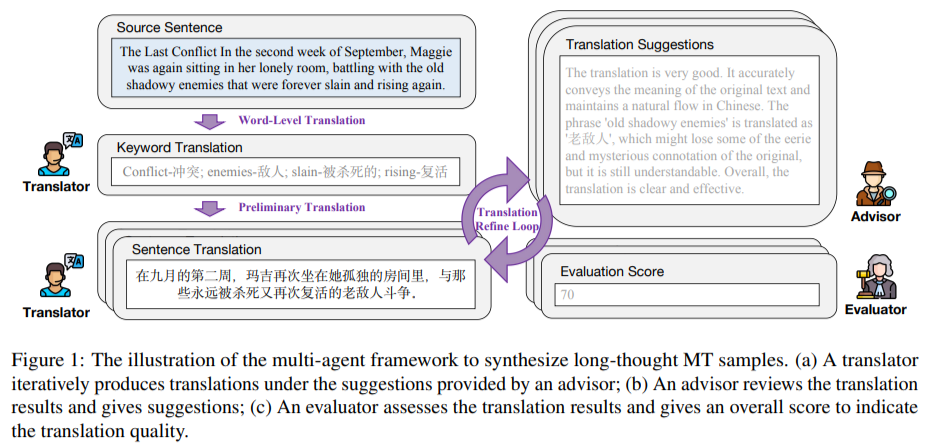

DRT-o1模型采用了创新的多智能体框架,包括翻译员、顾问和评估员三个角色。翻译员负责初步翻译,顾问则提供修改建议,而评估员则根据预设指标对翻译质量进行评分。通过这三个角色的协同工作,模型能够不断迭代优化,提升翻译质量。

工作流程方面,DRT-o1模型分为关键词翻译、初步翻译和翻译精炼循环三个主要步骤。在精炼循环中,顾问会对前一步的翻译进行评估并提供反馈,评估者则根据预定义的评分标准给出整体评分。翻译者根据反馈和评分不断调整翻译,直到评分达到预定义阈值或迭代次数达到最大值。

最终,翻译结果还会经过GPT-4o的润色,确保翻译文本的流畅性和可读性。整个数据集包含了22,264个经过深度思考的机器翻译样本。

实例展示

以一句原文为例:“The mother, with her feet propped up on a stool, seemed to be trying to get to the bottom of that answer, whose feminine profundity had struck her all of a heap.”其中的“struck her all of a heap”是一个成语,表示某事对她产生了强烈影响。DRT-o1模型通过长链思考过程,将其翻译为:“母亲将双脚搭在凳子上,似乎在努力探究那个答案,那答案中女性特有的深刻性令她猛然心生震撼。”这一翻译不仅准确传达了原文的意思,还保留了原文的情感色彩。

相比之下,谷歌翻译和DeepL的翻译虽然也能传达基本意思,但在情感表达和细腻度上略显不足。

性能表现

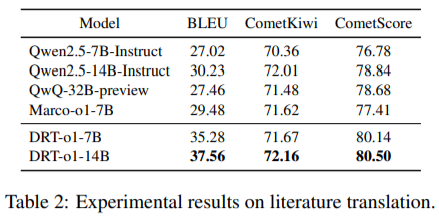

DRT-o1系列模型共有两个规模版本:DRT-o1-7B和DRT-o1-14B。实验结果表明,与Qwen2.5系列模型相比,DRT-o1模型在BLEU分数和CometScore上均有显著提升。其中,DRT-o1-7B的BLEU分数提高了8.26分,CometScore提高了3.36分;DRT-o1-14B的BLEU分数提高了7.33分,CometScore提高了1.66分。值得一提的是,DRT-o1-7B的性能甚至超过了更大的QwQ-32B模型,BLEU分数高出7.82分,CometScore高出1.46分,充分展示了其在处理复杂语言结构方面的强大能力。

腾讯研究院表示,DRT-o1系列模型的推出,标志着文学作品翻译领域的一次重要革新。未来,他们将继续优化和完善模型,为文学作品的跨文化交流提供更加优质的翻译服务。