DeepSeek-V3以低成本实现前沿AI性能

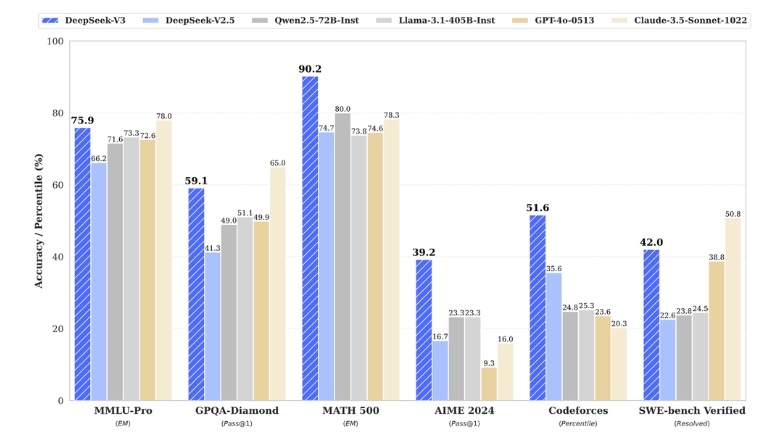

DeepSeek近日发布了其最新大型语言模型DeepSeek-V3。据其公布的基准测试结果,该模型已成为目前最强大的开源大型语言模型。令人瞩目的是,尽管其训练成本仅为560万美元,远低于大型科技公司通常的投入,但其性能却能与领先的非开源模型相媲美。

DeepSeek-V3的训练仅使用了280万GPU小时,成本约为560万美元,远低于竞争对手。在各种基准测试中,该模型的性能与GPT-4和Claude 3.5相当,尤其在数学和编程任务上表现出色。其高效性得益于创新的架构和训练技术,包括一种名为“无辅助损失负载均衡”的新型训练方法。

值得注意的是,DeepSeek作为一家规模较小的初创企业,能够在有限的预算下取得这一成就。OpenAI的创始成员Andrej Karpathy在社交媒体上表示,DeepSeek以极低的预算训练出前沿水平的大型语言模型,并开源其权重,这看似轻而易举。据悉,DeepSeek完全依靠其对冲基金业务自筹资金,未寻求任何外部投资。

DeepSeek-V3的技术核心是采用混合专家(Mixture-of-Experts,MoE)架构,总参数达6710亿,但每个标记仅激活370亿参数。这种选择性激活方法与创新训练技术的结合,使模型在保持高效的同时实现了高性能。特别是在数学推理和编程任务上,DeepSeek-V3有时甚至超越了OpenAI和Anthropic等业界领先者。

DeepSeek表示,他们采用了FP8混合精度训练和高效的管道并行性等技术,显著降低了计算需求。相比之下,Meta的LLaMA 3模型训练需要约3080万GPU小时。这意味着DeepSeek-V3在训练效率上比LLaMA 3高出约11倍。

考虑到当前一些最大的AI训练集群使用约10万个GPU,训练成本可能高达数十亿美元,DeepSeek-V3的成就更加引人注目。该模型仅使用2048个H800 GPU在大约两个月内完成训练,表明高效的架构和训练方法能够显著减少前沿AI开发所需的资源。

然而,DeepSeek-V3的成功也引发了一些争议。有人质疑其训练数据是否包含来自专有模型(如GPT-4或Claude 3.5 Sonnet)的数据。如果属实,这将违反服务条款协议,即所谓的“ToS洗钱”。

尽管如此,DeepSeek-V3在Hugging Face平台上的开源发布仍符合行业推动AI能力民主化的广泛趋势。其无辅助损失负载均衡策略和多标记预测(MTP)技术为训练效率和推理速度设立了新的基准。

对于AI行业而言,DeepSeek-V3可能预示着大型语言模型开发方式的潜在范式转变。这一成就表明,通过巧妙的工程设计和高效的训练方法,可能无需以前认为所需的大规模计算资源就能实现前沿的AI能力。

随着行业对这些发展的消化,DeepSeek-V3的成功可能会促使人们重新评估现有的AI模型开发方法。随着开源模型与非开源模型之间的差距不断缩小,公司可能需要在日益激烈的竞争环境中重新评估其战略和价值主张。