Meta发布HOT3D数据集,推动手物交互的计算机视觉研究

尽管人类天生擅长使用双手与他人交流或抓取操作物体,但现有的多数机器人系统仅擅长执行简单的手动任务。近年来,全球计算机科学家一直在开发基于机器学习的模型,这些模型能够处理人类完成手动任务的图像,并利用获取的信息改进机器人的操作能力,从而可能增强机器人与周围人类和物体的交互。

类似模型还可用于创建依赖计算机视觉的人机界面,或扩展增强现实(AR)和虚拟现实(VR)系统的功能。为了训练这些机器学习模型,研究人员需要访问包含人类完成各种现实手动任务标注视频的高质量数据集。

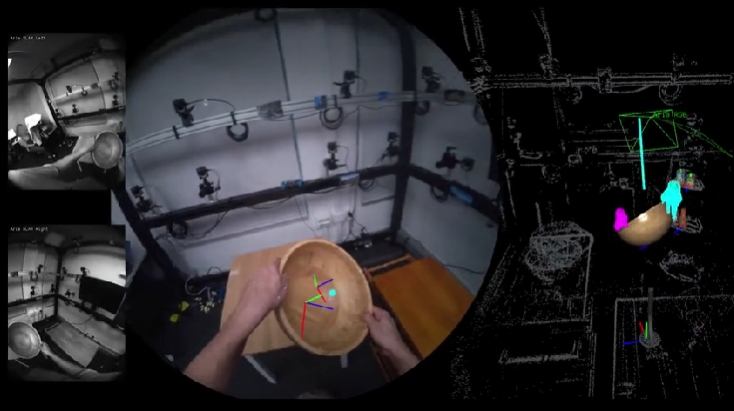

Meta Reality Labs的研究人员最近推出了HOT3D,这是一个新数据集,有助于加速分析手物交互的机器学习研究。该数据集在arXiv预印本服务器上发布的一篇论文中进行了介绍,包含从第一人称视角(即执行任务者所看到的视角)拍摄的人类用户抓取和操作各种物体的高质量第一人称3D视频。

HOT3D数据集包含超过833分钟(超过370万张图像)的多视图RGB/单色图像流,展示了19名受试者与33种不同刚性物体的交互,以及多模态信号,如眼神注视或场景点云,以及全面的真实值标注,包括物体、手和相机的3D姿态,以及手和物体的3D模型。

Meta Reality Labs团队编译的新数据集包含人类简单抓取、观察物体并将其放回表面的演示,也包含更复杂的演示,展示了用户在办公室和家庭环境中常见的动作,如拿起和使用厨房用具、操作各种食物、在键盘上打字等。

数据集中包含的标注视频是使用Meta开发的两种设备收集的,即Project Aria眼镜和Quest 3头戴设备。Project Aria眼镜是专为增强现实应用打造的原型轻质感应眼镜,能够捕捉视频和音频数据,同时跟踪佩戴者的眼球运动,并收集其视野内物体的位置信息。Quest 3是用于收集数据的第二种设备,是Meta开发的商用虚拟现实头戴设备。

研究人员通过专业动作捕捉系统获取真实值姿态,该系统使用附着在手和物体上的小型光学标记。手的标注以UmeTrack和MANO格式提供,物体则由内部扫描仪获得的具有物理基渲染(PBR)材料的3D网格表示。

为评估HOT3D数据集在机器人学和计算机视觉研究中的潜力,研究人员使用它训练了三个不同任务的基线模型。他们发现,与在捕捉单一视角的演示上训练的模型相比,这些模型在HOT3D中包含的多视图数据上训练时表现显著更好。

HOT3D数据集是开源的,全球研究人员可在Project Aria网站上下载。未来,它可能有助于人机界面、机器人和其他基于计算机视觉的系统的开发与进步。