Patronus AI开源Lynx,一种实时基于LLM的AI幻觉判断工具

Patronus AI公司,一家为企业提供工具以评估其人工智能模型可靠性的初创公司,今天宣布推出一款强大的新“幻觉检测”工具,可以帮助公司识别其聊天机器人何时出现异常。

公司表示,这款名为Lynx的新模型在AI可靠性领域取得了重大突破,使企业能够在无需手动标注的情况下检测AI幻觉。

在AI行业中,“幻觉”一词用于描述大型语言模型生成的那些看似连贯但与事实不符的回应。当LLM不知道如何回应用户的提示或问题时,它们往往会即兴编造内容,这种幻觉对于依赖AI模型准确回应客户查询的公司来说可能是危险的。

AI幻觉在过去引发了很多争议,最近的一个例子是谷歌公司的实验性“AI概览”功能,据报道曾建议一位用户“用胶水”来防止自制披萨上的奶酪掉落。在另一个事件中,当被问及如何最好地清洗洗衣机时,它提供了一种本质上是芥子气的配方,称这是完成工作的最佳方法。

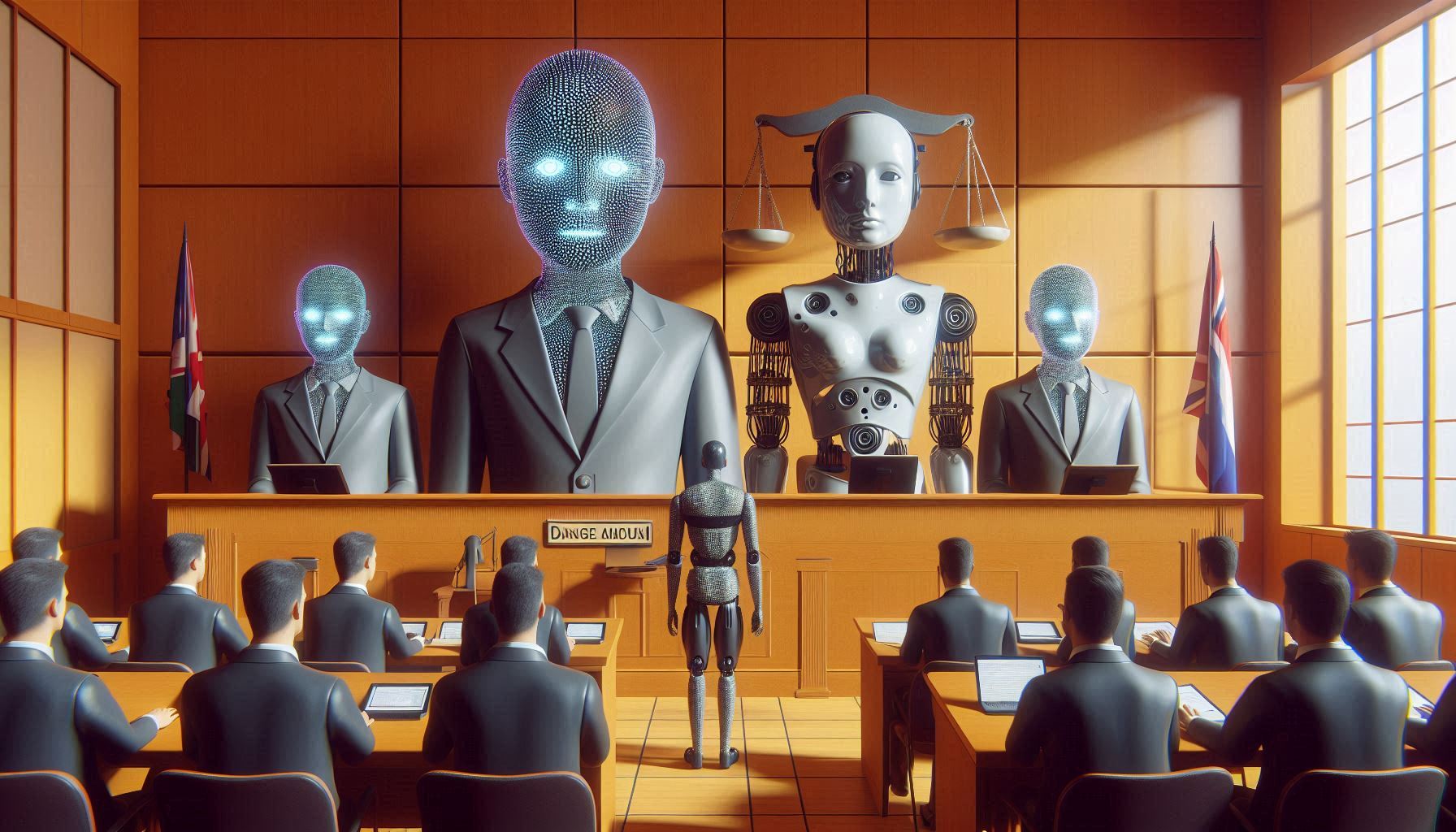

一些AI公司通过使用AI本身来检测幻觉来应对AI幻觉的问题。例如,OpenAI已调整GPT-4(为ChatGPT提供动力)以检测传奇聊天机器人的回应中的不一致性,这一概念被称为“LLM作为法官”。但人们仍然对这些解决方案的准确性表示担忧。

Patronus AI专注于AI可靠性。该公司两个月前筹集了1700万美元的资金,创建了一个使用AI生成所谓“对抗性提示”的平台,旨在测试LLM的可靠性,通过试图诱使它们生成幻觉。

据这家初创公司称,Lynx代表了AI幻觉检测的“最先进”水平,使开发者能够实时识别不当回应。除了Lynx,它还开源了一个名为HaluBench的新基准,该基准来自真实世界领域,用于评估LLM回应的忠实度。

Patronus AI表示,使用HaluBench对Lynx的性能进行了彻底评估,发现其在检测幻觉方面显著优于GOT-4。Lynx的最大700亿参数版本展示了最高的准确性,击败了许多其他被测试的LLM作为法官。Patronus AI声称这是目前最强大的幻觉检测模型。

公司解释说,HaluBench旨在测试AI模型在特定领域(如医疗、医学和金融)中的幻觉,使其更适用于真实世界的用例。

Patronus AI的基准结果样本显示,Lynx(70B)在检测医疗不准确性方面比GPT-4o高出8.3%。同时,较小的Lynx(8B)模型在所有HaluBench领域中比旧的GPT-3.5高出24.5%。同样,它比Anthropic PBC的Claude-3-Sonnet高效8.6%,比Claude-3-Haiku高效18.4%。此外,Lynx还优于开源LLM,如Meta Platforms Inc.的Llama-3-8B-Instruct。

Patronus AI首席执行官Anand Kannappan表示,幻觉是AI行业面临的最关键挑战之一。研究支持这一说法,最近的数据表明,所有LLM回应中有3%到10%是不准确的。

AI幻觉可以采取多种不同形式,从泄露的训练数据到表现出偏见和陈述明显的谎言,Kannappan表示,这些是Lynx旨在解决的问题。虽然他不声称它可以永久解决AI幻觉,但它可以成为开发者衡量其LLM开始输出不准确信息可能性的有价值工具。

“LLM开发者可以使用[Lynx和HaluBench]来衡量其微调LLM在特定领域场景中的幻觉率”他解释道。