【指南】使用LlamaIndex构建你的首个RAG应用程序

在本文中,我们将探索如何使用 LlamaIndex 构建检索增强生成 (RAG) 应用程序, LlamaIndex是一个创新框架,可帮助你构建大型语言模型 (LLM) 支持的应用程序。

了解人工智能应用程序开发的复杂性

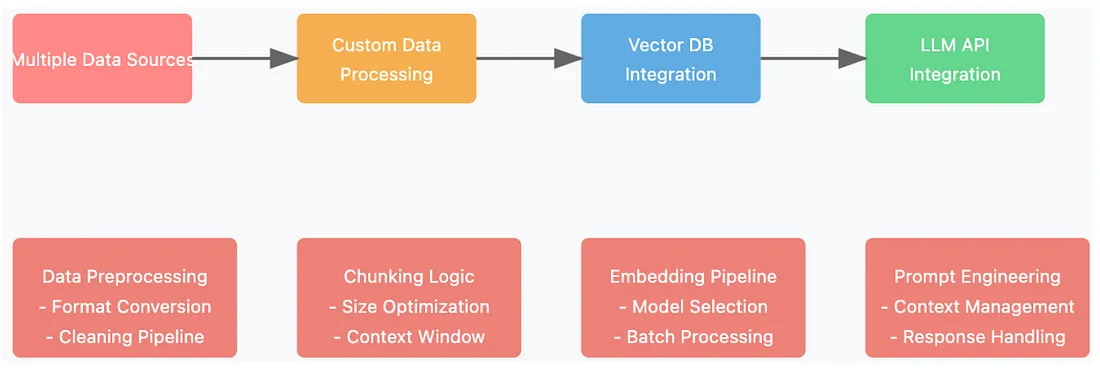

构建人工智能(AI)应用本身是一项复杂的任务。它涉及整合多个数据源、管理数据流,并确保每个组件都能无缝协同工作。从数据收集到模型训练,每一步都需要专业知识和相当大的努力。

这一过程始于数据预处理,包括清理和组织数据,使其适用于模型训练。接下来是模型评估、部署和持续监控,这些步骤都带来了额外的挑战。

行业中的技能缺口进一步加剧了这一过程的复杂性,因为开发人员不仅要克服技术障碍,还要应对专业人才的短缺。因此,对于任何希望创建稳健应用的人来说,理解AI开发的多方面特性至关重要。

大型语言模型(LLM)在AI中的作用

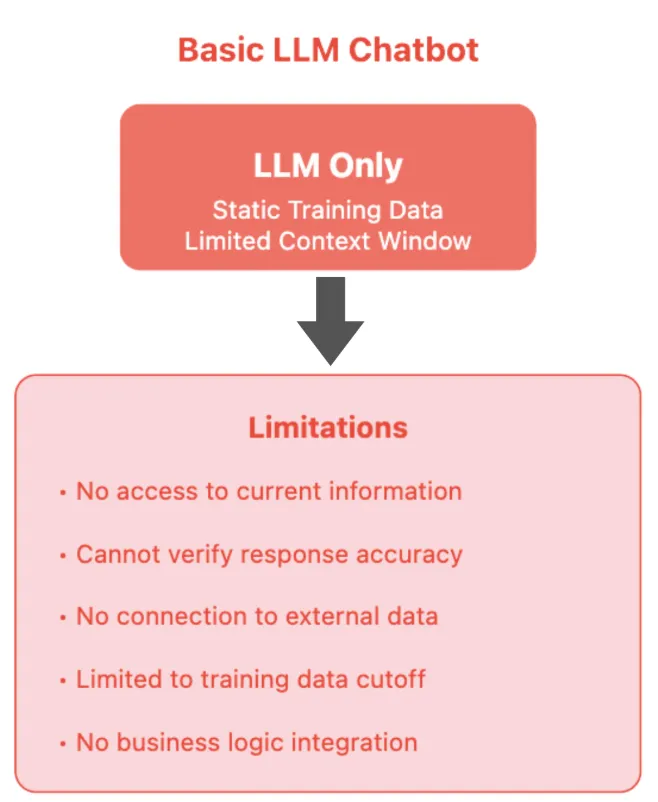

大型语言模型(LLM)在AI应用开发中发挥着关键作用。然而,它们并不是一揽子解决方案。虽然LLM在文本生成和理解方面提供了强大的功能,但为了实现有效的AI应用性能,它们必须与其他组件集成。

大型语言模型(LLM)能够根据预定义的训练数据生成响应,但它们往往缺乏访问实时信息或验证其输出准确性的能力。这一限制可能导致响应中的不准确性和缺乏上下文相关性。

为了构建能够思考、推理并生成准确响应的应用程序,开发人员必须超越LLM,并融入额外的框架和技术,如LlamaIndex。

LlamaIndex简介

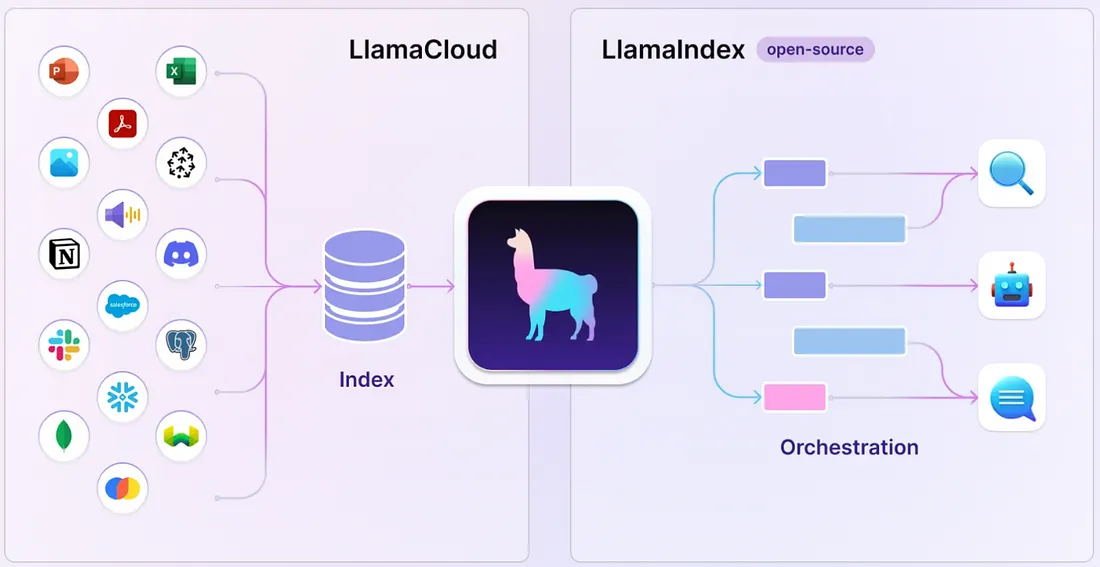

LlamaIndex,前称GPT Index,是一个专为利用LLM构建应用程序而设计的创新数据框架。它充当了基本LLM功能与企业所需的更复杂集成应用程序之间的桥梁。

这个框架使开发人员能够连接自己的数据源,从而实现实时数据访问和响应验证。通过集成LlamaIndex,开发人员可以增强大型语言模型(LLM)的功能,使它们在实际应用中更具适应性和有效性。

LlamaIndex的发展

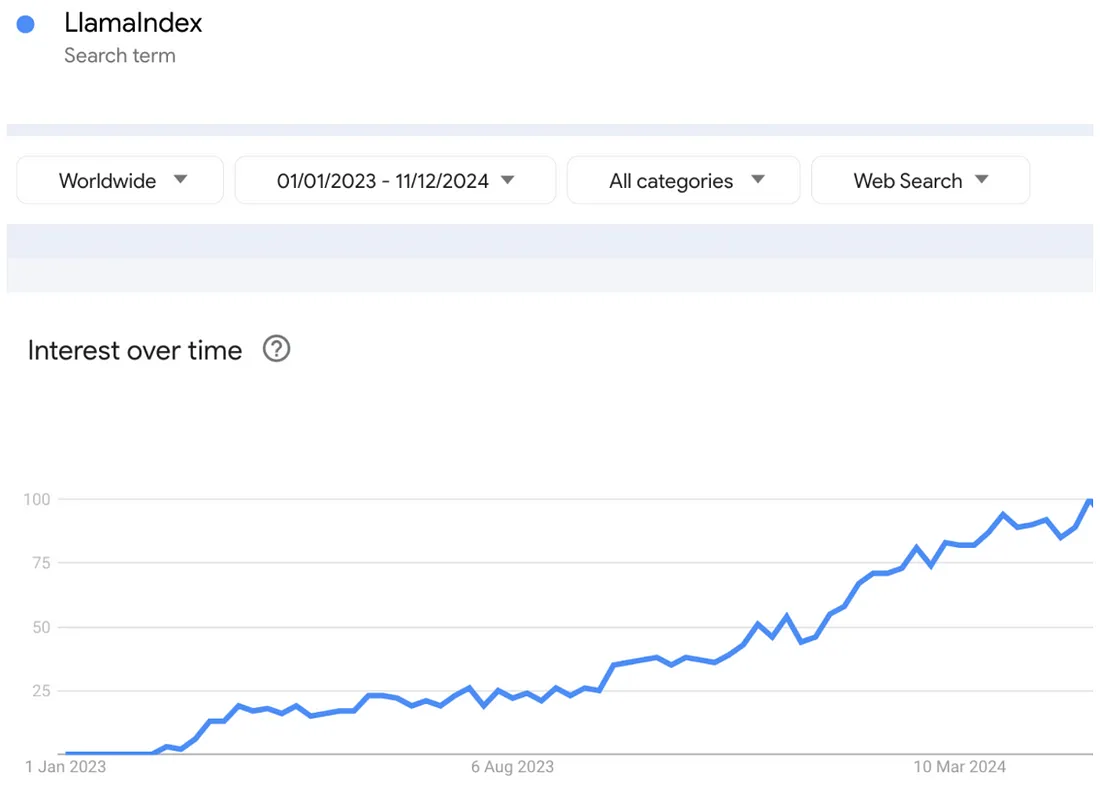

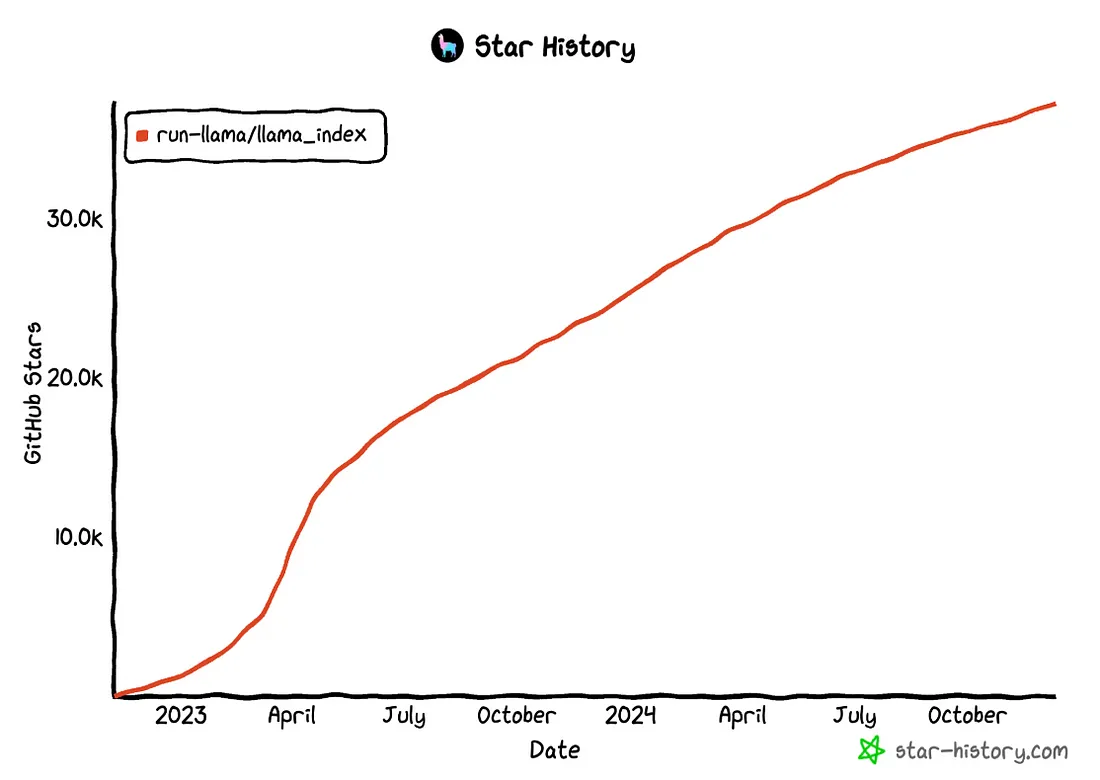

LlamaIndex的受欢迎程度一直在上升,这在Google Trends等平台上不断增长的搜索兴趣中得到了体现。企业渴望采用人工智能技术,而LlamaIndex作为构建基于大型语言模型(LLM)应用的强大框架脱颖而出。

GitHub的数据还显示,该项目的点赞(stars)和贡献数量稳步增长,这表明越来越多的开发者渴望利用这个框架,形成了一个不断壮大的社区。随着对AI应用需求的持续增长,LlamaIndex有望成为开发者不可或缺的工具。

LlamaIndex的组件

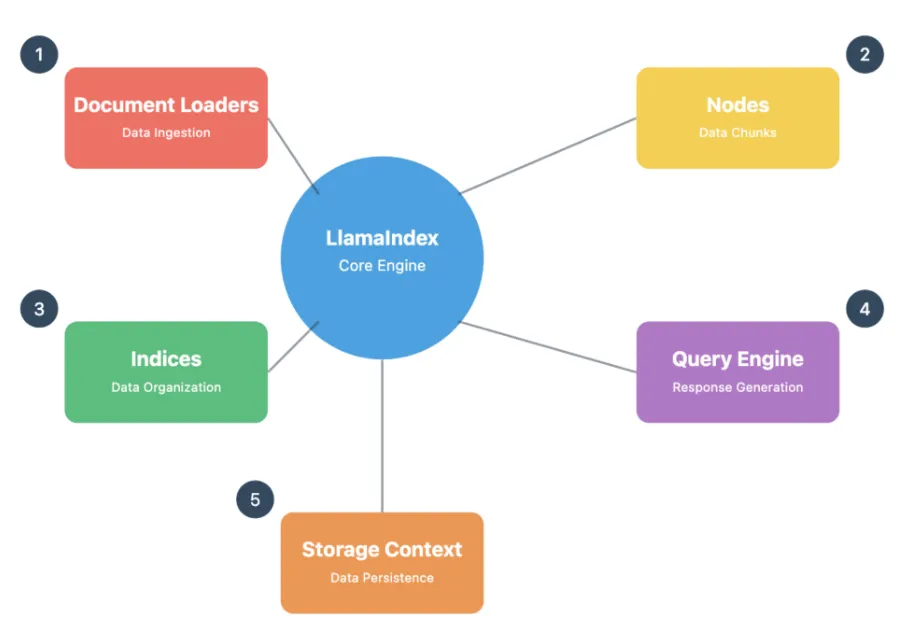

LlamaIndex由几个关键组件组成,这些组件促进了AI应用的开发:

- 文档加载器(Document Loaders):这些组件从各种来源(包括PDF、网页和API)中摄取数据。

- 节点(Nodes):节点将文档分解成更小、更易管理的块,以便进行有效处理。

- 索引(Indices):索引组织和结构化数据块,从而实现高效检索和查询。

- 查询引擎(Query Engine):该引擎处理用户查询,并根据索引数据生成相关响应。

- 存储上下文(Storage Context):这管理数据、索引和嵌入的持久性,以便将来使用。

这些组件协同工作,创建了一个强大的框架,简化了AI应用开发的复杂性。

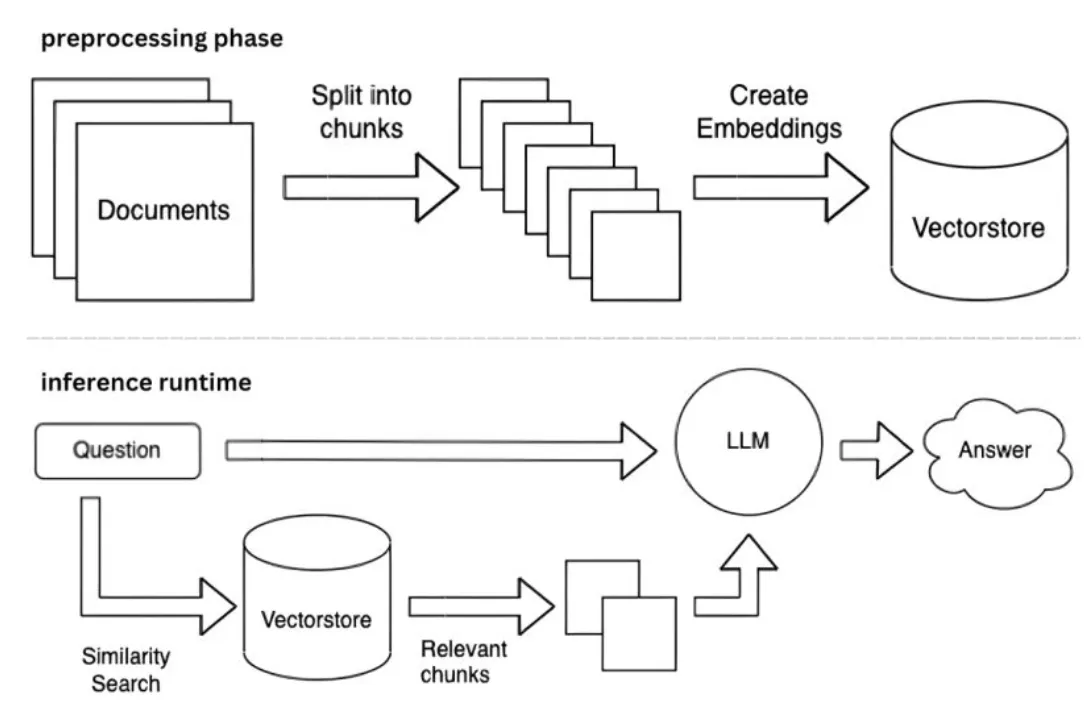

LlamaIndex工作流程概述

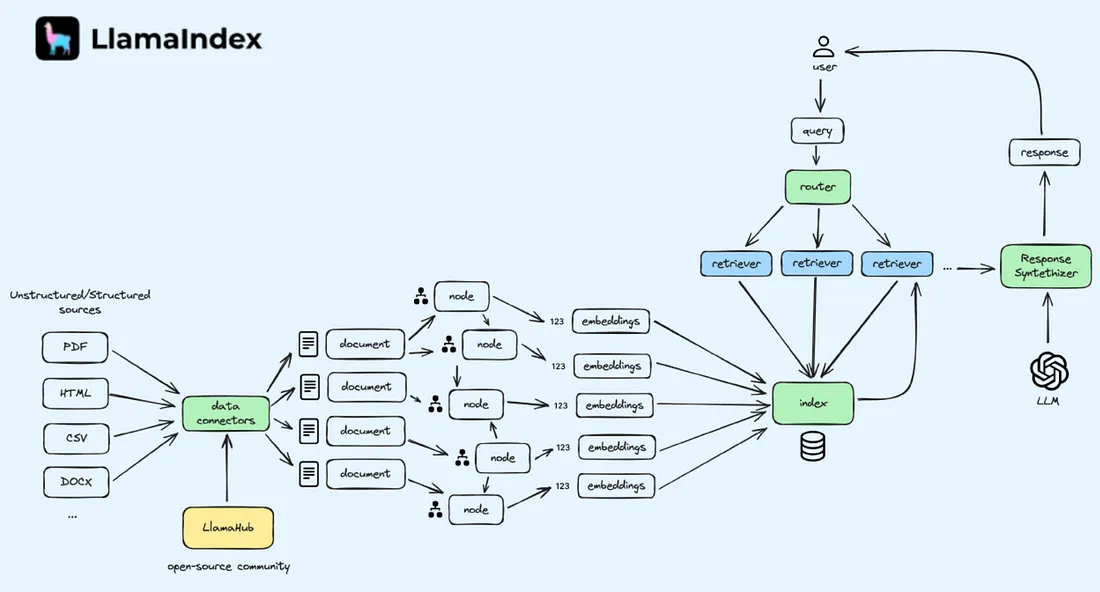

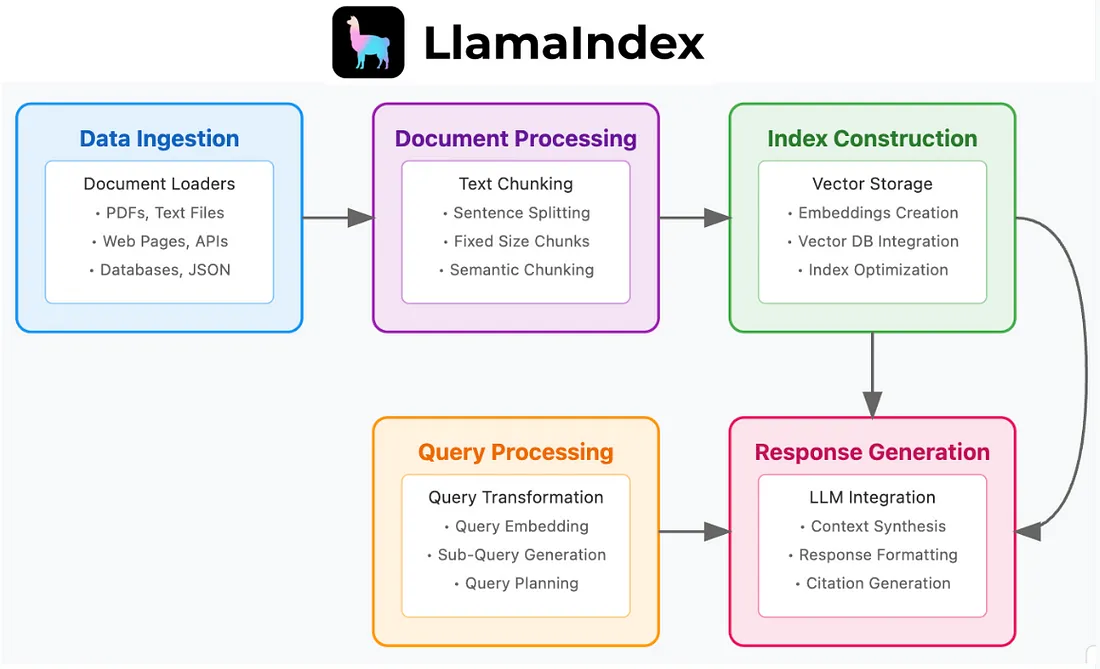

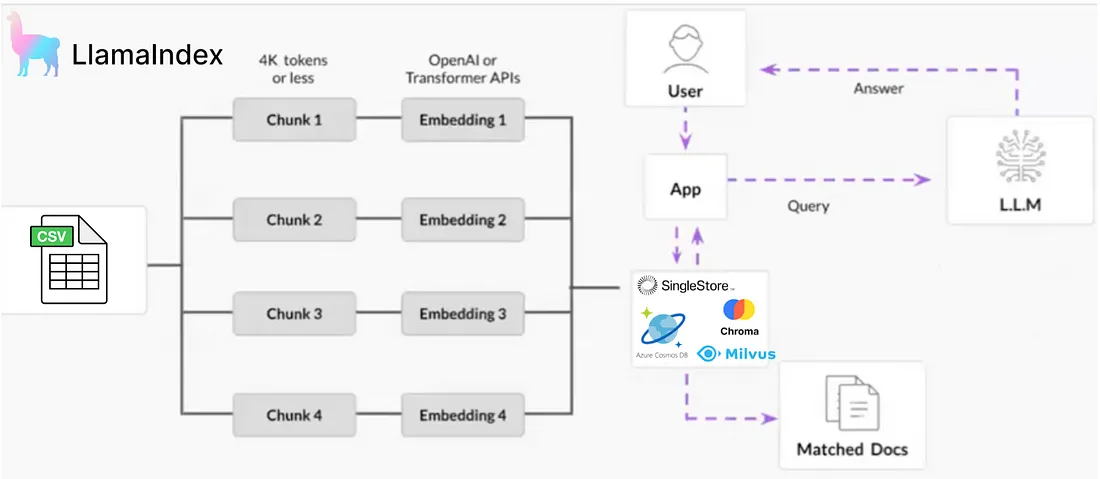

LlamaIndex的工作流程旨在简化构建AI应用的过程。它首先从摄取文档开始,然后对这些文档进行处理和索引,以便高效地存储在向量数据库中。

当用户查询被接收时,它会被转换成向量嵌入,并与索引数据进行搜索匹配。相关的数据块会被识别出来,并发送给大型语言模型(LLM)以生成响应,从而确保答案既准确又具有上下文相关性。

这个工作流程允许整合结构化和非结构化数据源,使其成为各种应用的通用解决方案。

检索增强生成(RAG)简介

检索增强生成(RAG)是提高大型语言模型生成响应准确性的一个关键概念。通过融入外部知识源,RAG减少了模型生成不准确或虚构响应(即“幻觉”)的可能性。

RAG将检索机制与生成式语言模型相结合,使系统能够访问实时数据。这种方法增强了输出的上下文相关性,并为用户提供更可靠的信息。

通过RAG,开发人员可以确保他们的应用不仅利用大型语言模型的能力,而且在响应中保持高度的准确性和相关性。

RAG过程解释

RAG过程将检索机制与生成式模型相结合,以提升AI应用的性能。其核心在于,RAG首先在生成响应之前从外部源检索相关数据。这种两步法确保生成的输出不仅在上下文上是准确的,而且基于现实世界的信息。

在检索阶段,系统会查询数据库或知识库以找到相关信息。然后,这些信息被输入到生成式模型中,该模型会合成一个连贯的响应。通过利用这种方法,开发人员可以显著降低生成不准确或无意义输出(大型语言模型中常见的一个问题,称为“幻觉”)的风险。

这种结构化的响应生成方法对于需要高精度的应用至关重要,如客户支持聊天机器人或信息检索系统。RAG有效地弥合了静态知识和动态查询之间的鸿沟,为用户提供可靠、实时的信息。

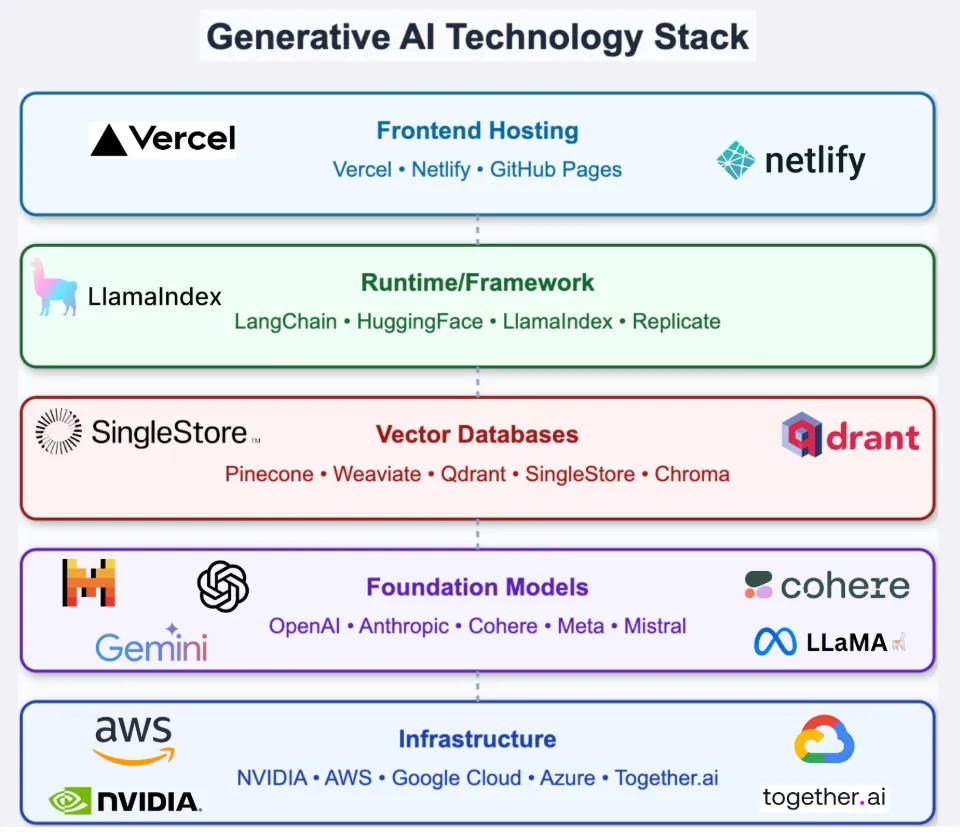

将LlamaIndex集成到Gen AIDevStack中

将LlamaIndex集成到你的生成式AI开发栈中,可以增强RAG应用的整体功能。LlamaIndex作为关键层,促进系统各组件(如数据摄取、索引和查询)之间的连接。

通过在开发栈中有效定位LlamaIndex,开发人员可以简化其AI应用的工作流程。这种集成允许数据从文档加载器到查询引擎的无缝流动,确保快速且准确地生成响应。

此外,LlamaIndex支持多种数据源和格式,使其能够适应各种用例。无论你处理的是结构化数据、非结构化数据还是两者的混合,LlamaIndex都能增强你的应用能力。

LlamaIndex入门

要开始使用LlamaIndex,你需要设置开发环境。首先安装必要的库。对于Python用户,只需使用pip install命令即可:

pip install llama-index

安装完成后,你可以创建一个新项目并设置文档存储。重要的是要将文件组织在一个指定的文件夹中,通常命名为“data”。这个文件夹将存放你要处理的所有文档。

from llama_index.core import VectorStoreIndex, SimpleDirectoryReader

documents = SimpleDirectoryReader("data").load_data()

index = VectorStoreIndex.from_documents(documents)

query_engine = index.as_query_engine()

response = query_engine.query("Some question about the data should go here")

print(response)

接下来,导入应用程序所需的LlamaIndex模块。基本组件包括向量存储索引和简单目录读取器。有了这些工具,你就可以开始为文档建立索引,并为查询做好准备。

教程:设置你的RAG应用程序

在本教程中,我们将使用SingleStore作为向量数据库。SingleStore是一个一体化数据库,用于构建你的AI应用程序。

注册SingleStore并获取你的免费帐户。

设置你的RAG应用程序涉及几个关键步骤。首先,确保你的数据以兼容的格式存储,如CSV或PDF。这将有助于文档加载过程。

整理好数据后,初始化你的LlamaIndex环境。指定向量存储设置,包括表名和元数据字段。此配置将决定在查询期间如何存储和访问你的数据。

环境设置好后,你可以开始加载文档。文档加载器将读取数据并将其分解成易于管理的块。这个分块过程对于高效的索引和检索至关重要。

创建和持久化索引

创建和持久化索引是RAG应用程序工作流程中的关键步骤。文档加载并分块后,你需要定义索引结构。这涉及指定如何组织这些块以及如何检索它们。

定义好索引结构后,将索引持久化到你的向量数据库中。这一步确保索引数据被安全存储,并可以在查询阶段被访问。持久化后,务必验证数据的完整性。

随着新文档的添加或现有文档的修改,可能需要定期更新索引。实施高效的更新机制将有助于保持RAG应用程序的相关性和准确性。

查询索引并生成响应

查询索引是RAG应用程序真正展示其能力的地方。当用户提交查询时,系统通过将其转换为向量嵌入来处理问题。然后,使用该嵌入在索引数据中搜索相关块。

检索到相关数据后,将其传递给大型语言模型(LLM)以生成响应。生成式模型综合这些信息,基于检索到的数据,撰写出连贯且上下文恰当的答案。

确保你的查询机制经过优化,以实现速度和准确性。这将提升用户体验,为查询提供快速可靠的响应。此外,考虑实现允许后续问题或澄清的功能,以进一步丰富交互。

结论

使用LlamaIndex构建RAG应用程序是增强传统大型语言模型(LLM)功能的有力方式。通过将检索机制与生成式模型相结合,开发人员可以创建出不仅智能,而且具备上下文感知能力和准确性的应用程序。