中国研究人员突破长视频处理难题,推出创新技术HiCo与VideoChat-Flash

多模态大语言模型在视频处理领域展现出了其最显著且先进的能力之一——长上下文视频建模。这一能力使得模型能够应对持续数小时的电影、纪录片及直播内容。尽管在视频理解,如字幕生成和问答方面,大型语言模型(LLM)已取得显著进步,但在处理超长视频时,仍面临诸多挑战,其中最核心的问题在于如何有效理解长视频所蕴含的复杂上下文。

尽管该领域已开展大量研究,包括从大规模文本和帧语料库的训练,到构建支持长上下文并行和数据打包的高效训练系统,但这些超长多模态上下文仍然极大地降低了模型的训练和推理效率。此外,帧的冗余性进一步加剧了模型学习的复杂性。视频标记压缩作为该领域的一个有趣方向,虽展现出巨大潜力,但在详细表示上仍需权衡。

本文介绍了一项关于长上下文多模态建模压缩方法的最新研究成果。深圳先进技术研究院的研究人员提出了一种名为HiCo的分层视频标记压缩方法,以及一个实用的上下文建模系统VideoChat-Flash,专为处理长上下文视频而设计。HiCo通过从片段到视频级别的压缩,有效扩展了上下文,同时最小化了计算量并保留了所有关键数据。而VideoChat-Flash则采用多阶段的短到长学习方案,并配备了丰富的真实世界长视频数据集,成为MLLM长视频理解的训练基础设施,支持高程度的序列并行。

HiCo通过分层压缩标记,实现了高密度的标记表示,并扩大了上下文窗口。研究人员将长视频分割成较短的片段,并输入MLLM进行处理。压缩基于时空冗余,HiCo进一步将压缩后的标记与用户查询相结合,利用片段与真实世界嵌入之间的语义关联,有效减少了标记数量。

在VideoChat-Flash系统中,研究人员采用多阶段短到长学习方案,从短视频及相关字幕和问答的监督微调开始,逐步转向长视频,并最终在混合长度语料库上进行训练。短视频在增强基本视觉感知和简洁表达长视频方面展现出显著效果。为此,研究人员提供了一个庞大的微调数据集,涵盖30万小时的视频及20亿字的注释。

论文还提出了一个针对多跳视频配置修改的“干草堆里的针”任务(NIAH)的创新版本。传统NIAH任务主要通过要求模型在视频中定位指定图像、找到目标单词或回答问题来评估性能。然而,这种方法往往依赖于视觉区别而非上下文理解。为解决这一缺陷,研究人员提出了一个新的基准——“视频干草堆中的多跳针”,要求模型定位一系列相互关联的指示性图像,其中后续图像只能通过第一个图像的线索找到。

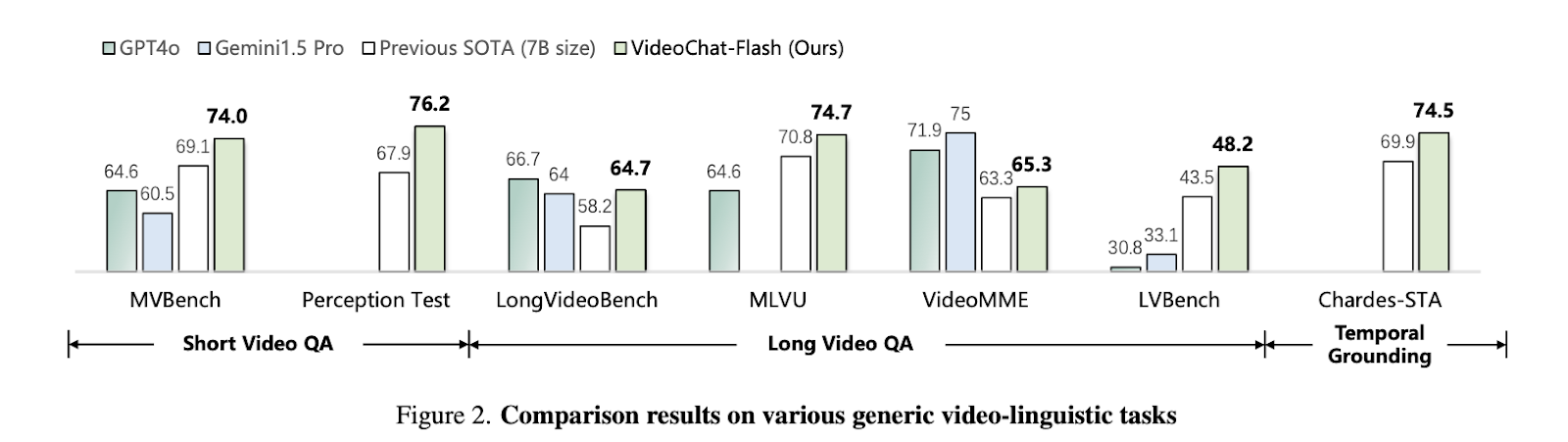

实验结果显示,该方法实现了至多两个数量级的计算减少。特别是在2B和7B规模的主流短视频和长视频基准上,VideoChat-Flash均表现出色。在7B规模模型上,该方法超越了所有其他方法,成为短视频理解的新前沿。在长视频理解方面,该模型也超过了之前的开源MLLMs,在多个基准上达到了最优水平(SOTA)。此外,该模型还展现出强大的时间定位能力,其零样本性能超过了许多著名的MLLMs。在NIAH超过10000帧的测试中,VideoChat-Flash的准确率高达99.1%。

综上所述,研究人员介绍了一种分层压缩技术HiCo,以及使用创新多阶段方案训练的MLLM VideoChat-Flash。这种方法不仅推进了压缩技术以减少长上下文视频的计算量,同时在精度上也超越了当前的SOTA模型。