香港大学和快手科技推出GameFactory:突破游戏场景泛化难题

视频扩散模型作为视频生成和物理模拟的强大工具,近年来在游戏引擎开发领域展现出了巨大潜力。这些生成式游戏引擎作为具备动作可控性的视频生成模型,能够响应用户输入,如键盘和鼠标交互,为用户提供沉浸式的游戏体验。然而,场景泛化——即创造超越现有场景的新游戏场景的能力,一直是该领域面临的关键挑战。

尽管收集大规模的动作标注视频数据集是实现场景泛化的最直接方法,但这样的标注成本高昂,对于开放域情境而言不切实际。这一限制阻碍了能够生成多样化和新颖游戏环境的多功能游戏引擎的开发。

为了克服这一挑战,视频生成和游戏物理领域的最新研究探讨了多种方法,其中视频扩散模型成为了一项重要进展。这些模型从U-Net架构演变为基于Transformer的架构,使得生成更现实、更长时间的视频成为可能。此外,像Direct-a-Video这样的方法提供了基本的摄像机控制,而MotionCtrl和CameraCtrl则提供了更复杂的摄像机姿态操控。然而,这些项目大多受限于特定游戏和数据集,场景泛化能力有限。

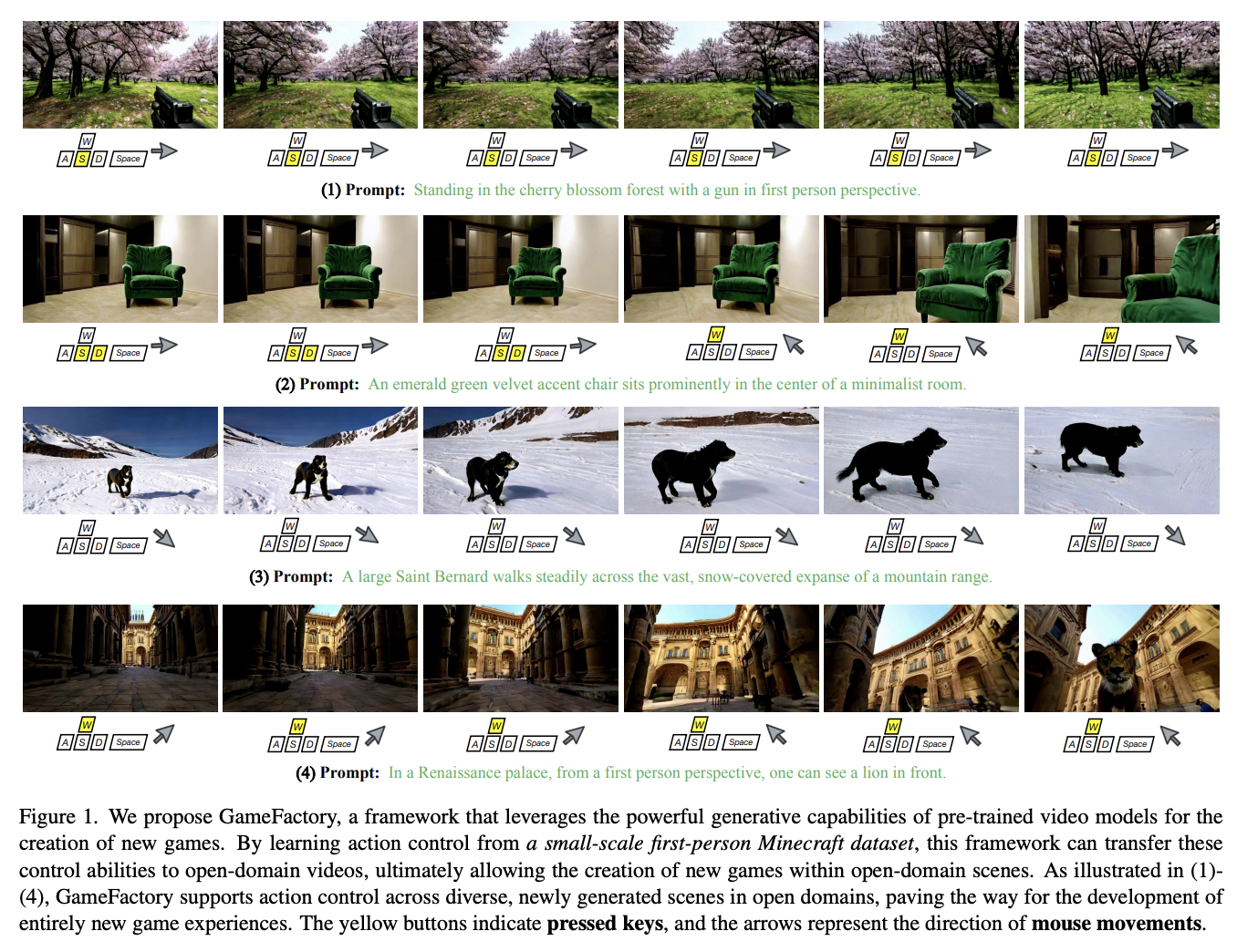

近日,来自香港大学和快手科技的研究人员提出了GameFactory,这是一个旨在解决游戏视频生成中的场景泛化问题的突破性框架。GameFactory利用在开放域视频数据上训练的预训练视频扩散模型,结合多阶段训练策略,成功创造了全新的多样化游戏场景。

GameFactory的多阶段训练策略实现了有效的场景泛化和动作控制。该过程始于预训练视频扩散模型,并分为三个阶段。在阶段一,模型使用LoRA适配专注于目标游戏域,同时保留大部分原始参数。阶段二专注于训练动作控制模块,冻结预训练参数和LoRA,以防止风格与控制的纠缠。在阶段三,移除LoRA权重,使系统能够在多样化的开放域场景中生成受控的游戏视频。

对GameFactory性能的评估显示,该框架在不同控制机制下均表现出色。对于离散控制信号如键盘输入,交叉注意力在Flow-MSE指标上表现优于拼接;而对于连续的鼠标移动信号,拼接更为有效。在风格一致性方面,不同方法显示出可比的性能。系统掌握了不同游戏场景中的基本原子动作和复杂组合动作,展现了强大的场景泛化和动作控制能力。

GameFactory代表了生成式游戏引擎的一项重大进展,解决了游戏视频生成中的场景泛化这一关键挑战。该框架通过有效利用开放域视频数据和实施新颖的多阶段训练策略,展示了通过生成式互动视频创建新游戏的可行性。尽管这一成就标志着一个重要的里程碑,但在开发完全成熟的生成游戏引擎方面仍有诸多挑战需要克服。GameFactory为这一不断发展的领域奠定了坚实的基础,为未来的研究提供了有希望的方向。