UI-TARS:字节跳动新推AI代理,操控电脑执行复杂任务

字节跳动近期推出了一款名为UI-TARS的新AI代理,它能够控制电脑并执行复杂的工作流程。这款代理与Anthropic的Computer Use类似,能够理解图形用户界面(GUI),进行推理,并自主逐步执行动作。

训练与性能卓越

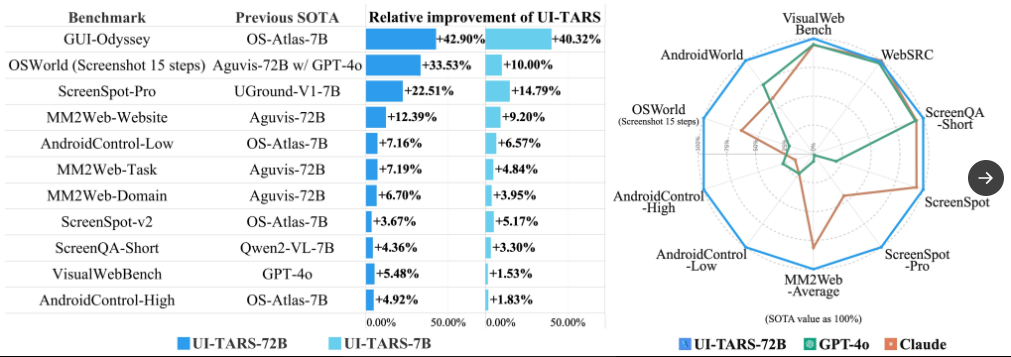

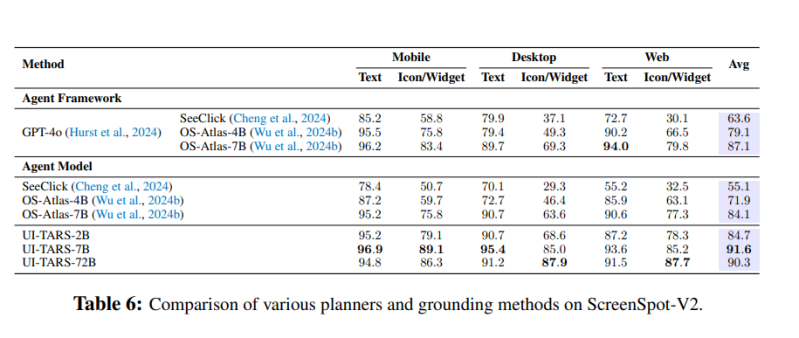

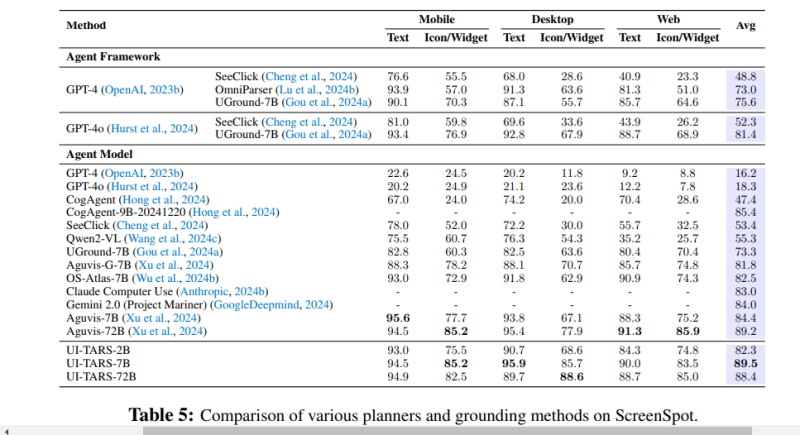

UI-TARS在大约500亿个tokens上进行了训练,提供了7B和72B参数两个版本。在10多个GUI基准测试中,它在性能、感知、定位和整体代理功能上均实现了最先进(SOTA)的表现,始终优于OpenAI的GPT-4o、Claude和Google的Gemini。

字节跳动和清华大学的研究人员在新研究论文中指出,通过迭代训练和反思调整,UI-TARS能够不断从错误中学习,并在最少人为干预的情况下适应不可预见的情况。

多模态输入与逐步思考

UI-TARS可以在桌面、移动和网络应用程序上运行,使用多模态输入(包括文本、图像和交互)来理解视觉环境。其界面设计直观,左侧显示逐步“思考”过程,右侧较大区域则展示其调出文件、网站和应用程序并自动执行动作的情况。

例如,在演示视频中,该模型被要求查找从SEA到NYC的往返航班,并按价格升序排序。UI-TARS导航到达美航空公司的网站,填写相关信息,点击相关日期并按价格排序和筛选,同时在其思考框中解释每一步操作。

在另一个场景中,它被指示在VS Code中安装autoDocstring扩展。它首先报告需要打开VS Code,然后等待应用程序完成初始化,接着访问扩展视图,并在遇到小故障时重新尝试点击以确保成功。一旦进入扩展视图,它输入‘autoDocstring’并等待安装完成。

超越竞争对手的卓越表现

在各种基准测试中,UI-TARS持续超越竞争对手。例如,在VisualWebBench中,它得分82.8%,超过了GPT-4的78.5%和Claude 3.5的78.2%。此外,在WebSRC基准测试、ScreenQA-short以及GUI元素理解和定位能力的测试中,UI-TARS也表现出色。

研究人员强调,UI-TARS在网页和移动环境中的卓越感知和理解能力为其代理任务奠定了基础。这种感知能力对于任务执行和决策至关重要。

技术细节与训练策略

为了帮助UI-TARS逐步采取行动并识别其所看到的内容,研究团队在大规模截图数据集上进行了训练。该数据集解析了元数据,包括元素描述和类型、视觉描述、边界框、元素功能以及来自各种网站、应用程序和操作系统的文本。

此外,UI-TARS还使用状态转换字幕来识别和描述两个连续截图之间的差异,并确定是否发生了动作。同时,标记集合(SoM)提示允许其在图像的特定区域覆盖不同的标记。

为了处理当前任务并保留历史交互以改善后续决策,UI-TARS配备了短期和长期记忆。研究团队还训练模型执行系统1和系统2推理,允许多步骤决策、“反思”思维、里程碑识别和错误更正。

为了确保代理能够保持一致的目标并通过试错来假设、测试和评估潜在动作,研究团队引入了错误更正和反思后数据两种类型的数据来支持这一点。这种策略确保了UI-TARS不仅学会避免错误,还能在发生错误时动态适应。

未来展望与竞争优势

UI-TARS表现出令人印象深刻的能力,在日益竞争的AI代理领域中其不断发展的使用案例将是值得关注的。研究人员指出,虽然本土代理代表了一个重大飞跃,但未来在于主动和终身学习的整合。通过持续的实际交互自主推动学习,UI-TARS有望在未来实现更大的突破。

与竞争对手相比,UI-TARS在网站和移动领域都表现出色。例如,Claude计算机使用在基于网页的任务中表现强劲,但在移动场景中明显困难。这表明Claude的GUI操作能力尚未很好地转移到移动领域。而UI-TARS则在这方面展现出了强大的实力。

综上所述,UI-TARS作为一款新推出的AI代理,已经展现出了卓越的性能和广泛的应用前景。随着技术的不断进步和应用的不断拓展,它有望在未来的AI领域中发挥更加重要的作用。