微软AI推出SIGMA:专为AI基础设施优化而量身定制的高效大型语言模型

人工智能(AI)与机器学习(ML)的飞速发展,已深刻变革了众多领域。然而,专注于AI基础设施优化与管理的“系统领域”尚待深入探索。该领域涵盖诊断硬件故障、配置优化、工作负载管理以及系统性能评估等核心任务,因其复杂性和对硬件、软件及数据的深刻理解需求,常面临重大挑战。传统手段或通用AI模型难以有效应对,导致过程资源密集且易出错,因此,专为系统领域设计的解决方案呼之欲出。

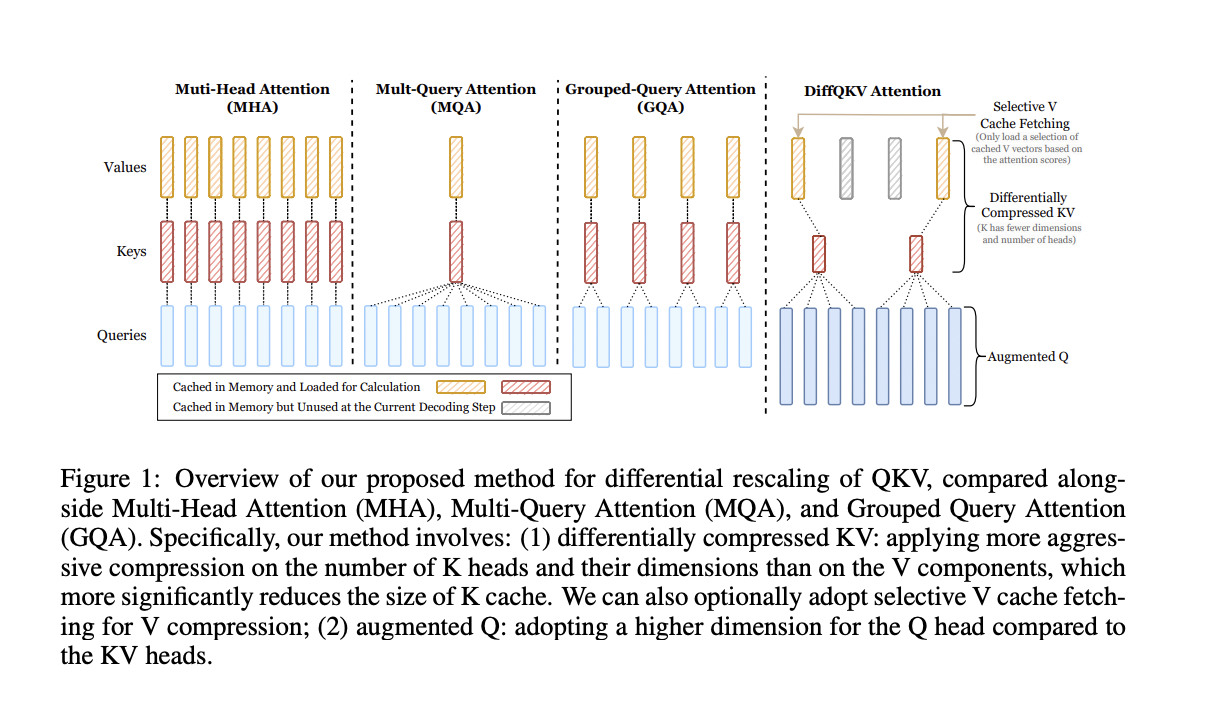

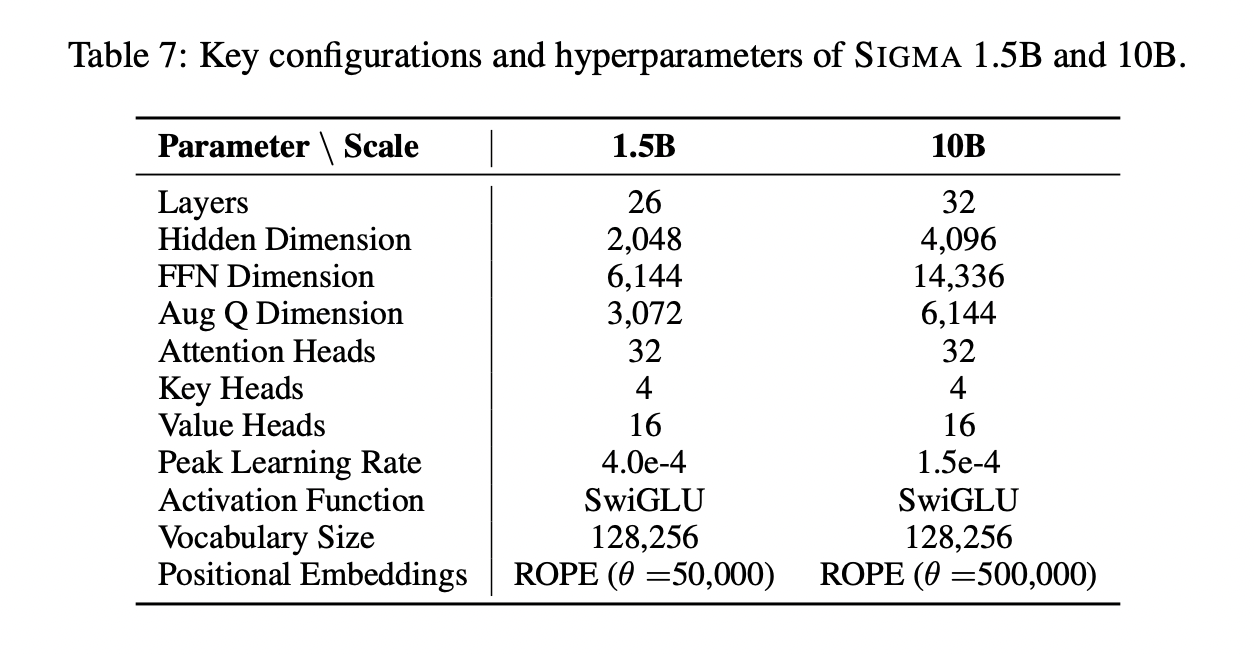

为应对这些挑战,微软推出了大型语言模型SIGMA,专为系统领域打造。SIGMA采用了创新的架构,核心为差分查询-键-值(DiffQKV)注意力机制,并进行了广泛的系统特定数据预训练。DiffQKV通过定制策略优化查询(Q)、键(K)、值(V)组件的推理效率,不同于传统方法的统一压缩,它实施选择性压缩,即对键组件进行大幅压缩,同时保留值组件以保持性能。此外,SIGMA还增强了查询维度,提升了表示能力,且未显著影响推理速度。

SIGMA的预训练涵盖了6万亿个tokens,其中19.5亿来自系统领域特定来源,1万亿为合成和重写tokens。这种针对性的训练确保了SIGMA在一般领域与顶尖模型比肩,同时在系统特定任务中表现卓越。为验证其能力,微软推出了系统相关任务基准测试AIMICIUS。SIGMA在AIMICIUS上的表现显著优于GPT-4,实现了高达52.5%的绝对提升。

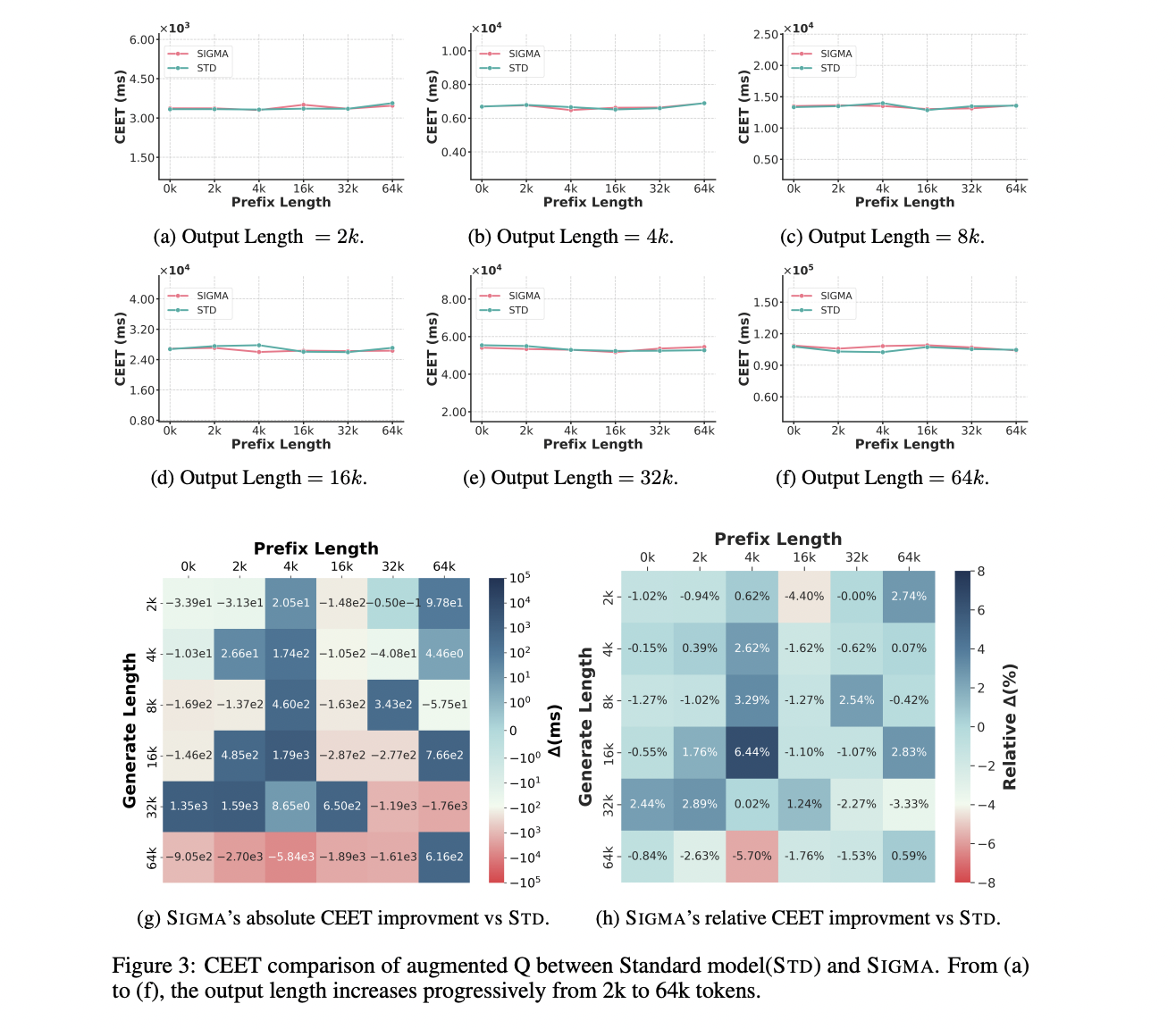

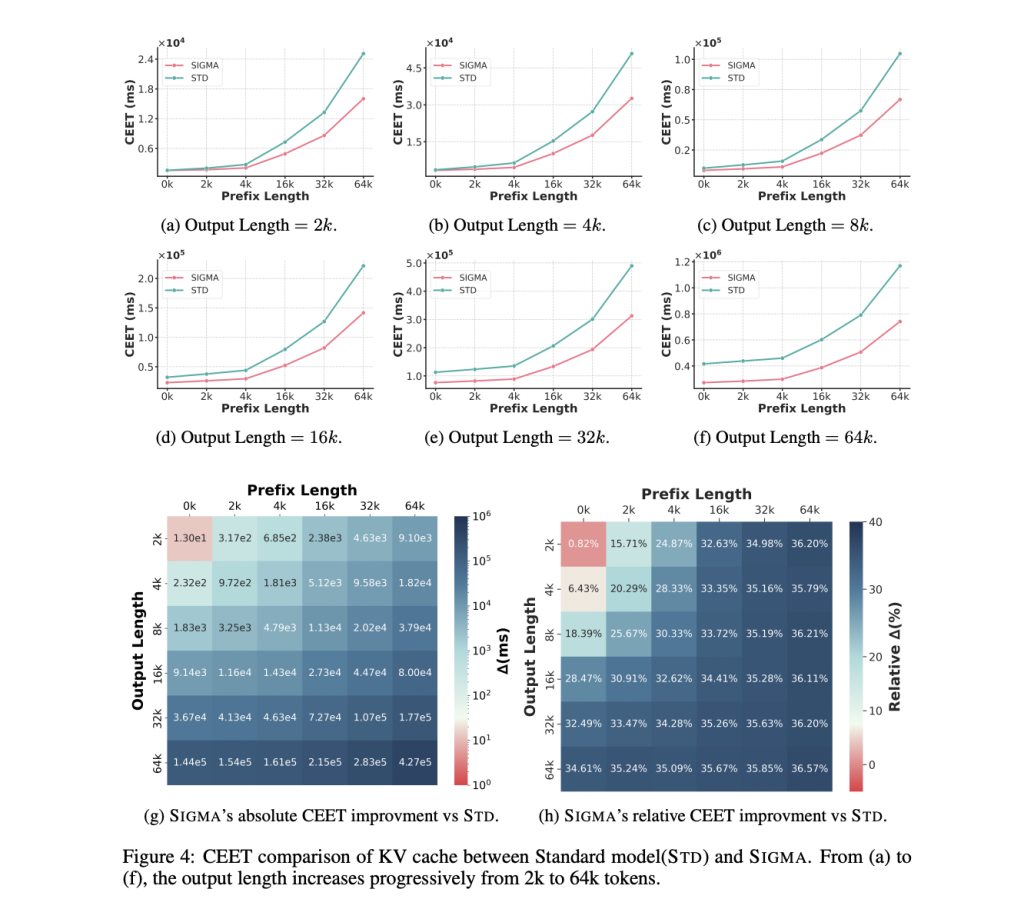

技术细节方面,SIGMA的创新核心在于DiffQKV注意力机制。该机制利用注意力分数中的稀疏性,在推理时选择性检索值组件,降低了内存使用,同时保持了高性能。这些优化使得SIGMA的推理速度相比传统分组查询注意力机制提升了33.36%。此外,SIGMA的增强查询维度在不大幅增加内存负担的前提下,提高了表示能力,因为查询头在推理中无需缓存。

SIGMA采用了不平衡的头配置,键头数量少于查询和值头,减少了KV缓存的内存占用,同时保持了高性能。例如,将键头数量减少到值头的25%,性能损失可忽略不计;将键组件维度减半,也可实现压缩而不影响准确性。

在模型训练过程中,微软从超过120个系统相关网站中精心筛选了15个主要来源类别,包括技术博客、开发者论坛、Stack Overflow帖子和学术论文,形成了多样且全面的数据集。这为SIGMA在命令行生成、基础设施基准测试、网络拓扑优化以及自然语言到Kusto查询语言(NL2KQL)翻译等任务中的出色表现奠定了坚实基础。

SIGMA在AIMICIUS基准测试中的表现凸显了其在系统领域的有效性。该基准测试涵盖CMDGen、Infrawise、Optiflow和NL2KQL四个主要任务。在CMDGen中,SIGMA在生成与GPU相关的命令行方面表现出高准确性;在Infrawise中,其检索基准测试结果的能力反映了强大的召回率和准确性;在Optiflow中,SIGMA展示了优化多GPU设置网络拓扑的能力,实现了延迟的显著减少;在NL2KQL中,SIGMA能将自然语言指令准确翻译为Kusto查询语言,并遵循语法标准。

效率是SIGMA的显著特点。评估显示,SIGMA在内存使用和计算速度上,尤其是在长上下文场景中,取得了显著提升。例如,SIGMA的KV缓存优化使得在长序列生成过程中计算时间比标准模型减少了33%。这种高效性使SIGMA能够处理更大的批次和更长的序列,非常适合需要广泛上下文处理的实际系统任务。

综上所述,SIGMA是大型语言模型在系统领域的一次深思熟虑且实用的应用。通过DiffQKV注意力机制和领域特定训练等创新手段,SIGMA成功应对了系统相关任务的独特挑战,提供了一种平衡效率和性能的专用解决方案。其在AIMICIUS基准测试中的卓越表现,彰显了其作为管理和优化AI基础设施宝贵工具的潜力。随着系统领域重要性的日益凸显,SIGMA的进步为应对该领域固有的复杂性提供了一个令人信服的模型。