如何使用 DeepSeek-R1、LangChain和Ollama构建本地RAG

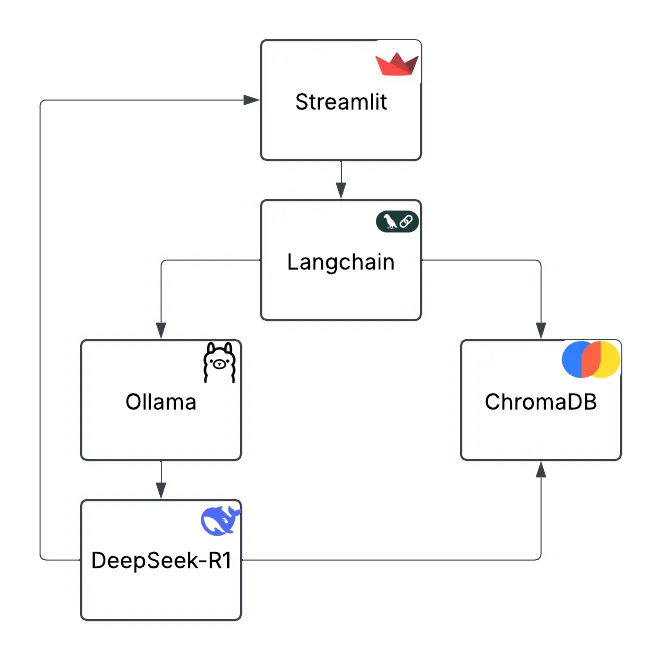

在本文中,你将学习如何使用DeepSeek-R1、LangChain、Ollama和Streamlit构建检索增强生成 (RAG)系统,该系统在本地处理 PDF 。本分步教程将LangChain的模块化功能与DeepSeek-R1的隐私优先方法相结合,为处理技术、法律和学术文档提供了强大的解决方案。

该项目将用于 RAG 工作流的 AI 框架LangChain与用于DeepSeek-r1本地部署的Ollama和用于用户界面的Streamlit相结合。最终打造出一款可以在本地提取 PDF并准确快速地回答问题的AI 助手。

在这个演示中,我们将使用一个具有 7B 参数的DeepSeek-r1蒸馏模型,但如果你拥有更强的计算能力,我推荐其他DeepSeek-r1 蒸馏模型。

为何选择私有RAG解决方案?

基于云的AI解决方案功能强大,但往往伴随着隐私风险和持续成本等挑战。通过利用LangChain的模块化框架,你可以创建一个本地RAG解决方案,该方案具有诸多优势:

- 数据隐私:所有操作均在本地进行,你的数据永远不会离开你的机器。

- 成本效益:无需昂贵的API订阅费用,此解决方案免费且开源。

- 可定制性:LangChain的灵活性允许你微调文档检索和响应生成流程。

- 强大的AI:集成DeepSeek-R1,这是一个针对问题解决和技术任务优化的推理模型。

工具和技术:LangChain、DeepSeek-R1、Ollama、ChromaDB和Streamlit

此项目由以下部分组成:

- LangChain:RAG管道的核心框架,支持集成文档加载器、向量存储和大型语言模型(LLM)。它允许根据特定需求构建模块化和可扩展的AI工作流。

- DeepSeek-R1:一个针对编程、问题解决和技术任务设计的推理大型语言模型。提供多种蒸馏尺寸,便于通过Ollama进行本地部署。

- Ollama:一个简化本地大型语言模型和嵌入模型(如DeepSeek-R1和mxbai-embed-large)部署和管理的命令行界面(CLI)工具。

- ChromaDB:一个向量数据库,用于存储和检索文档嵌入,以支持基于相似性的查询。

- Streamlit:一个用于构建网页界面的Python库,使你的RAG应用程序用户友好且易于访问。

构建RAG管道:分步指南

以下是设置本地ChatPDF解决方案的方法:

安装前提条件

确保你已安装Python 3.8+和Ollama。运行以下命令:

curl -fsSL https://ollama.com/install.sh | sh

ollama -v # Verify installation

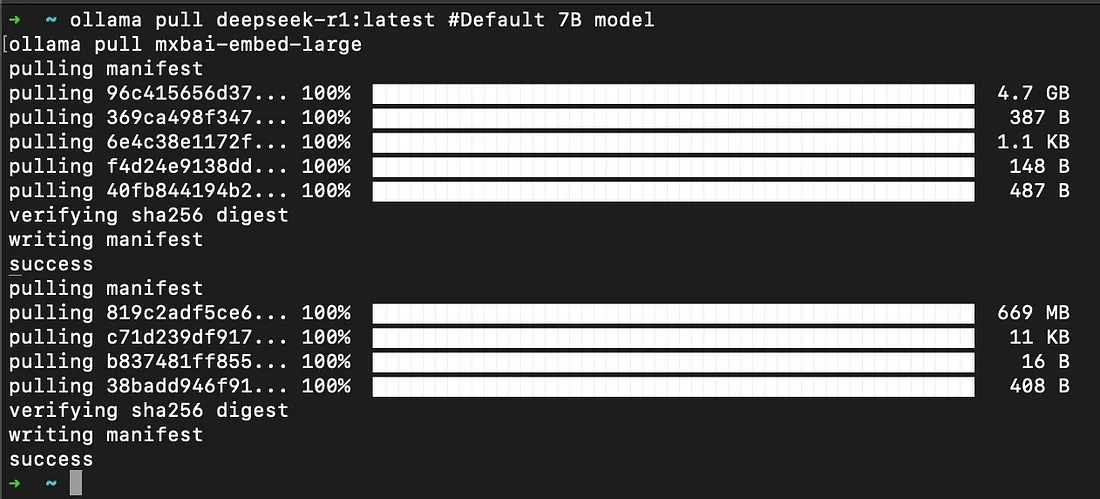

下载所需的AI模型:

ollama pull deepseek-r1:latest # Default 7B model

ollama pull mxbai-embed-large # Embeddings model

设置项目

克隆存储库并设置虚拟环境:

git clone https://github.com/paquino11/chatpdf-rag-deepseek-r1.git

cd chatpdf-rag-deepseek-r1

python3 -m venv venv

source venv/bin/activate

安装依赖项:

pip install -r requirements.txt运行应用程序

启动Streamlit应用程序:

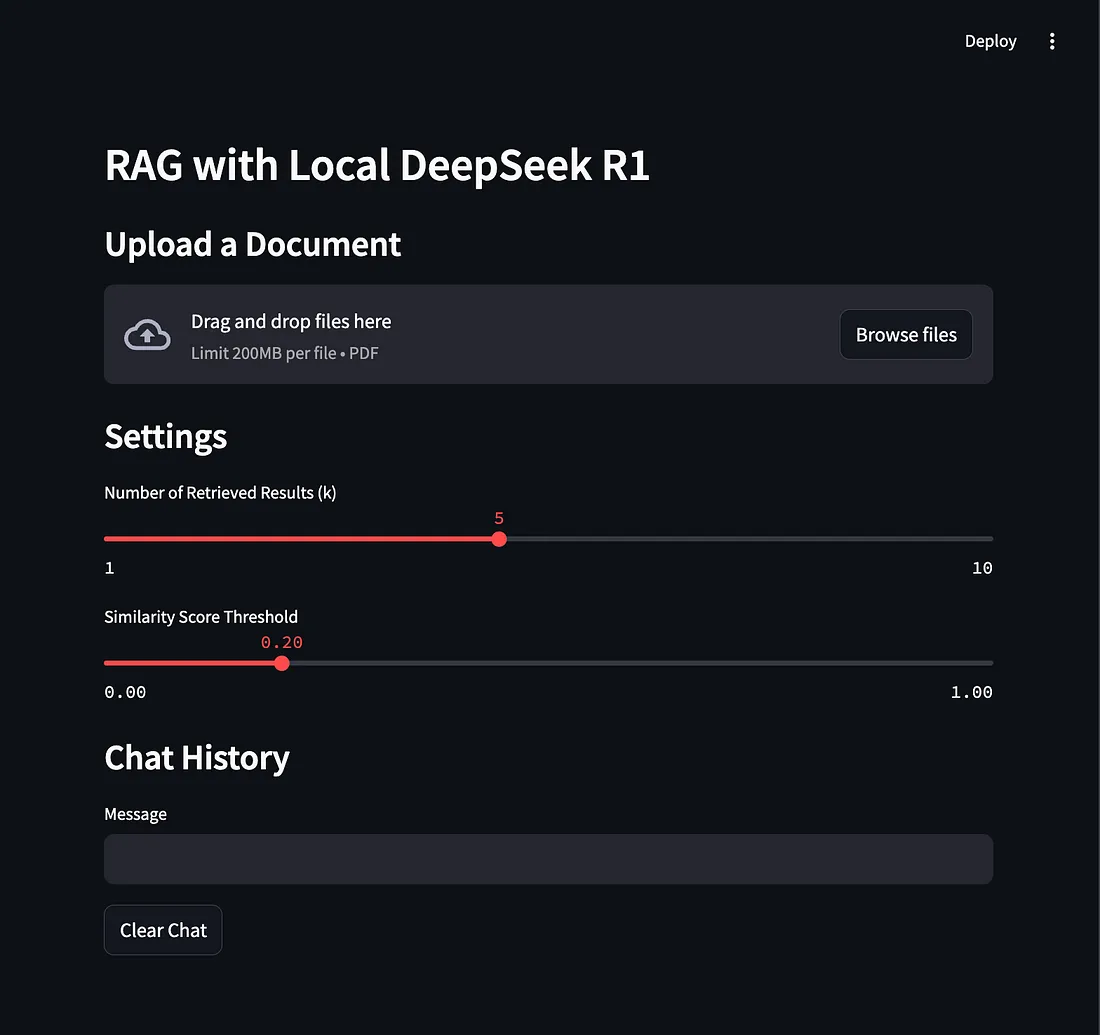

streamlit run app.py在浏览器中访问 http://localhost:8501 以使用该应用。上传你的PDF文件,调整检索设置,并开始提问。

使用DeepSeek-R1、Ollama、LangChain和ChromaDB构建RAG管道

本项目使用LangChain来管理整个RAG工作流程:

1. 使用LangChain进行PDF摄入:

- 使用LangChain的PyPDFLoader和RecursiveCharacterTextSplitter读取PDF并将其拆分为多个块。

- 使用OllamaEmbeddings将这些块嵌入为向量表示。

2. 使用ChromaDB进行文档检索:

- LangChain 与ChromaDB的集成实现了基于相似性的快速相关文档块检索。

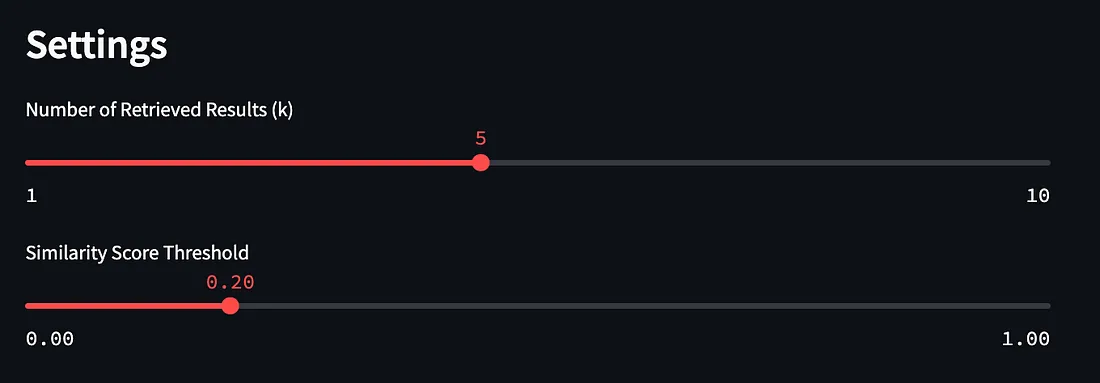

- 自定义结果数量(k)和相似度阈值(score_threshold),以便更好地控制。

3.使用DeepSeek-R1生成响应:

- 检索到的文档块被传递给DeepSeek-R1,后者生成简洁、准确的答案。

- LangChain 的ChatPromptTemplate确保 AI 以用户友好的格式做出响应。

自定义检索设置以获得最佳结果

LangChain 可以轻松调整检索设置以获得最佳性能:

k:检索到的结果数

控制响应中使用多少个文档块。

- 更高k:更多内容,响应更慢。

- 较低k:背景信息较少,响应较快。

score_threshold:相似度截止

过滤器根据相关性检索结果。

- 更高的阈值:仅检索高度相关的块。

- 门槛较低:范围较广,但精确度较低。

用例和测试你的RAG应用程序

以下是一些测试该应用程序的示例:

测试PDF:

- 金融:分析财务报告并提取可操作的见解。

- 医疗保健:总结研究论文或医疗指南。

- 教育:从电子书和学术论文中提取摘要或要点。

示例问题:

- “这个Python库的关键特性是什么?”

- “这份合同的第5条讨论了什么?”

- “总结这本电子书的第2章。”

结论

通过结合LangChain、DeepSeek-R1和ChromaDB,你可以创建一个注重隐私、灵活性和成本效益的RAG系统。这种本地RAG解决方案非常适合分析技术文档、法律文本等,而无需依赖基于云的工具。