如何在VSCode 中本地运行 DeepSeek:打造强大的私人AI助手

本分步指南将向你展示如何在本地安装和运行 DeepSeek、使用 CodeGPT 对其进行配置以及开始利用 AI 来增强你的软件开发工作流程,所有这些都无需依赖基于云的服务。

步骤1:在VSCode中安装Ollama和CodeGPT

为了本地运行DeepSeek,我们首先需要安装Ollama,它允许我们在自己的机器上运行大型语言模型(LLM),以及安装CodeGPT,这是一个VSCode扩展,用于将这些模型集成进来以提供编码辅助。

安装Ollama

Ollama是一个轻量级平台,使得运行本地大型语言模型变得简单。

下载Ollama

访问官方网站:https://ollama.com

下载适用于你操作系统(Windows、macOS 或 Linux)的安装程序。

验证安装

安装完成后,打开终端并运行:

ollama --version

如果Ollama安装正确,它将显示已安装的版本。

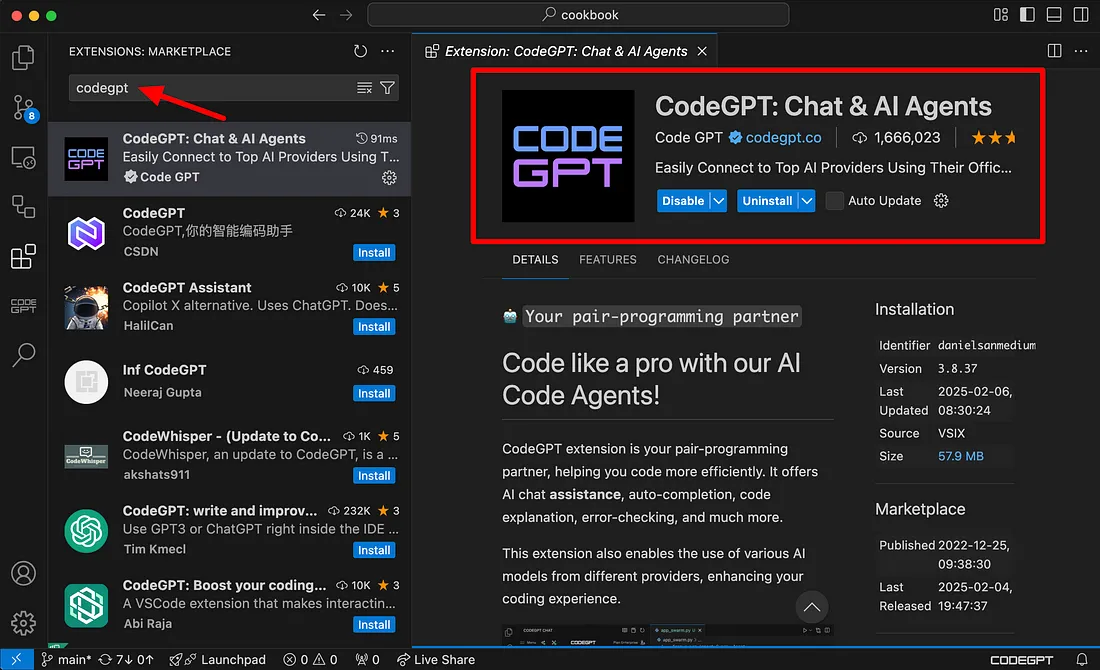

在Visual Studio Code中安装CodeGPT

打开VSCode,然后导航到扩展市场(在Windows上按Ctrl + Shift + X,在macOS上按Cmd + Shift + X)。

搜索“CodeGPT”并点击安装。

或者你可以在此创建免费账户:https://codegpt.co

安装好Ollama和CodeGPT后,我们现在就可以下载并配置DeepSeek,开始本地使用AI进行编码了。

步骤2:下载并设置模型

既然你已经成功安装了Ollama和CodeGPT,接下来就是下载你将本地使用的模型了。

- 聊天模型:deepseek-r1:1.5b,该模型针对较小环境进行了优化,可在大多数计算机上流畅运行。

- 自动补全模型:deepseek-coder:1.3b。此模型采用了“填空中间”(FIM)技术,能够在你编写代码时提供智能的自动补全建议。它可以预测并建议函数或方法的中间部分,而不仅仅是开头或结尾。

下载聊天模型(deepseek-r1:1.5b)

要开始使用聊天模型,请执行以下操作:

- 在VSCode中打开CodeGPT。

- 导航到侧边栏中的本地大型语言模型(LLM)部分。

- 在可用选项中,选择Ollama作为本地大型语言模型提供商。

- 选择模型deepseek-r1:1.5b。

- 点击下载按钮。模型将自动开始下载。

下载完成后,CodeGPT将自动安装该模型。安装完毕后,你就可以开始与模型进行交互了。

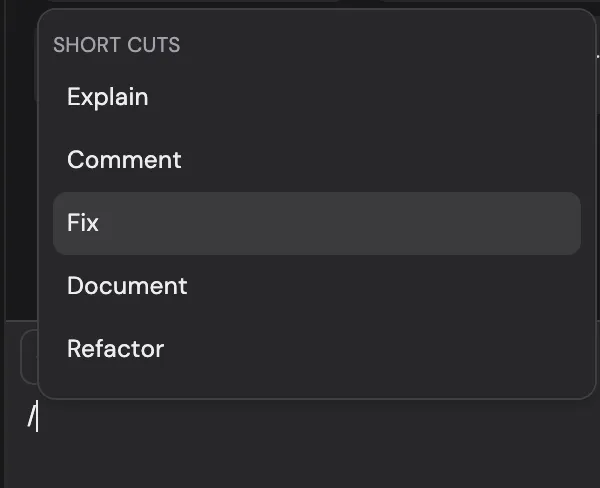

现在,你可以轻松地向模型询问有关代码的问题。只需在编辑器中突出显示任何代码,使用#符号在查询中添加额外文件,并利用强大的命令快捷键,例如:

- /fix — 用于修复错误或建议改进代码。

- /refactor — 用于清理和改进代码结构。

- /Explain — 用于获取任何代码片段的详细解释。

这个聊天模型非常适合用于回答具体问题或就代码提供建议。

下载自动补全模型(deepseek-coder:1.3b)

为了增强代码自动补全功能:

在VSCode中打开终端。

运行以下命令来拉取deepseek-coder:1.3b模型:

ollama pull deepseek-coder:1.3b

此命令将自动补全模型下载到你的本地计算机。

下载完成后,返回CodeGPT并导航到自动补全模型部分。

在可用模型列表中选择deepseek-coder:1.3b。

6

一旦选择后,你就可以开始编码了。在你输入时,模型将开始提供实时代码建议,帮助你轻松完成函数、方法甚至整个代码块。

步骤3:享受无缝的本地和私密AI辅助编码

设置好模型后,你现在就可以享受这些强大工具带来的全部好处,而无需依赖外部API。通过在你的本地机器上运行一切,你可以确保对编码环境的完全隐私和控制。无需担心数据离开你的计算机,一切都保持安全且私密。