迁移学习在时间序列分析中的应用

当时间序列知识跨越领域

时间序列的数学基础帮助我们理解序列数据中的模式,但收集足够的数据来构建稳健的模型仍然具有挑战性。迁移学习通过允许在一个时间序列问题上训练的模型帮助解决另一个问题,从而应对这一挑战。这种方法彻底改变了我们处理有限数据场景的方式,并加速了跨领域的模型开发。

理解迁移学习

迁移学习代表了我们处理时间序列建模方式的一种范式转变。传统的时间序列分析需要从特定感兴趣领域中获取大量数据。然而,许多实际应用面临数据稀缺的问题,无论是由于数据收集的成本、问题的新颖性还是事件的稀有性。迁移学习通过利用从解决相关问题中获得的知识来克服这些限制。例如,一个训练用来预测办公楼能源消耗模式的模型可以经过调整来预测住宅能源使用,尽管使用模式和规模存在差异。

时间序列中迁移学习的机制

迁移学习在时间序列数据上的应用通过几个关键机制运作。基于特征的迁移学习从源时间序列数据中提取有意义的表示,这些表示可以应用于目标领域。例如,一个训练用来识别零售销售中季节性模式的模型可能会将这些模式识别能力转移到农业产量预测中,因为这两个领域都表现出相似的周期性行为。另外,基于参数的迁移学习重用训练模型架构或参数的部分内容,并对其进行微调以适应新任务。

基于实例的迁移学习

基于实例的迁移学习选择性地使用源领域中的样本来增强目标领域的学习。这种方法在处理时间序列数据中的罕见事件或异常时特别有价值。例如,在制造设备维护中,关于一种类型机器故障模式的数据可以为预测具有有限运行历史的类似机器的故障提供信息。关键挑战在于识别源领域中哪些实例对目标问题仍然相关。

时间序列的深度迁移学习

深度学习架构极大地扩展了时间序列分析中迁移学习的可能性。卷积神经网络(CNN)和长短期记忆(LSTM)网络可以学习时间模式的层次表示,这些表示通常可以跨领域泛化。一个最初在高频金融数据上训练的模型可能会提取出对分析医疗时间序列有用的特征,尽管这些领域之间存在明显的差异。深度学习方法中的迁移学习通常涉及冻结网络的早期层,同时在目标域上重新训练后期层。

领域适应挑战

成功地将迁移学习应用于时间序列需要仔细考虑领域差异。时间尺度差异、不同的采样率和不同的季节性模式都会影响知识转移的有效性。例如,将知识从小时数据转移到月度数据需要机制来处理不同的时间分辨率。领域适应技术通过学习源领域和目标领域之间的映射,同时保留相关的时间依赖性,有助于弥合这些差距。

预训练模型和时间序列

预训练模型在计算机视觉和自然语言处理中的成功激发了时间序列分析中的类似方法。在大型、多样数据集上预训练的通用时间序列模型可以作为特定应用的起点。这些模型学习通常跨领域证明有用的通用时间模式和关系。然而,时间序列数据的异质性在开发真正通用的预训练模型时带来了独特的挑战。

实用Python实现

让我们通过具体的例子来探索在时间序列分析中迁移学习的实际应用。我们将使用Python来演示关键概念和技巧。

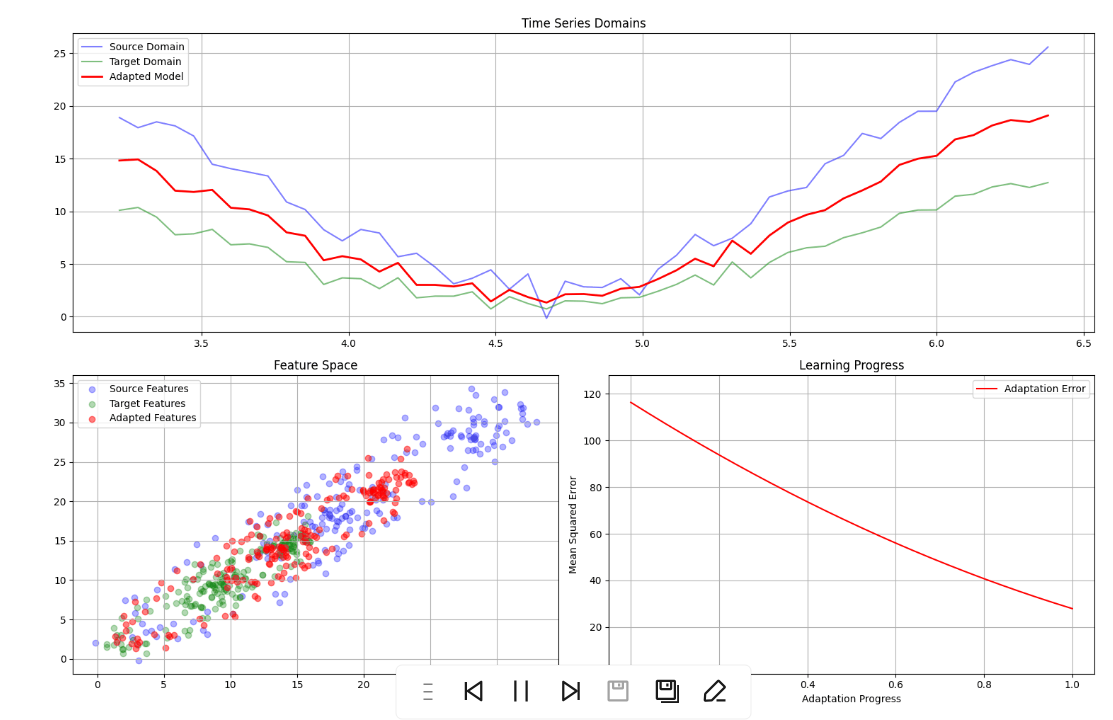

这段代码展示了时间序列中迁移学习的几种关键方法:

- 使用中间层输出的特征迁移

- 微调预训练模型

- 处理尺度差异的领域适应

- 不同方法的评估和可视化

每个部分都包含注释,解释代码的目的和功能。该实现允许对不同架构、超参数和迁移学习策略进行实验。

基本设置和数据准备

import numpy as np

import pandas as pd

import tensorflow as tf

from sklearn.preprocessing import MinMaxScaler

from tensorflow.keras.models import Sequential, Model

from tensorflow.keras.layers import LSTM, Dense, Input

# Helper function to create time series sequences

def create_sequences(data, seq_length):

sequences = []

for i in range(len(data) - seq_length):

sequences.append(data[i:(i + seq_length)])

return np.array(sequences)

# Load and prepare source domain data (e.g., energy consumption)

source_data = pd.read_csv('energy_consumption.csv')

source_scaler = MinMaxScaler()

source_scaled = source_scaler.fit_transform(source_data[['consumption']])

source_sequences = create_sequences(source_scaled, seq_length=24)

# Load and prepare target domain data (e.g., solar production)

target_data = pd.read_csv('solar_production.csv')

target_scaler = MinMaxScaler()

target_scaled = target_scaler.fit_transform(target_data[['production']])

target_sequences = create_sequences(target_scaled, seq_length=24)

为源域构建基础模型

def create_base_model(sequence_length, n_features=1):create_base_model(sequence_length, n_features=1):

model = Sequential([

LSTM(64, input_shape=(sequence_length, n_features), return_sequences=True),

LSTM(32),

Dense(16, activation='relu'),

Dense(1)

])

model.compile(optimizer='adam', loss='mse')

return model

# Train base model on source domain

source_model = create_base_model(24)

source_model.fit(

source_sequences[:-1],

source_scaled[24:],

epochs=50,

batch_size=32,

validation_split=0.2

)

基于特征的迁移学习

# Extract features from intermediate layer

def create_feature_extractor(base_model, layer_name='lstm_1'):

return Model(

inputs=base_model.input,

outputs=base_model.get_layer(layer_name).output

)

feature_extractor = create_feature_extractor(source_model)

# Create new model using transferred features

def create_transfer_model(feature_extractor, sequence_length):

inputs = Input(shape=(sequence_length, 1))

features = feature_extractor(inputs)

x = LSTM(16)(features)

outputs = Dense(1)(x)

model = Model(inputs=inputs, outputs=outputs)

model.compile(optimizer='adam', loss='mse')

return model

transfer_model = create_transfer_model(feature_extractor, 24)

微调方法

def create_fine_tuning_model(base_model, trainable_layers=1):

# Freeze early layers

for layer in base_model.layers[:-trainable_layers]:

layer.trainable = False

return base_model

# Clone source model for fine-tuning

fine_tune_model = tf.keras.models.clone_model(source_model)

fine_tune_model.set_weights(source_model.get_weights())

fine_tune_model = create_fine_tuning_model(fine_tune_model)

# Fine-tune on target domain

fine_tune_model.fit(

target_sequences[:-1],

target_scaled[24:],

epochs=20,

batch_size=32,

validation_split=0.2

)

领域适应

class DomainAdapter:

def __init__(self, source_scaler, target_scaler):

self.source_scaler = source_scaler

self.target_scaler = target_scaler

def adapt_sequence(self, sequence, from_domain='source', to_domain='target'):

if from_domain == 'source' and to_domain == 'target':

# Inverse transform to original scale

sequence_orig = self.source_scaler.inverse_transform(sequence)

# Transform to target scale

return self.target_scaler.transform(sequence_orig)

else:

sequence_orig = self.target_scaler.inverse_transform(sequence)

return self.source_scaler.transform(sequence_orig)

# Create and use domain adapter

adapter = DomainAdapter(source_scaler, target_scaler)

adapted_sequences = adapter.adapt_sequence(source_sequences)

评估与比较

def evaluate_models(models, test_sequences, test_targets):

results = {}

for name, model in models.items():

predictions = model.predict(test_sequences)

mse = tf.keras.losses.MSE(test_targets, predictions)

mae = tf.keras.losses.MAE(test_targets, predictions)

results[name] = {'MSE': float(mse), 'MAE': float(mae)}

return pd.DataFrame(results).T

# Compare different approaches

models = {

'Base Model': source_model,

'Transfer Learning': transfer_model,

'Fine-tuned': fine_tune_model

}

results = evaluate_models(

models,

target_sequences[-100:],

target_scaled[-100:]

)

print("\nModel Comparison:")

print(results)

结果可视化

import matplotlib.pyplot as plt.pyplot as plt

def plot_predictions(models, test_sequences, true_values, scaler):

plt.figure(figsize=(15, 6))

# Plot true values

plt.plot(scaler.inverse_transform(true_values),

label='Actual', linewidth=2)

# Plot predictions from each model

for name, model in models.items():

predictions = model.predict(test_sequences)

plt.plot(scaler.inverse_transform(predictions),

label=f'{name} Predictions', linestyle='--')

plt.title('Model Predictions Comparison')

plt.legend()

plt.grid(True)

plt.show()

# Visualize results

plot_predictions(

models,

target_sequences[-100:],

target_scaled[-100:],

target_scaler

)

应用与成功案例

迁移学习在各种时间序列应用中展现出了显著的成效。在天气预报中,利用数据丰富的地区训练出的模型有助于改进历史数据有限的地区的预测。在医疗保健领域,从大规模患者群体中学习到的模式被应用到罕见病监测中,那里数据稀缺。金融市场分析通过跨不同市场和资产类别调整模型,从迁移学习中受益,尽管表面存在差异,但能识别出潜在的共同模式。

最佳实践和实施策略

在时间序列分析中成功实施迁移学习需要关注几个关键原则。首先,源域和目标域在其时间模式或底层生成过程中应具有有意义的相似性。其次,迁移学习方法应考虑域之间在规模、采样频率和噪声水平上的差异。第三,验证策略必须仔细评估迁移的知识是否提高了目标域的性能,或是否可能降低了性能。

未来方向

时间序列分析中的迁移学习领域正在迅速发展。新兴领域包括学习如何有效迁移知识的元学习方法、自动化领域适应技术,以及同时处理多个源域的方法。将因果推断与迁移学习相结合,通过识别真正可泛化的模式与虚假相关性,有望实现更稳健的知识迁移。

迁移学习是突破传统数据限制、扩展时间序列分析应用范围的有力工具。通过跨域共享知识,它加速了模型开发,并在数据稀缺的场景中提高了预测准确性。随着我们对时间模式迁移理解的加深和新技术的涌现,迁移学习将继续拓展时间序列分析在多种应用中的可能性。