探索DeepEP:Deepseek开源周第二天的亮点

DeepSeek开源周第二天的深入探索,在这一天,他们发布了DeepEP——一个颠覆性的开源EP通信库,用于MoE(混合专家)模型的训练和推理。

什么是DeepSeek的开源周,以及它为何重要?

首先,我们来铺垫一下背景。DeepSeek作为人工智能领域的佼佼者,启动了开源周活动,以展示其对透明度、合作和创新的承诺。在第一天,他们推出了FlashMLA,这是一种极快的大型语言模型架构。现在,到了第二天,他们发布了DeepEP,相信我,这是一件大事。

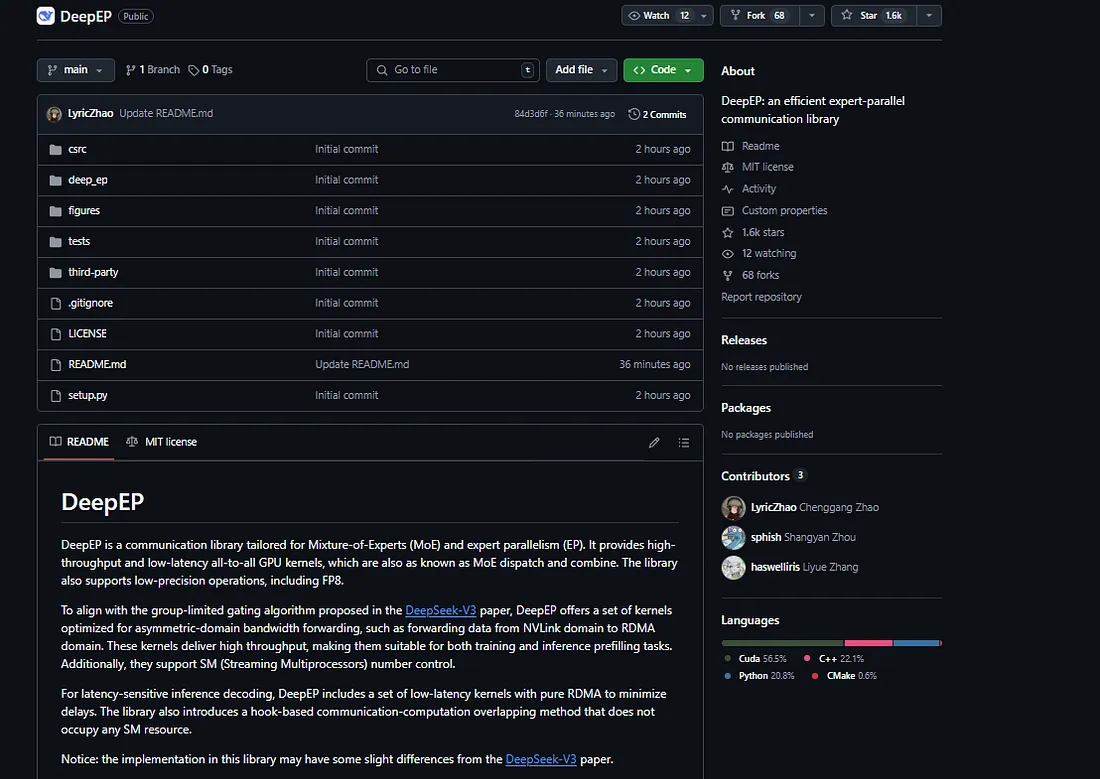

像这样的开源项目使前沿技术得以普及,让全球的开发者、研究人员和企业都能基于DeepSeek的创新进行构建。无论你是在开发用于医疗诊断、天气预报还是国防模拟的AI模型,DeepEP都提供了工具来助力你的工作。此外,所有这些都在GitHub上可用,使得任何人都可以轻松参与并做出贡献。

那么,这为什么重要呢?在一个AI竞争日益激烈的世界里——尤其是像DeepSeek-R1这样的模型正掀起波澜——像DeepEP这样的开源项目让竞争环境更加公平。它们给了小型团队和独立开发者与大玩家竞争的机会。让我们来深入了解一下DeepEP带来了什么。

DeepEP发布:这个库为何能改变游戏规则?

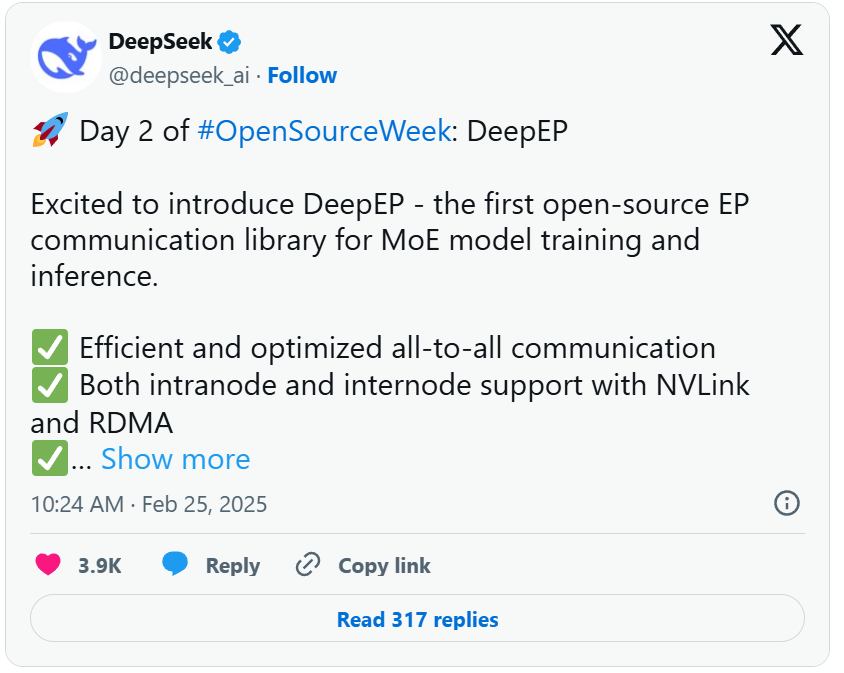

2025年2月25日,DeepSeek在X(原Twitter)上发布了一条充满兴奋的推文,宣布了DeepEP的诞生。

以下是他们分享的内容:DeepEP是“首个用于MoE模型训练和推理的开源EP通信库”。但这意味着什么,你又为什么要关心呢?

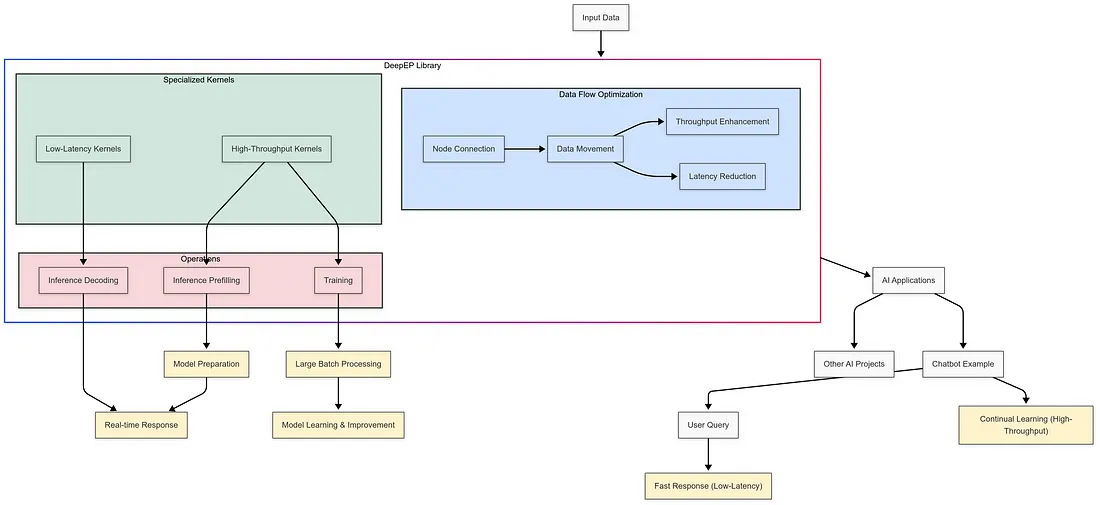

MoE模型的高效全对全通信

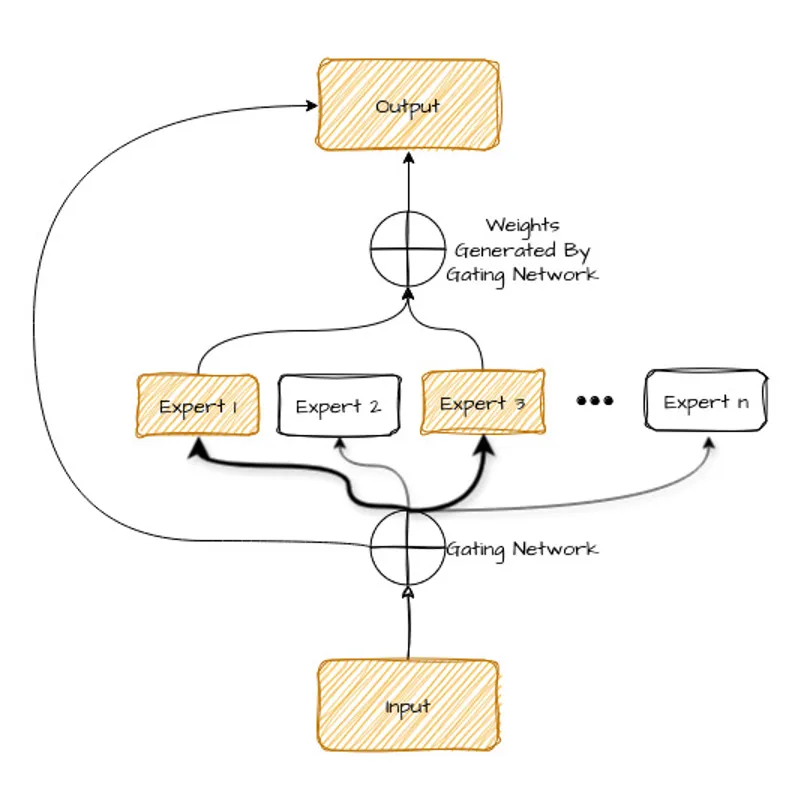

MoE模型,即混合专家模型,是一种AI架构,它通过将任务分配给专门的“专家”模型来提高效率和性能。然而,训练和运行这些模型需要节点之间(无论是单机内的节点间还是多台机器间的节点间)的无缝通信。DeepEP通过优化的全对全通信解决了这一问题,确保数据流畅且快速地传输。

这种效率对于扩展AI模型以处理大规模数据集(如医学研究或气候建模中使用的数据集)至关重要。DeepSeek对这一方面的关注表明,他们认真对待解决现实世界中的AI挑战。

支持使用NVLink和RDMA的单机内和跨机通信

DeepEP不仅仅提供基本的通信功能——它还支持使用尖端技术(如NVLink和RDMA(远程直接内存访问))的单机内和跨机连接。NVLink是NVIDIA的高速互连技术,而RDMA可以减少数据传输的延迟,这两项技术对大规模AI系统来说具有颠覆性的意义。

想象一下,你正在构建一个混合专家模型来预测全球天气模式。DeepEP对这些技术的支持确保你的系统能够处理大规模的数据传输,而不会出现瓶颈,使其更快、更可靠。这对于时间至关重要的行业来说尤其重要,比如灾害应对或实时分析。

高吞吐量和低延迟内核

DeepEP不仅仅连接节点——它还优化了数据在节点之间的传输方式。该库包括用于训练和推理预填充的高吞吐量内核,以及用于推理解码的低延迟内核。用通俗易懂的话来说,这意味着DeepEP可以在训练期间快速处理大批量数据,并在实时推理期间提供快速响应。

例如,如果你使用DeepEP来驱动一个聊天机器人,低延迟内核可以确保用户获得快速响应,而高吞吐量内核则能让模型随着时间的推移不断学习和改进。这就像为你的AI项目配备了一个超级引擎。

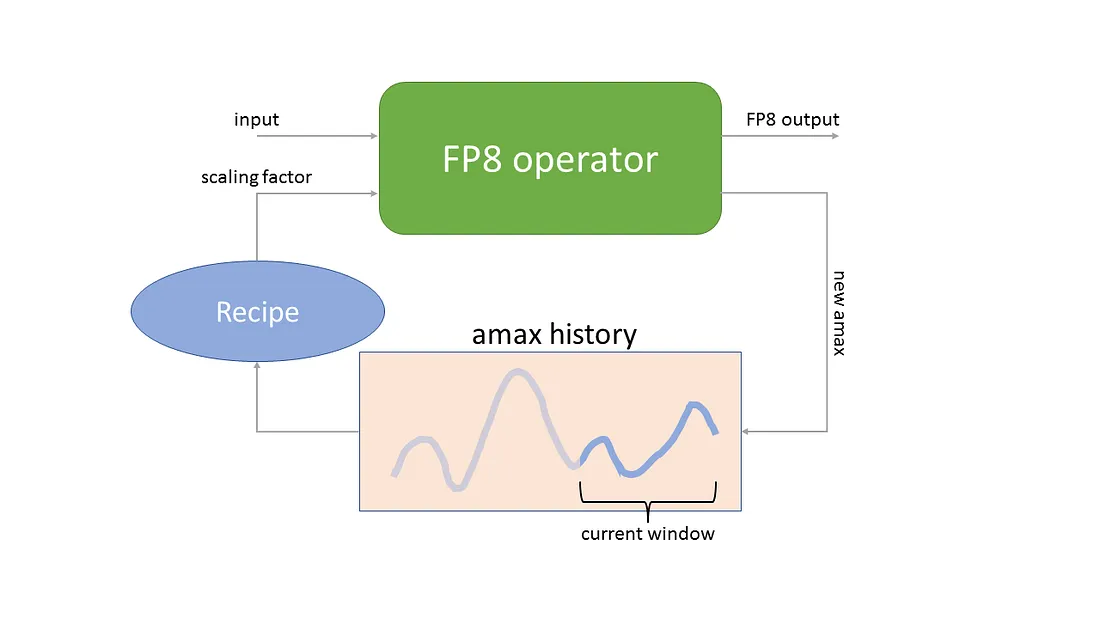

原生FP8分派支持

DeepEP最令人兴奋的功能之一是其原生的FP8(8位浮点数)分派支持。FP8是一种较新的数据格式,可以减少内存使用并加快计算速度,因此非常适合大规模AI模型。通过将此功能内置于DeepEP中,DeepSeek为该库面向下一代AI硬件和算法做好了准备。

随着AI模型变得越来越大、越来越复杂,这一点尤其重要。借助FP8,你可以更高效地训练和运行模型,从而节省计算资源和能源——在我们致力于技术可持续性的当下,这是一个重要的考量因素。

灵活的GPU资源控制

最后,DeepEP提供灵活的GPU资源控制,允许开发者将计算和通信任务重叠进行。这意味着你的GPU可以在进行计算的同时发送或接收数据,减少停机时间并提高整体性能。

如果你正在为一个大型AI项目管理一个GPU集群,这一功能可以为你节省时间和金钱。对于研究人员和企业来说,这是一个实用的解决方案,确保DeepEP能够根据你的需求进行扩展。

为什么DeepEP在开源AI领域脱颖而出

那么,DeepEP听起来令人印象深刻——但与其他开源AI工具相比,它表现如何呢?让我们来剖析一下为什么这个库如此出众。

弥补MoE模型开发的空白

混合专家模型(Mixture of Experts)因其比传统单体模型更高效而越来越受欢迎。然而,由于通信开销,大规模构建和部署MoE模型一直具有挑战性。DeepEP通过提供专为MoE系统定制的EP(专家并行)通信专用库,弥补了这一空白。

与通用通信库相比,DeepEP专注于MoE模型,使其更加专业化和有效。这就像为特定工作配备了一个定制工具——一切都完美契合,你会得到更好的结果。

开源可访问性

DeepSeek决定将DeepEP开源,这对AI社区来说是一个巨大的胜利。通过在GitHub上分享这个库,他们邀请全球开发者使用、改进和在此基础上进行构建。这种协作方式加速了创新,特别是对于可能没有资源从零开始开发此类工具的小型团队或组织来说。

此外,开源项目促进了透明度,使社区能够审计和验证技术。在AI伦理和问责制成为热门话题的时代,DeepSeek的这一举措建立了信任并推动了采用。

全球AI竞赛中的竞争优势

正如最近关于DeepSeek-R1(DeepSeek的另一项突破性模型)的讨论中所强调的,全球AI竞赛正在加剧。包括DeepSeek在内的中国公司正在取得显著进展,并且往往得到政府的支持。DeepEP的发布表明,DeepSeek不仅在竞争——它还在引领潮流。

通过将DeepEP作为开源工具提供,DeepSeek既巩固了自己的地位,又赋予了其他人创新的能力。这种双重策略可能会重塑全球AI基础设施的发展方式,特别是在美国等地区,那里的繁文缛节正在减缓进步。

如何开始使用DeepEP?

想要亲自尝试DeepEP吗?以下是你如何入手的方法。

访问GitHub仓库

前往DeepSeek的[https://github.com/deepseek-ai/DeepEP,访问源代码、文档和社区资源。该仓库包含了你开始所需的一切,从安装说明到示例实现。]

探索文档

DeepEP的文档会带你了解其功能,包括如何利用NVLink、RDMA、FP8支持等。无论你是经验丰富的AI开发者还是好奇的新手,文档都提供了清晰的指导,帮助你快速上手。

使用Apidog进行实验

既然我们谈论的是AI创新,为什么不使用像Apidog这样的工具来测试和将DeepEP集成到你的工作流程中呢?今天免费下载Apidog,并探索它如何帮助你构建、测试和部署与DeepEP和其他AI项目相关的API。

最终思考:为什么DeepEP对你至关重要

在开源周期间,DeepSeek在第二天发布的DeepEP不仅仅是一个技术里程碑——它是迈向一个更加协作、易于访问且强大的AI未来的一步。无论你是开发者、研究人员还是技术爱好者,DeepEP都提供了工具来应对使用MoE模型时遇到的大挑战,这得益于其高效的通信、硬件支持和开源性质。