扩散LLM的崛起:这是Transformer大型语言模型(LLM)的终结吗?

大型语言模型(LLM)的发展正进入一个关键阶段,扩散架构的出现标志着这一点。这些模型由Inception Labs通过其新的Mercury系统引领,向长期以来占主导地位的Transformer系统发起了重大挑战。Mercury引入了一种新颖的方法,承诺更快的标记生成速度,同时保持与现有模型相当的性能水平。这一创新有可能重塑人工智能处理文本、图像和视频生成的方式,为更先进的多模态应用铺平道路,这些应用可能会重新定义AI的格局。更快的标记生成速度同时保持与现有模型相当的性能水平。这一创新有可能重塑人工智能处理文本、图像和视频生成的方式,为更先进的多模态应用铺平道路,这些应用可能会重新定义AI的格局。

“Mercury的速度比前沿速度优化的LLM快10倍。我们的模型在NVIDIA H100s上运行速度超过1000个标记/秒,这一速度以前只有使用定制芯片才能实现。Mercury系列的扩散大型语言模型(dLLMs)是新一代的LLM,推动了快速、高质量文本生成的前沿。”

与一次生成一个标记的Transformers不同,Mercury通过并行生成标记大胆跃进,大幅缩短响应时间。结果是?生成速度提高了多达10倍,而不影响质量。但这不仅仅是关于速度——这关乎于为AI解锁新的可能性,从实时应用到多模态能力,如生成文本、图像,甚至视频。如果你曾经想知道AI的未来会是什么样子,你将迎来一个激动人心的旅程。

Mercury扩散LLM

简要总结要点:

- 扩散型LLM,如Inception Labs的Mercury,引入了一种新的架构,可以并行生成标记,与传统的Transformer模型相比,提供了更快的处理速度。

- Mercury实现了每秒高达1,000个标记的速度,使其比优化的Transformer模型快10倍,而不影响输出质量,并专为以编码为重点的任务量身定制。

- Mercury的扩散型方法实现了多模态能力,包括文本、图像和视频生成,使其成为一个多功能工具,适用于创造性和复杂问题解决的应用。

- 尽管速度和潜力巨大,Mercury面临着处理复杂提示和使用限制等挑战,突显了进一步改进和扩展的领域。

- 扩散型LLM的兴起标志着AI研究的转变,Mercury引领潮流,并引发了关于Transformer主导架构未来的疑问。

理解扩散型LLM

扩散型LLM代表了语言生成方式的根本转变。与依赖顺序自回归建模一次生成一个标记的Transformers不同,扩散模型通过并行生成标记来操作。这种方法受到图像和视频生成中使用的扩散过程的启发,其中噪声被逐步去除以创建连贯的输出。通过采用这种并行标记生成策略,扩散型LLM旨在克服与顺序处理相关的延迟挑战。结果是一个更快且潜在更具可扩展性的高质量输出生成解决方案,使这些模型特别适合需要实时性能的应用。

Mercury:重新定义速度和效率的模型

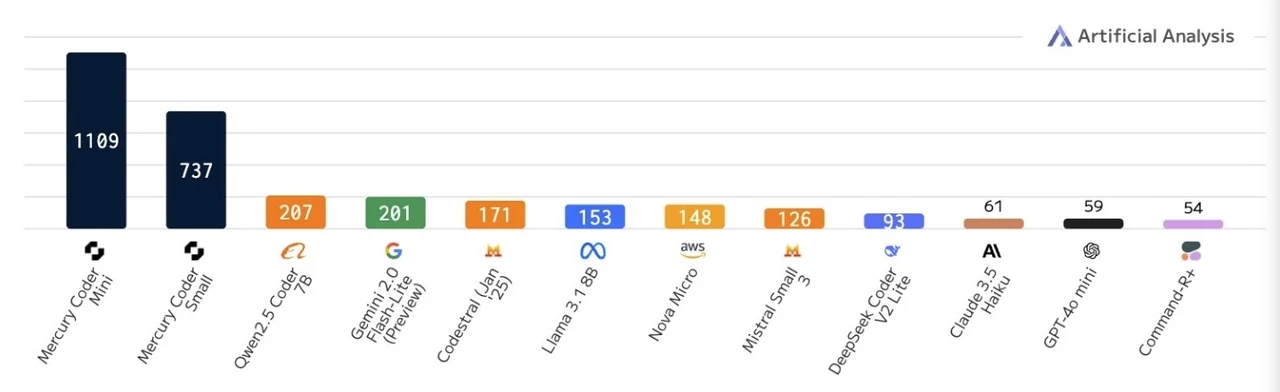

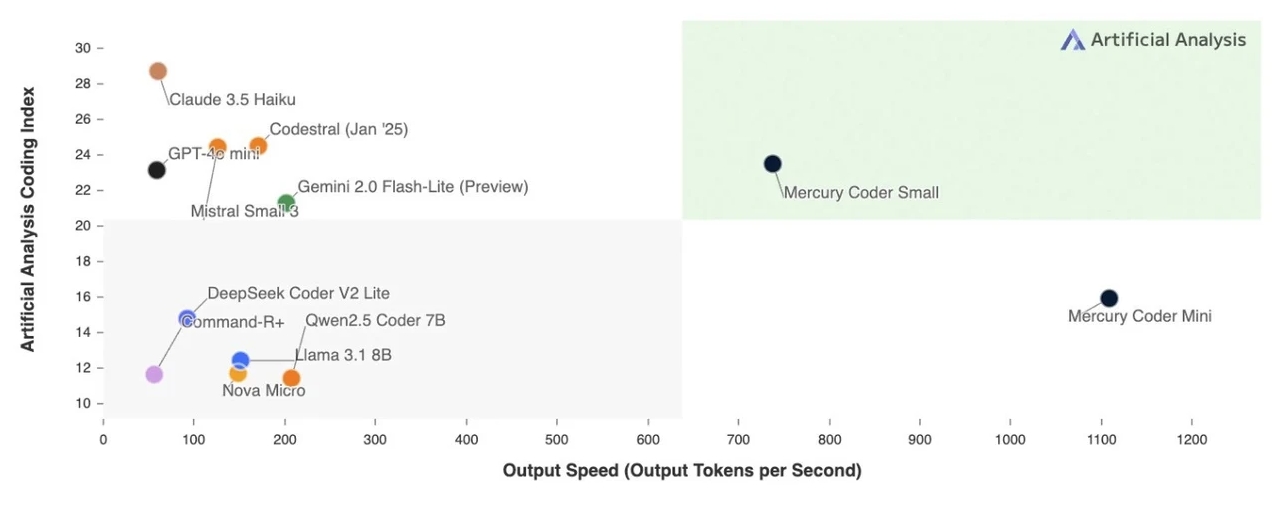

Inception Labs的Mercury模型在LLM技术中设立了新的标准。能够生成高达每秒1,000个标记在标准Nvidia硬件上,Mercury据称比最优化的Transformer模型快10倍。这一显著的性能提升是在不影响生成输出质量的情况下实现的,使Mercury成为需要快速处理任务的有吸引力的选择。目前,Mercury有两个专门版本可用——Mercury Coder Mini和Mercury Coder Small——都专为从事编码项目的开发人员量身定制。这些版本突显了Mercury的多功能性及其在保持核心优势的同时迎合利基应用的潜力。

Mercury如何与Transformers对比

Mercury经过严格的基准测试,与领先的Transformer模型如Gemini 2.0 Flashlight、GPT 40 Mini以及像Quin 2.0和Deep Coder V2 Light这样的开放权重模型进行比较。虽然其整体性能与较小的Transformer模型接近,但Mercury的并行标记生成使其在速度上具有明显优势。这一能力使其特别适合需要实时响应或大规模数据处理的应用,在这些应用中,效率和速度至关重要。通过满足这些特定需求,Mercury将自己定位为传统Transformer系统的一个有吸引力的替代方案,特别是在优先考虑延迟减少的场景中。

应用和更广泛的潜力

Mercury的扩散型架构将其效用扩展到远远超出文本生成的范围。其生成图像和视频的能力使其成为探索创造性和多媒体应用的行业的多功能工具。这种多模态能力为娱乐、广告和内容创作等行业开辟了新的可能性,这些行业对高质量AI生成视觉效果的需求正在增长。此外,Mercury增强的推理能力和代理工作流程使其成为解决复杂问题解决任务的有力候选者,如高级编码、数据分析和决策过程。并行标记生成机制进一步提高了其效率,允许在从客户服务聊天机器人到大规模内容生成系统的广泛用例中提供更快的解决方案。

挑战和当前限制

尽管前景光明,Mercury并非没有挑战。模型的早期版本在处理高度复杂或模糊的提示时表现出困难,这突显了需要进一步改进的领域。此外,目前的使用限制为每小时10次请求,这一限制可能会阻碍其在高需求环境中的采用。这些限制强调了继续开发和优化的必要性,以充分释放扩散型LLM的潜力。解决这些早期限制对于Mercury实现更广泛的采用并有效竞争于已建立的Transformer系统至关重要。

扩散型LLM的未来

Inception Labs计划通过将Mercury集成到API中来扩大其影响力,使开发人员能够无缝地将其功能整合到工作流程中。这种集成可能会加速LLM应用的创新,促进更高效和多功能AI系统的发展。Mercury的成功也引发了关于LLM设计未来的重要问题,扩散型模型作为可行的替代方案出现。随着这些模型的不断成熟,它们可能会激发一波新的架构,优先考虑速度、可扩展性和多模态能力。

探索其他实验性架构

虽然Mercury在基于扩散的LLM中处于领先地位,但它并不是唯一正在开发的实验性架构。Liquid AI的液体基础模型(LFM)代表了另一种超越Transformer的尝试。然而,早期结果表明,LFM尚未达到Mercury的性能或效率。这些努力反映了人们对多样化LLM架构的日益兴趣,以解决现有模型的局限性。对替代方法的探索,如LFM和基于扩散的系统,标志着AI研究的更广泛转变,强调了创新以克服传统Transformer设计限制的必要性。

塑造AI的下一个篇章

基于扩散的LLM的出现标志着人工智能演变中的一个重要里程碑。Mercury凭借其并行令牌生成和多模态能力,挑战了基于Transformer系统的主导地位,提供了一种更快且更灵活的替代方案。虽然仍处于早期阶段,但这一创新有可能重塑AI的未来,推动文本、图像和视频生成的进步。随着基于扩散的模型不断发展,它们可能会定义大型语言模型开发的下一个篇章,推动AI在广泛应用中的成就边界。