Google DeepMind推出两款新AI模型助力机器人技术

Google DeepMind近日发布了两款新的AI模型,旨在帮助机器人执行更广泛的现实世界任务。其中一款名为Gemini Robotics,这是一款视觉-语言-行动模型,能够理解新情境,即使它之前并未接受过相关训练。

Gemini Robotics基于Google旗舰AI模型Gemini 2.0构建。在新闻发布会上,Google DeepMind机器人部门高级总监Carolina Parada表示,Gemini Robotics通过融合Gemini的多模态世界理解能力,并添加物理行动作为新模态,将其转移到现实世界中。

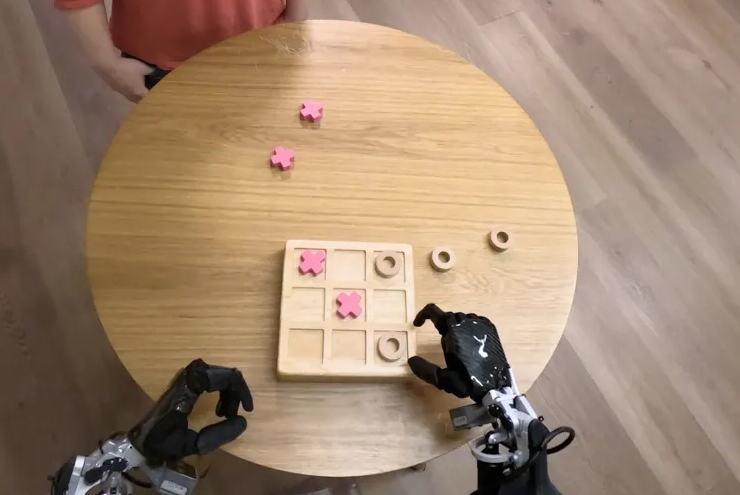

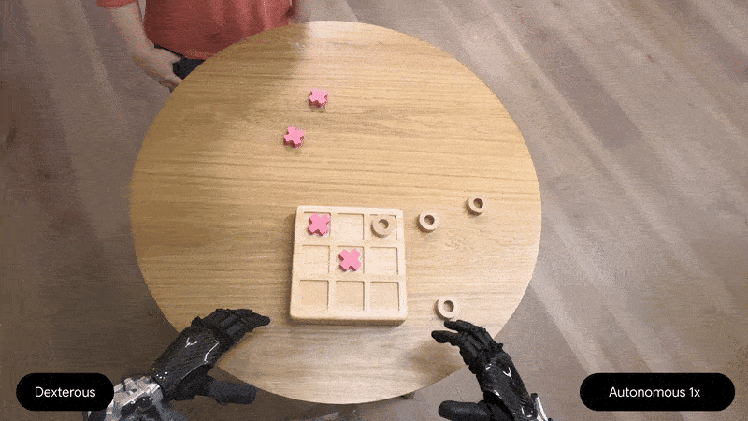

这款新模型在三个关键领域取得了进展,Google DeepMind认为这些领域对构建有用的机器人至关重要:通用性、交互性和灵巧性。Gemini Robotics不仅能够泛化新场景,还在与人及环境的交互方面表现更佳,同时能执行更精确的物理任务,如折纸或拧开瓶盖。

Parada指出,过去在通用机器人技术中,这三个领域各自取得了进展,但现在通过单一模型,在所有三个领域都实现了性能的显著提升。这使得能够构建出能力更强、响应更快、对环境变化更鲁棒的机器人。

此外,Google DeepMind还推出了Gemini Robotics-ER(具身推理模型),该公司称其为一种先进的视觉语言模型,能够“理解我们复杂且动态的世界”。例如,在打包午餐盒时,该模型需要知道物品的位置、如何打开午餐盒、如何抓取物品以及将它们放在哪里。Gemini Robotics-ER设计为与现有的低级控制器(控制机器人运动的系统)连接,从而启用由该模型驱动的新功能。

在安全性方面,Google DeepMind研究员Vikas Sindhwani告诉记者,公司正在开发一种“分层方法”,并补充说Gemini Robotics-ER模型“被训练来评估在给定场景中执行潜在行动是否安全”。该公司还发布了新的基准和框架,以推动AI行业的安全性研究。去年,Google DeepMind引入了其“机器人宪法”,这是一套受艾萨克·阿西莫夫启发的机器人行为规则。

目前,Google DeepMind正与Apptronik合作“构建下一代仿人机器人”,并向包括Agile Robots、Agility Robotics、Boston Dynamics和Enchanted Tools在内的“受信任测试者”提供Gemini Robotics-ER模型的访问权限。