Nvidia宣布全面推出用于构建AI代理的 NeMo 工具

Nvidia公司 今天宣布全面推出 NeMo 微服务,这是一组工具,旨在帮助开发人员 通过大规模利用 AI 推理和信息系统来更快地启动人工智能代理。

座席已成为创建“数字团队成员”的焦点,这些“数字团队成员”能够通过接受订单、发现信息和进行主动工作来提高知识和服务工作者的工作效率。

与 AI 聊天机器人不同,代理可以在很少或没有人工监督的情况下采取自主行动,但他们需要数据来做出准确有效的决策,作为他们推理的一部分。 对于专有知识尤其如此,这些知识可能被锁定在公司防火墙后面或使用快速变化的实时信息时。

“如果没有源源不断的高质量输入(来自数据库、用户交互或真实世界的信号),代理的理解可能会减弱,使响应不那么可靠,从而降低代理的工作效率,”Nvidia 企业生成式 AI 软件高级总监 Joey Conway 说。

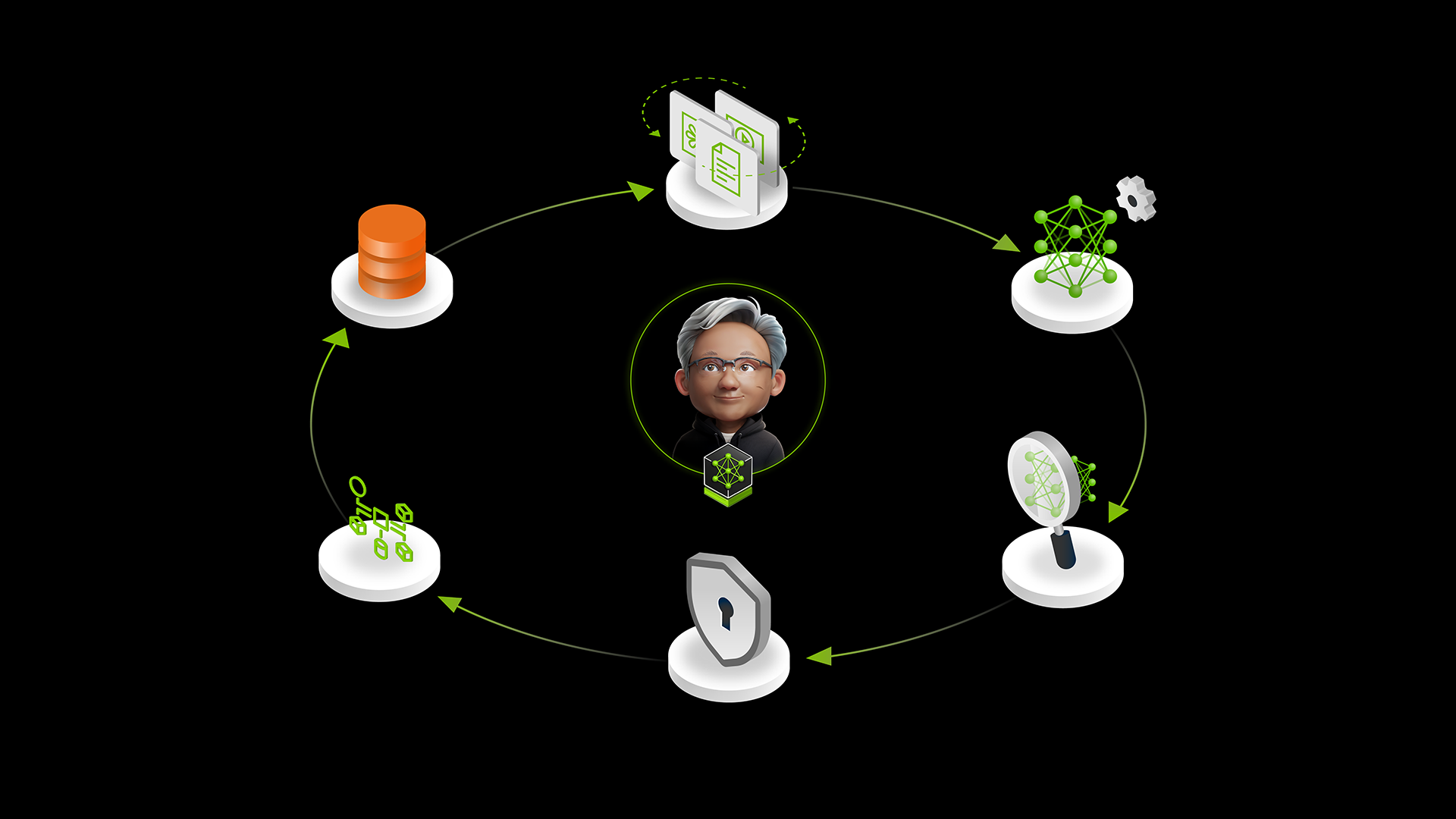

为了帮助开发人员快速构建和部署代理,Nvidia 发布了 NeMo 微服务,包括 Customizer、Evaluator、Guardrails、Retriever 和 Curator。它们旨在简化企业 AI 工程师在扩展和访问数据时构建代理 AI 体验的体验。

Customizer 通过提供高达 1.8 倍的训练吞吐量来帮助进行大型语言模型微调。它提供了一个应用程序编程接口,使开发人员能够快速管理模型,以便他们可以在部署数据集之前对其进行拟合。Evaluator 只需 5 次 API 调用,即可根据自定义和行业基准简化对 AI 模型和工作流的评估。

Guardrails 在 AI 模型或代理上运行,以防止其以不安全或越界的方式运行。它可以以 1.4 倍的效率提供额外的合规性,并且延迟仅增加半秒。Retriever 在 GTC 2025 上发布,允许开发人员构建可以从系统中提取数据并准确处理数据的代理,从而使他们能够构建复杂的 AI 数据管道,例如检索增强生成。

“NeMo 微服务易于作,可以在任何加速计算基础设施上运行,包括本地和云,同时提供企业级安全性、稳定性和支持,”Conway 补充道。

Nvidia 设计了 NeMo 工具,以便具有一般 AI 知识的开发人员可以通过 API 调用访问它们,以启动并运行 AI 代理。 目前,企业开始构建复杂的多智能体系统,其中数百个专家座席协同工作以实现统一目标,同时与人类团队成员一起工作。

为众多型号和合作伙伴提供广泛支持

NeMo 微服务支持大量流行的开放式 AI 模型,包括 Meta Platforms Inc. 的 Llama、Microsoft Phi 系列小语言模型、Google LLC 的 Gemma 和 Mistral。

Nvidia 的 Llama Nemotron Ultra 目前在科学推理、编码和复杂数学基准测试方面排名第一,也可以通过微服务访问。

许多领先的人工智能服务提供商,包括Cloudera Inc.、Datadog Inc.、Dataiku、DataRobot Inc.、DataStax Inc.、SuperAnnotate AI Inc.和Weights & Biases Inc.,都已将NeMo微服务纳入他们的平台。开发人员现在可以通过流行的 AI 框架(如 CrewAI、Haystack by Deepset、LangChain、LlamaIndex 和 Llamastack)开始在他们的流程中使用这些微服务。

使用新的 NeMo 微服务,Nvidia 合作伙伴和科技公司构建了 AI 代理平台,并让数字团队成员完成更多工作。

例如,AT&T Inc. 使用 NeMo Customizer 和 Evaluator 通过微调 Mistral 7B 模型以提供个性化服务、防止欺诈和优化网络性能,从而提高 AI 代理的准确性。 BlackRock Inc. 正在其 Aladdin 技术平台中使用微服务,通过通用数据语言统一投资管理。