模型:

JosephusCheung/Guanaco

英文

英文

现在您可以在Colab上免费运行T4 GPU

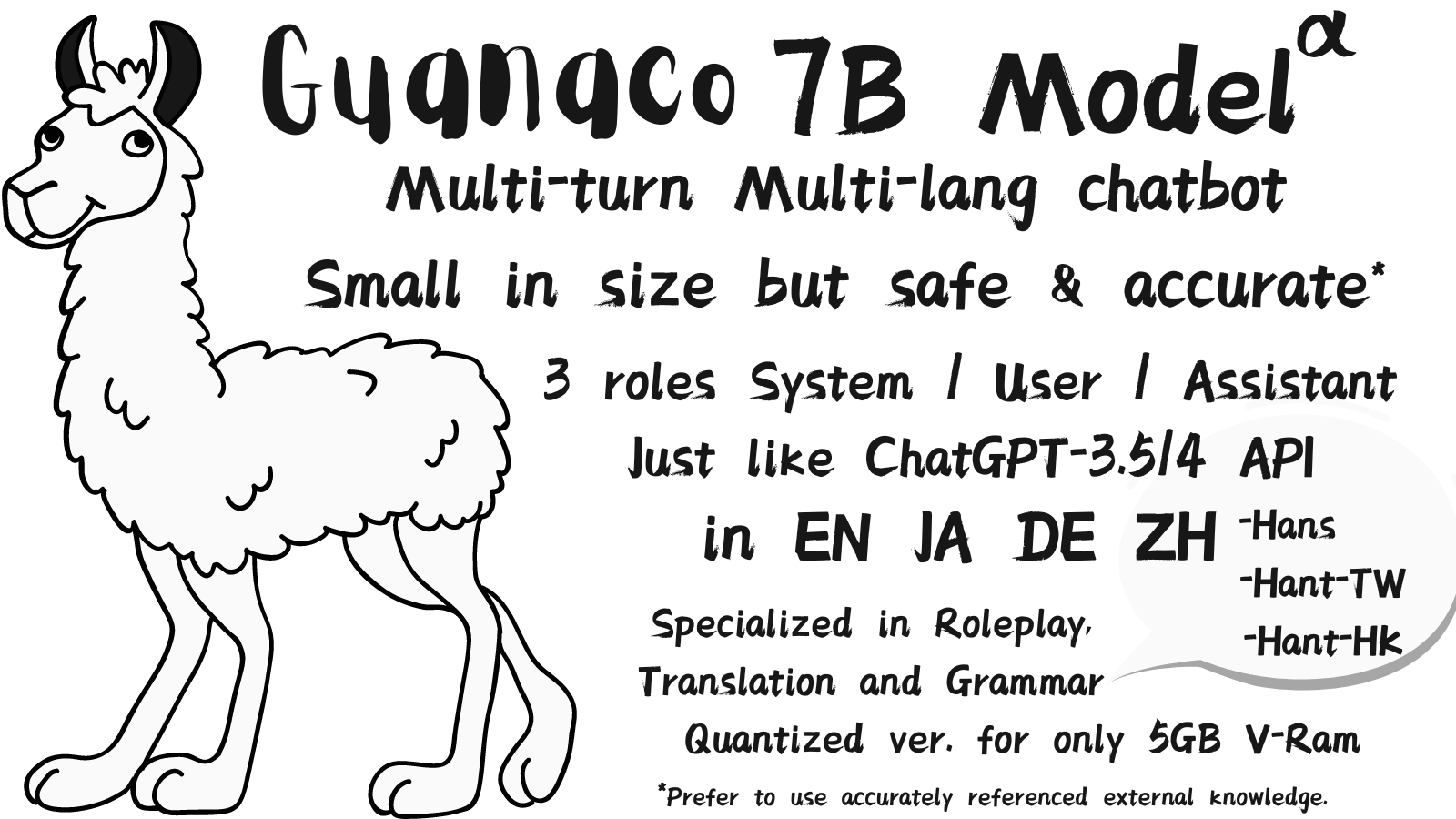

强烈建议为此模型使用fp16推理,因为8位精度可能会显著影响性能。如果您需要更适合消费级硬件的版本,请使用特殊的量化版本,只需要5GB以上的V-RAM

JosephusCheung/GuanacoOnConsumerHardware 。我们鼓励您使用来自GitHub的最新版本的transformers。

Guanaco是基于Meta的LLaMA 7B模型构建的先进指令跟随语言模型。在Alpaca模型的初始52K数据集的基础上,还加入了额外的534K+条目,涵盖了英语、简体中文、繁体中文(台湾)、繁体中文(香港)、日语、德语以及各种语言和语法任务。这些丰富的数据使得Guanaco在多语言环境中表现出色。

为了促进研究的开放性和可复制性,我们已经公开了Guanaco数据集,并在此处发布了模型权重。通过提供这些资源,我们旨在激发更多的研究人员进行相关研究,并共同推进指令跟随语言模型的发展。

衷心感谢 KBlueLeaf 对模型的概念验证、 trained model 和 inference development 的贡献,如果没有他们的努力,这个项目将永远无法实现。

在使用Guanaco模型时,请记住以下几点:

Guanaco模型并未经过有害、偏见或明确内容的筛选。因此,在使用过程中可能会生成不符合道德规范的输出。请在研究或实际应用中谨慎使用该模型。

改进的上下文和提示角色支持:

新的格式设计与ChatGPT类似,可以更好地与Alpaca格式集成,增强整体用户体验。

使用指令作为少量示例上下文,支持多样化的输入和回答,使模型更容易理解并提供准确的用户查询回复。

格式如下:

### Instruction: User: History User Input Assistant: History Assistant Answer ### Input: System: Knowledge User: New User Input ### Response: New Assistant Answer

这种结构化格式有助于更容易跟踪对话历史记录,并在多轮对话中保持上下文。

角色扮演支持:

Guanaco现在支持英语、简体中文、繁体中文、日语和德语的高级角色扮演,类似于Character.AI,使其更适用于不同语言背景的用户。

用户可以指示模型扮演特定角色、历史人物或虚构角色,以及根据他们的输入确定性格。这样可以进行更有趣和沉浸式的对话。

该模型可以使用各种信息源为角色的背景和行为提供知识和上下文,例如百科全书条目、第一人称叙述或个性特征列表。

模型将始终以“角色名称:回复”的格式输出响应,以保持所选择的角色在整个对话中的连贯性,提升用户的体验。

拒绝回答和避免错误回复:

模型已经更新,可以更有效地处理缺乏足够知识或无法提供有效回答的情况。

引入了保留关键词,以指示不同场景并与用户进行更清晰的沟通,在System Prompt中使用:

NO IDEA:表示模型缺乏提供准确答案所需的知识,并会解释给用户听,鼓励他们寻找替代来源。

FORBIDDEN:表示模型由于特定原因(例如法律、道德或安全问题),拒绝回答查询,根据查询的上下文进行推断。

SFW:表示模型拒绝回答某个问题,因为已经经过了NSFW内容的过滤,确保更安全、更适当的用户体验。

持续对话的响应:

Guanaco模型现在可以根据用户的要求继续回答问题或讨论话题,使其更具适应性,更适于延续对话。

由系统、助手和用户角色组成的上下文结构使模型能够进行多轮对话,保持上下文感知的对话,并提供更连贯的回复。

模型现在可以适应角色规定和角色设置,根据用户的偏好提供更沉浸和个性化的对话体验。

重要的是要记住,Guanaco是一个7B参数的模型,任何基于知识的内容都应被视为有可能不准确。我们强烈建议在System Prompt中提供可验证的来源,如维基百科,用于基于知识的回答。在没有来源的情况下,重要的是告知用户这个限制,以防止传播错误信息并保持透明度。

由于该项目与 Stanford Alpaca 之间的格式差异,请参考Guanaco-lora:基于LLaMA训练多语言指令跟随LM的LoRA( https://github.com/KohakuBlueleaf/guanaco-lora )以进行进一步的训练和推理我们的模型。

最新消息

我们注意到领域中最近出现了一种名为QLoRa的方法,我们对此表示关注,因为它试图利用Guanaco的声誉。我们对这样的行为强烈不赞成。就我们所知,QLoRa在数学上缺乏鲁棒性,其性能明显落后于GPTQ和诸如PEFT微调等改进方法。

Guanaco一直在勤奋地发布多语言数据集,自2023年3月以来,同时发布的权重不仅是GPTQ的增强版本,而且还支持多模态VQA,并进行了4位部分优化。尽管在从OpenAI的GPT模型提取数据方面投入了数万美元的资金,但我们仍然认为这些努力是渐进的。

然而,我们的目标是超越渐进:

我们努力不再依赖于OpenAI生成的数据:我们发现依赖GPT生成的数据阻碍了重大突破。此外,在处理多语言任务的不平衡性方面,这种方法已经被证明是灾难性的。

我们专注于增强量化结构和部分本地4位微调:我们对GPTQ-Llama项目深表赞赏,它为最先进的LLM量化铺平了道路。其在7B规模上的独特特性有助于在多语言和多模态任务中取得重大进展。

我们计划利用视觉数据来调整我们的语言模型:我们相信这将从根本上解决语言不平衡、翻译不准确和LLM缺乏图形逻辑的问题。

虽然我们的工作还处于早期阶段,但我们决心在这些领域取得新的突破。我们对QLoRa的做法的批评并不源于敌意,而是基于这样一个根本信念:创新应该扎根于原创性、诚信和实质性的进步。