模型:

Salesforce/blip2-opt-2.7b-coco

英文

英文BLIP-2,OPT-2.7b,在COCO上进行了微调

BLIP-2模型,利用了 OPT-2.7b (一个具有27亿参数的大型语言模型)。这个模型是由Li等人在 BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image Encoders and Large Language Models 中提出,并在 this repository 中首次发布。

免责声明:发布BLIP-2团队未为此模型编写模型卡片,因此此模型卡片是由Hugging Face团队编写的。

模型描述

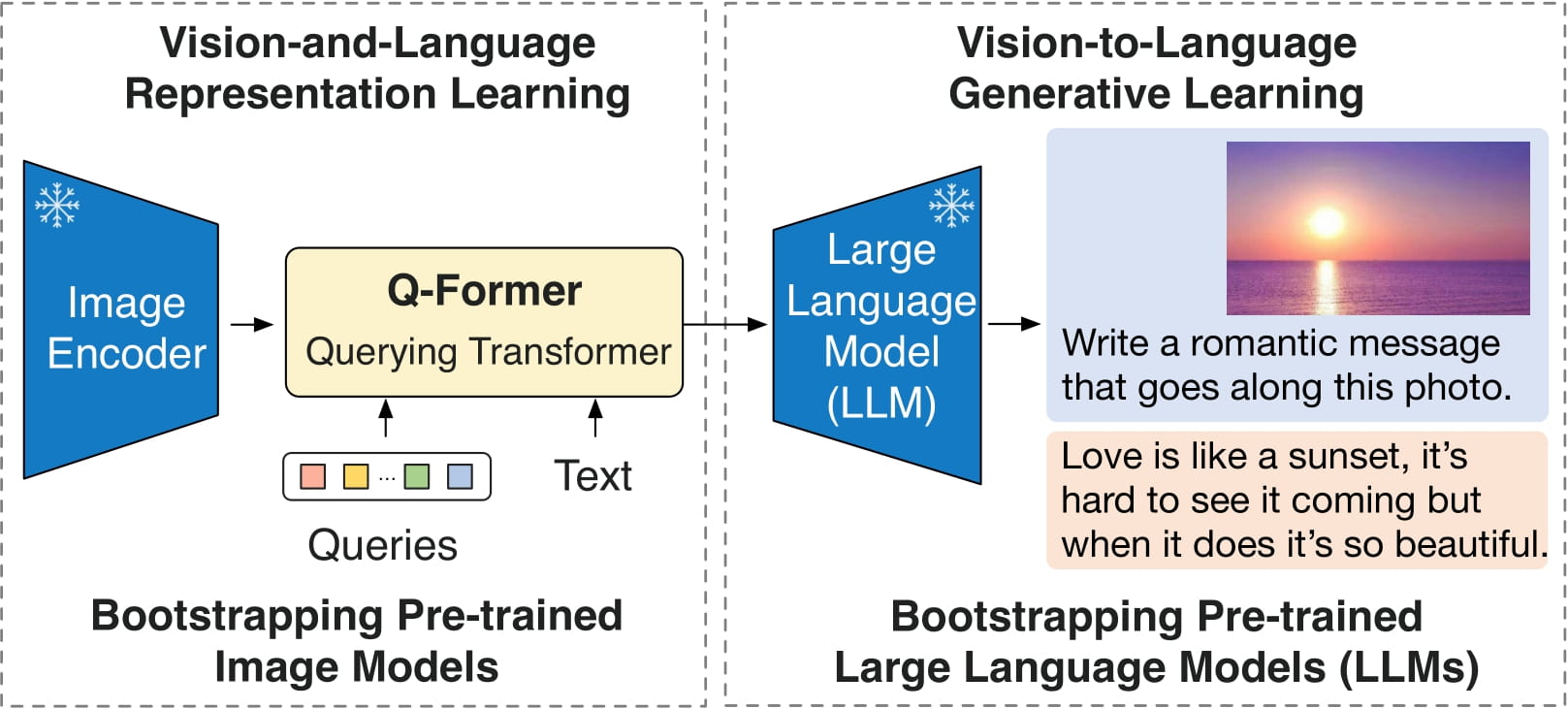

BLIP-2由3个模型组成:一个类似CLIP的图像编码器,一个查询变压器(Q-Former)和一个大型语言模型。

作者从预训练的检查点中初始化图像编码器和大型语言模型的权重,并在训练查询变换器时将它们保持冻结。查询变换器是一个类似BERT的变压器编码器,它将一组“查询标记”映射到查询嵌入,这些嵌入桥接了图像编码器和大型语言模型的嵌入空间之间的差距。

模型的目标很简单,就是根据查询嵌入和先前的文本来预测下一个文本标记。

这使得该模型可以用于以下任务:

- 图像字幕

- 视觉问答(VQA)

- 类似聊天的对话,通过将图像和先前的对话作为提示馈送给模型

直接使用和下游使用

您可以使用原始模型来根据图像和可选文本进行有条件的文本生成。请参阅 model hub ,查找您感兴趣的任务的经过微调的版本。

偏见、风险、限制和伦理考虑

BLIP2-OPT使用现成的OPT作为语言模型。它继承了Meta模型卡片中提到的相同风险和限制。

像其他大型语言模型一样,训练数据的多样性(或缺乏多样性)会对模型的质量产生下游影响,OPT-175B在偏见和安全方面有一定的限制。OPT-175B在生成多样性和产生幻觉方面也可能存在质量问题。总的来说,OPT-175B并不免于困扰现代大型语言模型的一系列问题。

BLIP2是在从互联网收集的图像-文本数据集(例如 LAION )上进行微调的。因此,模型本身可能容易生成等同不适当的内容或复制底层数据中固有的偏见。

BLIP2在真实世界应用中尚未进行测试。不应直接在任何应用程序中部署BLIP2。研究人员应首先仔细评估模型在特定上下文中的安全性和公平性。

如何使用

有关代码示例,请参阅 documentation 。