模型:

TheBloke/wizard-vicuna-13B-GPTQ

英文

英文

Chat & support: my new Discord server

Want to contribute? TheBloke's Patreon page

Wizard-Vicuna-13B-GPTQ

这个repo包含了使用 GPTQ-for-LLaMa 量化为4位GPTQ格式的模型。

这是使用 GPTQ-for-LLaMa 进行量化得到的结果。

可用的存储库

- 4bit GPTQ models for GPU inference .

- 4bit and 5bit GGML models for CPU inference .

- float16 HF format model for GPU inference .

如何轻松下载和在文本生成Web用户界面中使用此模型

像往常一样打开文本生成Web用户界面。

提供的文件

兼容文件 - wizard-vicuna-13B-GPTQ-4bit.compat.no-act-order.safetensors

在“主”分支中 - 默认分支 - 您将找到“wizard-vicuna-13B-GPTQ-4bit.compat.no-act-order.safetensors”

这将适用于所有版本的GPTQ-for-LLaMa。它具有最大的兼容性

它是在没有--act-order参数的情况下创建的。与其他文件相比,它可能具有稍低的推断质量,但保证在所有版本的GPTQ-for-LLaMa和文本生成Web用户界面上工作。

- wizard-vicuna-13B-GPTQ-4bit.compat.no-act-order.safetensors

- 适用于GPTQ-for-LLaMa代码的所有版本,包括Triton和CUDA分支

- 适用于一键安装的文本生成Web用户界面

- 参数:组大小=128g。无动作次序。

- 用于创建GPTQ的命令:

CUDA_VISIBLE_DEVICES=0 python3 llama.py wizard-vicuna-13B-HF c4 --wbits 4 --true-sequential --groupsize 128 --save_safetensors wizard-vicuna-13B-GPTQ-4bit.compat.no-act-order.safetensors

Discord

如需进一步支持以及对这些模型和人工智能的讨论,请加入我们的:

感谢以及如何贡献

感谢 chirper.ai 团队!

我已经有很多人询问是否可以贡献。我喜欢提供模型和帮助人们,并且愿意花更多的时间来做这些工作,同时还可以扩大到诸如精调/训练等新项目。

如果您有能力和意愿做出贡献,我将非常感激,并且这将有助于我继续提供更多的模型,并开始进行新的人工智能项目。

捐助者将在任何关于AI/LLM/模型的问题和请求的优先支持,获得私人Discord房间的访问权限,以及其他福利。

- Patreon: https://patreon.com/TheBlokeAI

- Ko-Fi: https://ko-fi.com/TheBlokeAI

感谢所有慷慨的赞助者和捐助者!

原始WizardVicuna-13B模型卡片

Github页面: https://github.com/melodysdreamj/WizardVicunaLM

WizardVicunaLM

Wizard的数据集+ChatGPT的对话扩展+Vicuna的调整方法

我非常喜欢WizardLM和VicunaLM背后的理念。特别是我喜欢WizardLM更深入和广泛地处理数据集本身的理念,以及VicunaLM通过引入多轮对话来克服单轮对话的局限性的理念。因此,我将这两个理念结合起来创建了WizardVicunaLM。这个项目是高度实验性的,旨在验证概念,而不是用于实际使用。

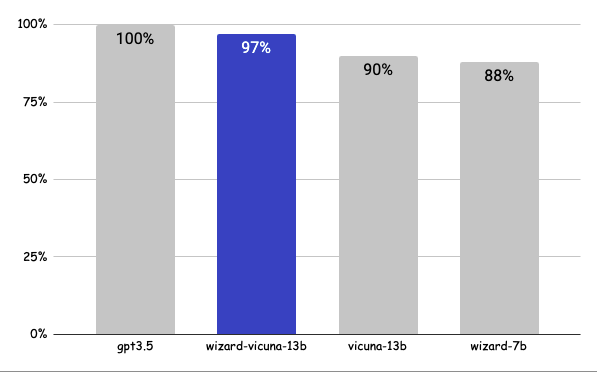

基准测试

相对于VicunaLM提高了约7%的性能。

详细信息

这里呈现的问题不是经过严格测试的,而是我问了几个问题,并要求GPT-4给出评分。比较的模型是ChatGPT 3.5、WizardVicunaLM、VicunaLM和WizardLM,按照这个顺序。

| gpt3.5 | wizard-vicuna-13b | vicuna-13b | wizard-7b | link | |

|---|---|---|---|---|---|

| Q1 | 95 | 90 | 85 | 88 | 12314321 |

| Q2 | 95 | 97 | 90 | 89 | 12315321 |

| Q3 | 85 | 90 | 80 | 65 | 12316321 |

| Q4 | 90 | 85 | 80 | 75 | 12317321 |

| Q5 | 90 | 85 | 80 | 75 | 12318321 |

| Q6 | 92 | 85 | 87 | 88 | 12319321 |

| Q7 | 95 | 90 | 85 | 92 | 12320321 |

| Q8 | 90 | 85 | 75 | 70 | 12321321 |

| Q9 | 92 | 85 | 70 | 60 | 12322321 |

| Q10 | 90 | 80 | 75 | 85 | 12323321 |

| Q11 | 90 | 85 | 75 | 65 | 12324321 |

| Q12 | 85 | 90 | 80 | 88 | 12325321 |

| Q13 | 90 | 95 | 88 | 85 | 12326321 |

| Q14 | 94 | 89 | 90 | 91 | 12327321 |

| Q15 | 90 | 85 | 88 | 87 | 12328321 |

| 91 | 88 | 82 | 80 |

原理

我们采用了WizardLM的方法,即更深入地扩展单个问题。但是,我们没有使用单个指令,而是采用Vicuna的对话格式来进行扩展,并应用Vicuna的微调技术。

我们做的是将单个命令转化为丰富的对话。

在创建训练数据后,我根据Vicuna v1.1进行了训练。

详细方法

首先,我们使用WizardLM创建的7K个对话,通过ChatGPT 3.5以连续对话的格式对同一主题进行了探索和扩展。

之后,我们使用Vicuna的微调格式应用了以下模型。

训练过程

使用8个A100 GPU进行了35小时的训练。

权重

您可以查看我们用于训练的权重 dataset 和huggingface中的 13b model 。

结论

如果我们将对话扩展到gpt4 32K,可以期望有显著的提高,因为我们可以生成8倍更多、更准确和更丰富的对话。

许可证

该模型根据LLaMA模型许可证授权,数据集根据OpenAI条款许可。其他所有内容都是免费的。

作者

JUNE LEE - 他在Songdo人工智能研究和GDG Songdo中非常活跃。