英文

英文Data2Vec-基于文本的模型

使用 data2vec 目标在英语语言上进行预训练的模型。它于 this paper 年提出,并于 this repository 年首次发布。这个模型是区分大小写的:它会区分 english 和 English。

免责声明:发布 Data2Vec-Text 的团队并没有为该模型撰写模型卡片,因此此模型卡片由 Hugging Face 团队撰写。

预训练方法

更多信息,请参阅 official paper 。

摘要

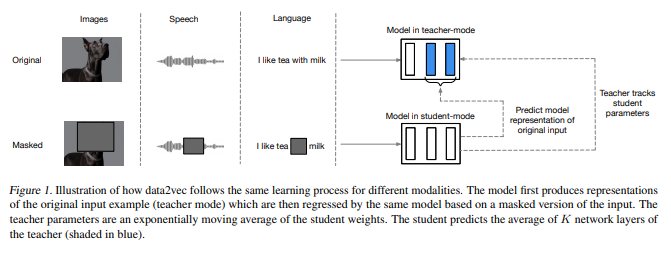

虽然无监督学习的一般思想在各种模态之间是相同的,但实际的算法和目标因为是针对单一模态而开发,所以差异很大。为了使我们更接近于通用的自监督学习,在本文中,我们提出了 data2vec,这是一个框架,可以将相同的学习方法应用于语音、自然语言处理或计算机视觉。核心思想是利用遮蔽视图的输入对完整输入数据的潜在表示进行预测,方法是在自我蒸馏设置中使用标准 Transformer 架构。 data2vec 不是预测局部性质的模态特定目标,如单词、视觉标记或人类语音单位,而是预测包含整个输入信息的情境化潜在表示。在语音识别、图像分类和自然语言理解的主要基准测试上的实验表明,相比于主流方法,取得了新的最先进或竞争性能。

预期使用和限制

该模型旨在在下游任务上进行微调。请参阅 model hub 查找您感兴趣的任务的微调版本。

请注意,该模型主要用于在使用整个句子(可能是遮蔽的)进行决策的任务上进行微调,例如序列分类、标记分类或问答。对于文本生成等任务,您应该查看像 GPT2 这样的模型。

训练数据

RoBERTa 模型在以下五个数据集的重组上进行了预训练:

- BookCorpus ,一个由11,038本未发布的书组成的数据集;

- English Wikipedia (不包括列表、表格和标题);

- CC-News ,一个包含6300万英语新闻文章的数据集,这些文章在2016年9月至2019年2月期间抓取;

- OpenWebText ,用于训练 GPT-2 的 WebText 数据集的开源重现;

- Stories ,一个包含了与 Winograd schema 故事风格匹配的 CommonCrawl 数据子集的数据集。

这些数据集总共包含160GB的文本。

BibTeX 条目和引用信息

@misc{https://doi.org/10.48550/arxiv.2202.03555,

doi = {10.48550/ARXIV.2202.03555},

url = {https://arxiv.org/abs/2202.03555},

author = {Baevski, Alexei and Hsu, Wei-Ning and Xu, Qiantong and Babu, Arun and Gu, Jiatao and Auli, Michael},

keywords = {Machine Learning (cs.LG), FOS: Computer and information sciences, FOS: Computer and information sciences},

title = {data2vec: A General Framework for Self-supervised Learning in Speech, Vision and Language},

publisher = {arXiv},

year = {2022},

copyright = {arXiv.org perpetual, non-exclusive license}

}