模型:

google/t5-large-ssm

英文

英文Google's T5 对于闭卷问题回答。

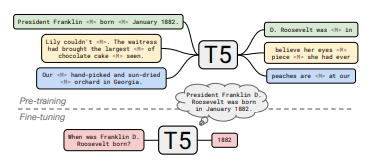

该模型在 C4 上使用T5的去噪目标进行了预训练,并在 Wikipedia 上使用了 REALM 的显著跨度掩蔽目标进行了额外的预训练。

注意:在将其用于闭卷问题回答之前,该模型应该在一个问题回答下游任务上进行微调。

其他社区检查点: here

论文: How Much Knowledge Can You Pack Into the Parameters of a Language Model?

作者:Adam Roberts, Colin Raffel, Noam Shazeer

摘要

最近有观察到,在未结构化文本上训练的神经语言模型可以使用自然语言查询隐式地存储和检索知识。在这篇短文中,我们通过对预训练模型进行微调来衡量这种方法的实用性,以便在没有任何外部上下文或知识的情况下回答问题。我们展示了这种方法随着模型规模的增大而扩展,并且在回答问题时与明确从外部知识源检索答案的开放领域系统竞争力相当。为了便于重现和未来的工作,我们在 https://goo.gle/t5-cbqa 上发布了我们的代码和训练模型。