模型:

microsoft/git-large-msrvtt-qa

英文

英文GIT (GenerativeImage2Text),大规模数据集在MSRVTT-QA上微调

GIT(GenerativeImage2Text)模型,大规模版本,在MSRVTT-QA上进行了微调。这个模型在王等人的论文 GIT: A Generative Image-to-text Transformer for Vision and Language 中被介绍,并在 this repository 中首次发布。

免责声明:发布GIT模型的团队没有为该模型编写模型卡片,所以这个模型卡片是由Hugging Face团队编写的。

模型描述

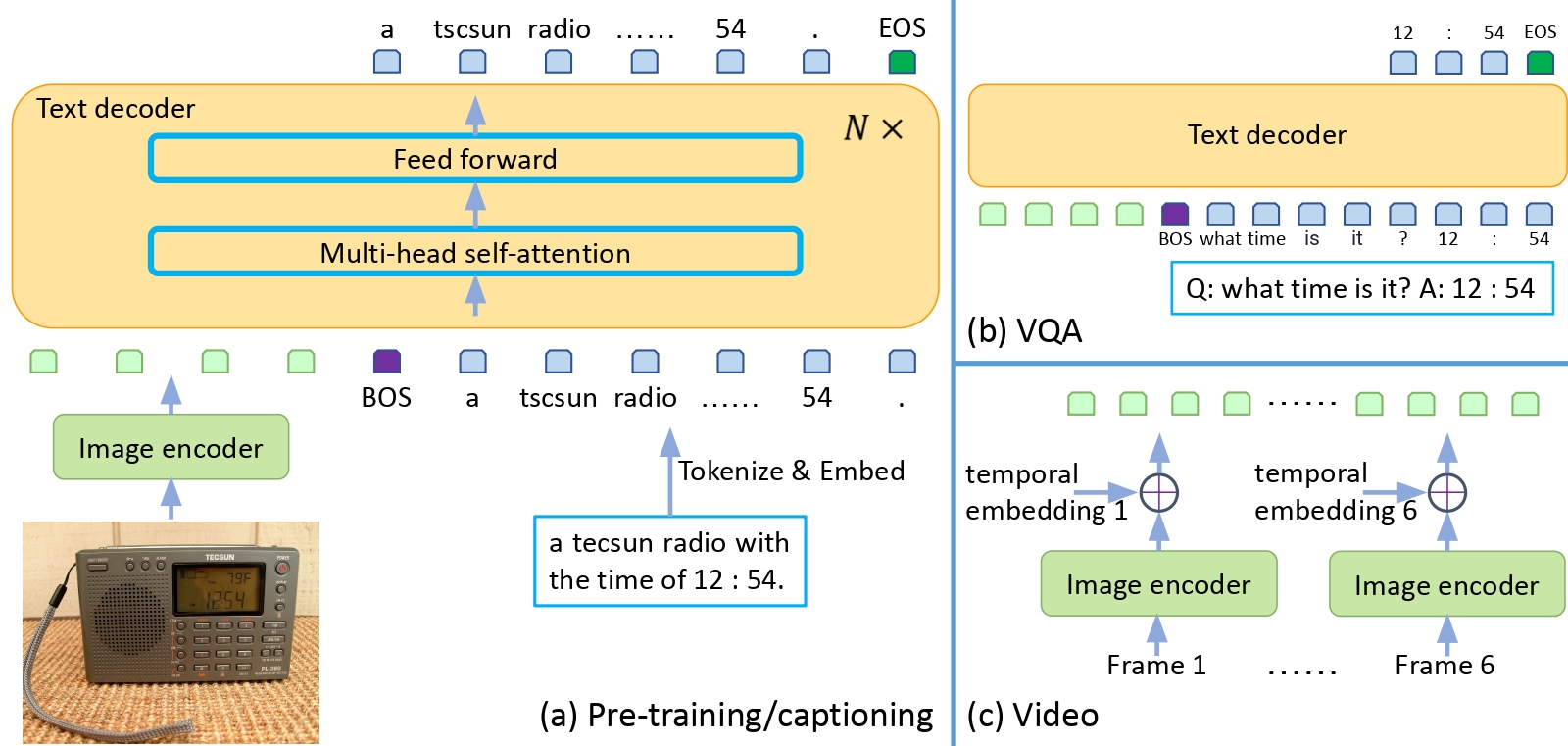

GIT是一个Transformer解码器,它以CLIP图像令牌和文本令牌为条件。该模型使用“teacher forcing”在大量(图像、文本)对上进行训练。

模型的目标只是给定图像令牌和先前的文本令牌来预测下一个文本令牌。

模型可以完全访问(即用于)图像补丁令牌,但只能在预测下一个文本令牌时访问先前的文本令牌(即使用因果关注掩码)。

这使得模型可以用于以下任务:

- 图像和视频字幕

- 图像和视频的视觉问答(VQA)

- 甚至图像分类(只需将模型与图像相关联,并要求它生成相应的文本类别)。

预期用途和限制

您可以使用原始模型进行视频问答(QA)。查看 model hub 以查找您感兴趣的任务的微调版本。

如何使用

关于代码示例,我们参考 documentation 。

训练数据

来自论文:

我们收集了80亿个图像-文本对进行预训练,其中包括COCO(Lin等,2014),Conceptual Captions(CC3M)(Sharma等,2018),SBU(Ordonez等,2011),Visual Genome (VG)(Krishna等,2016),Conceptual Captions (CC12M)(Changpinyo等,2021),ALT200M(Hu等,2021a),以及根据Hu等(2021a)中的类似收集过程,额外的0.6B数据。

=> 但是,这是论文中提到的名为“GIT”的模型,该模型不是开源的。

该检查点是“GIT-base”,它是在1000万个图像-文本对上训练的GIT的较小变种。

接下来,该模型在MSRVTT-QA上进行了微调。

在 paper 中的表11中可查看更多详细信息。

预处理

关于训练期间的预处理详细信息,请参考原始存储库。

在验证期间,将调整图像的较短边,然后进行居中裁剪以达到固定分辨率。接下来,帧在RGB通道上进行了ImageNet均值和标准差的归一化。

评估结果

有关评估结果,请参阅 paper 。