模型:

microsoft/unispeech-sat-base-plus

英文

英文UniSpeech-SAT-Base

基于16kHz采样的语音音频进行预训练的基础模型,使用该模型时,请确保语音输入也采样为16kHz。

注意:该模型没有分词器,因为它仅在音频上进行了预训练。为了使用该模型进行语音识别,应当创建一个分词器,并在标记的文本数据上对模型进行微调。请参阅 this blog 以获取更详细的如何微调模型的说明。

该模型进行了预训练,使用的数据包括:

- 60,000小时的 Libri-Light

- 10,000小时的 GigaSpeech

- 24,000小时的 VoxPopuli

Paper: UNISPEECH-SAT: UNIVERSAL SPEECH REPRESENTATION LEARNING WITH SPEAKER AWARE PRE-TRAINING

作者:Sanyuan Chen、Yu Wu、Chengyi Wang、Zhengyang Chen、Zhuo Chen、Shujie Liu、Jian Wu、Yao Qian、Furu Wei、Jinyu Li、Xiangzhan Yu

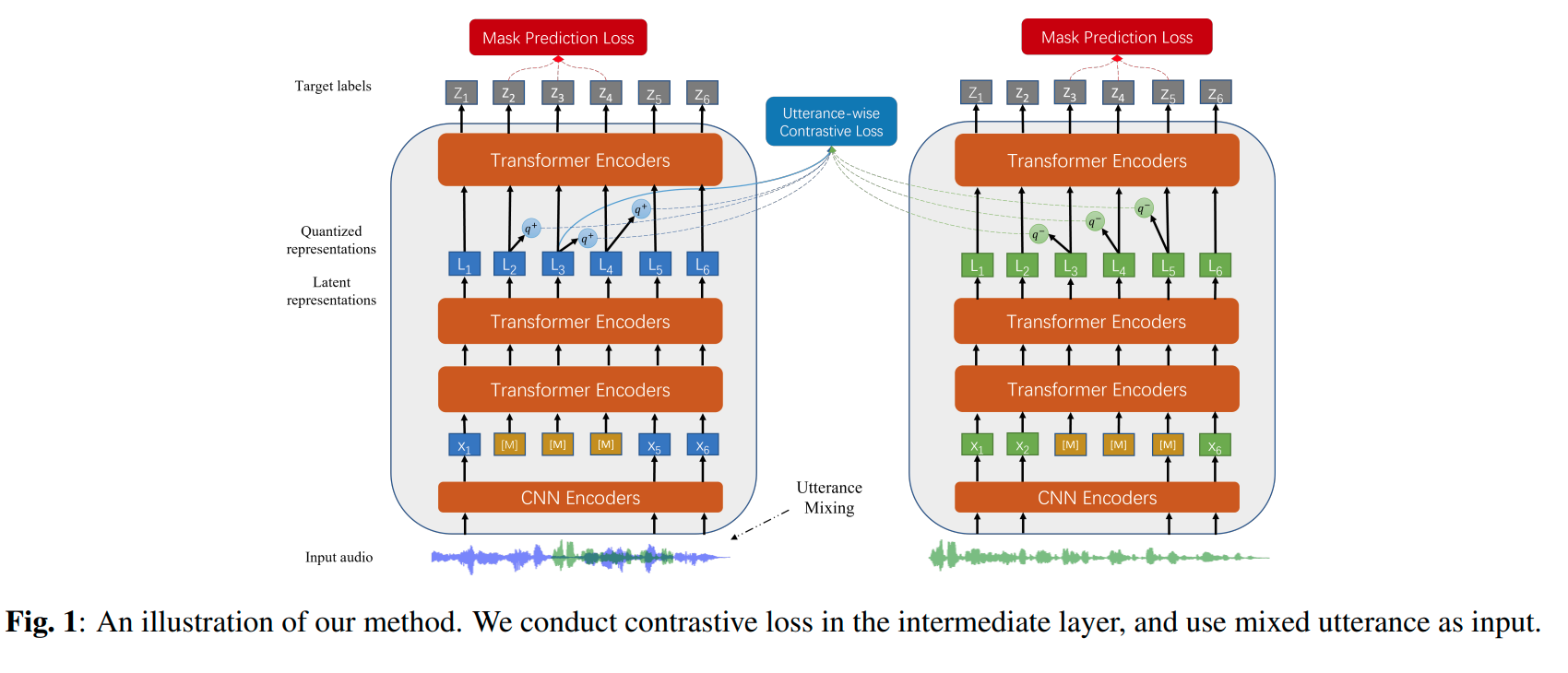

摘要 自我监督学习(SSL)一直是语音处理的一个长期目标,因为它利用大规模无标注数据并避免了大量的人工标注。近年来,在语音识别中应用自我监督学习取得了很大成功,但在应用SSL进行建模说话人特征方面的探索很有限。本文旨在改进现有的SSL框架用于说话人表示学习。我们提出了两种方法来增强无监督说话人信息提取。首先,我们将多任务学习应用于当前的SSL框架,将话语层面的对比损失与SSL目标函数进行集成。其次,为了更好地进行说话人辨别,我们提出了一种话语混合策略进行数据增强,即在训练过程中无监督创建重叠的话语,并将其融入训练中。我们将这些方法整合到HuBERT框架中。在SUPERB基准测试上的实验结果表明,所提出的系统在通用表示学习方面达到了最先进的性能,尤其是针对说话人识别任务。我们进行了消融研究,验证了每种提出方法的有效性。最后,我们将训练数据扩大到94,000小时的公共音频数据,并在所有SUPERB任务中进一步提高了性能..

可在 https://github.com/microsoft/UniSpeech/tree/main/UniSpeech-SAT 下找到原始模型。

用法

这是一个英文预训练的语音模型,在可以用于推断之前,必须对其进行下游任务(如语音识别或音频分类)微调。该模型在英文上进行了预训练,因此应仅在英文上表现良好。该模型在扬声器验证、扬声器识别和言者分化等任务上表现良好。

注意:该模型是基于音素而不是字符进行预训练的。这意味着在微调之前,应确保将输入文本转换为音素序列。

语音识别

要对该模型进行语音识别的微调,请参阅 the official speech recognition example 。

语音分类

要对该模型进行语音分类的微调,请参阅 the official audio classification example 。

扬声器验证

待办

扬声器分化

待办

贡献

该模型由 cywang 和 patrickvonplaten 贡献。

许可证

可在 here 中找到官方许可证。