模型:

pierreguillou/whisper-medium-french

英文

英文French Medium Whisper

此模型是在common_voice_11_0数据集上对 openai/whisper-medium 进行微调的版本。在评估集上实现了以下结果:

- Loss: 0.2664

- Wer (without normalization): 15.8969

- Wer (with normalization): 11.1406

Blog文章

此模型的所有信息请参阅此博文。

新的SOTA

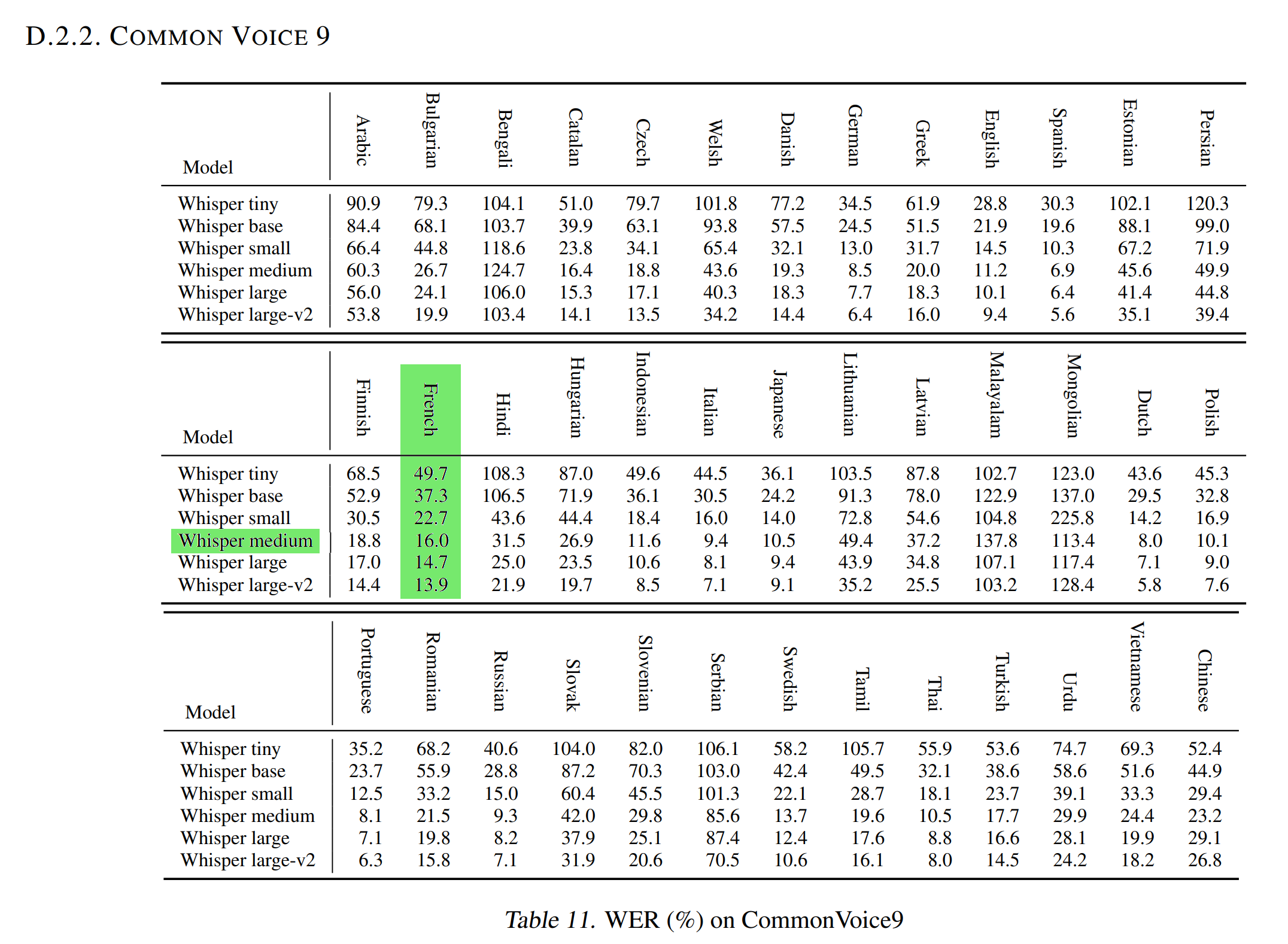

在 Common Voice 9.0 测试数据集上,归一化的WER为16.0。

由于此测试数据集与用于评估我们的模型的 Common Voice 11.0 测试数据集类似(WER和归一化WER),这意味着我们的法语中型Whisper模型在将法语音频转录为文本方面优于 Medium Whisper 模型。

训练过程

训练超参数

训练期间使用了以下超参数:

- learning_rate: 1e-05

- train_batch_size: 32

- eval_batch_size: 16

- seed: 42

- optimizer: Adam with betas=(0.9,0.999) and epsilon=1e-08

- lr_scheduler_type: linear

- lr_scheduler_warmup_steps: 500

- training_steps: 5000

- mixed_precision_training: Native AMP

训练结果

| Training Loss | Epoch | Step | Validation Loss | Wer | Wer Norm |

|---|---|---|---|---|---|

| 0.2695 | 0.2 | 1000 | 0.3080 | 17.8083 | 12.9791 |

| 0.2099 | 0.4 | 2000 | 0.2981 | 17.4792 | 12.4242 |

| 0.1978 | 0.6 | 3000 | 0.2864 | 16.7767 | 12.0913 |

| 0.1455 | 0.8 | 4000 | 0.2752 | 16.4597 | 11.8966 |

| 0.1712 | 1.0 | 5000 | 0.2664 | 15.8969 | 11.1406 |

框架版本

- Transformers 4.26.0.dev0

- Pytorch 1.13.0+cu117

- Datasets 2.7.1.dev0

- Tokenizers 0.13.2